文档

- 1: 介绍

- 2: 快速入门

- 3: 部署指南

- 3.1: 部署环境要求

- 3.2: All In One 部署与卸载

- 3.2.1: All In One 最小化部署

- 3.2.2: KubeCube 卸载

- 3.3: 在已有K8s上安装KubeCube

- 3.3.1: 通过helm安装KubeCube

- 3.3.2: 通过helm纳管计算集群

- 3.4: 使用 hotplug 进行拓展

- 3.4.1: 热插拔 hotplug 介绍

- 3.4.2: 通过 hotplug 启用 loggie

- 3.5: 使用脚本安装 K8s 和 KubeCube(已废弃)

- 3.5.1: 在已有k8s集群中部署KubeCube

- 3.5.2: 添加计算集群

- 3.5.3: 添加节点

- 3.5.4: 多节点高可用部署

- 3.6: 已有系统接入

- 3.6.1: Prometheus

- 3.6.2: ElasticSearch

- 3.6.3: 第三方认证系统

- 4: 产品使用指南

- 4.1: 运维管理

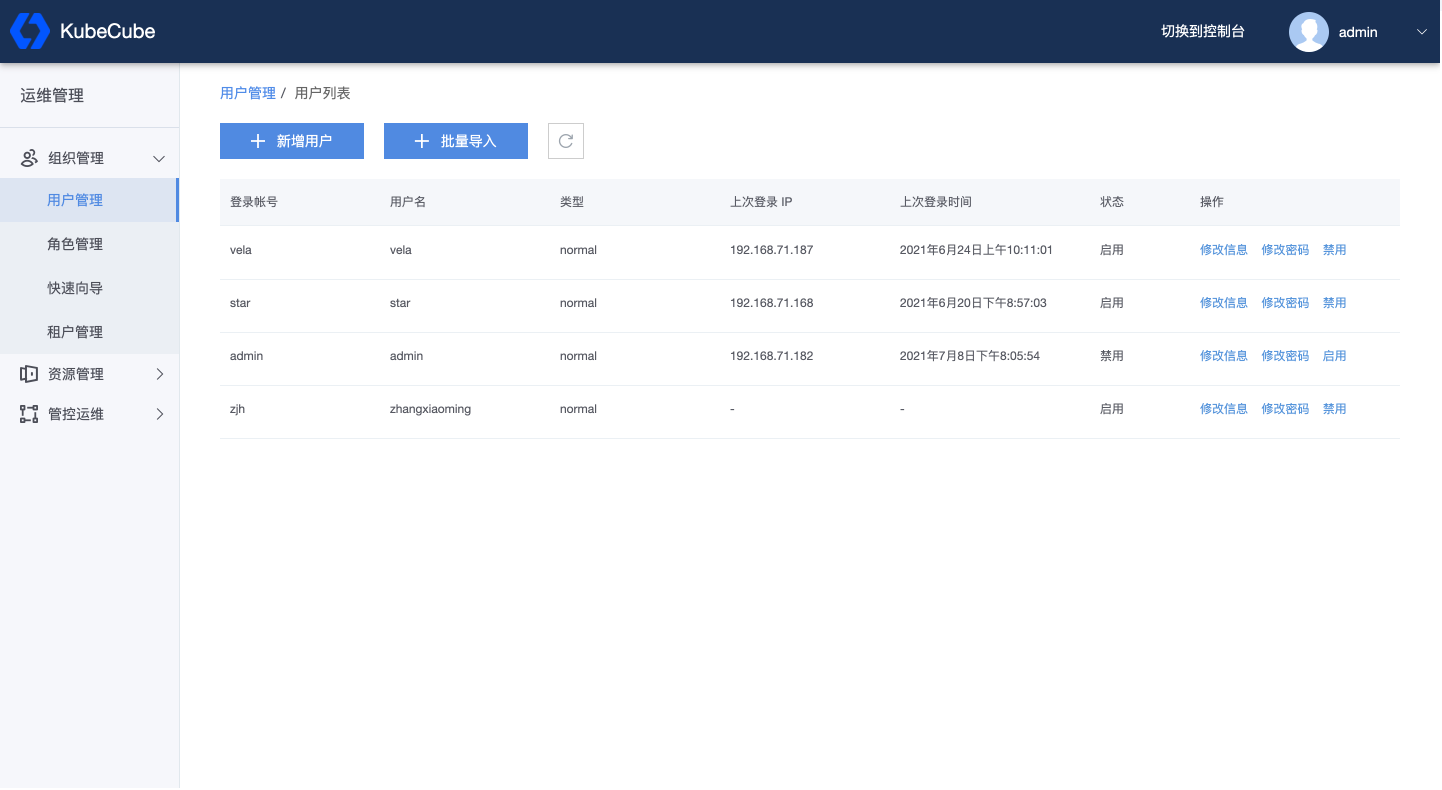

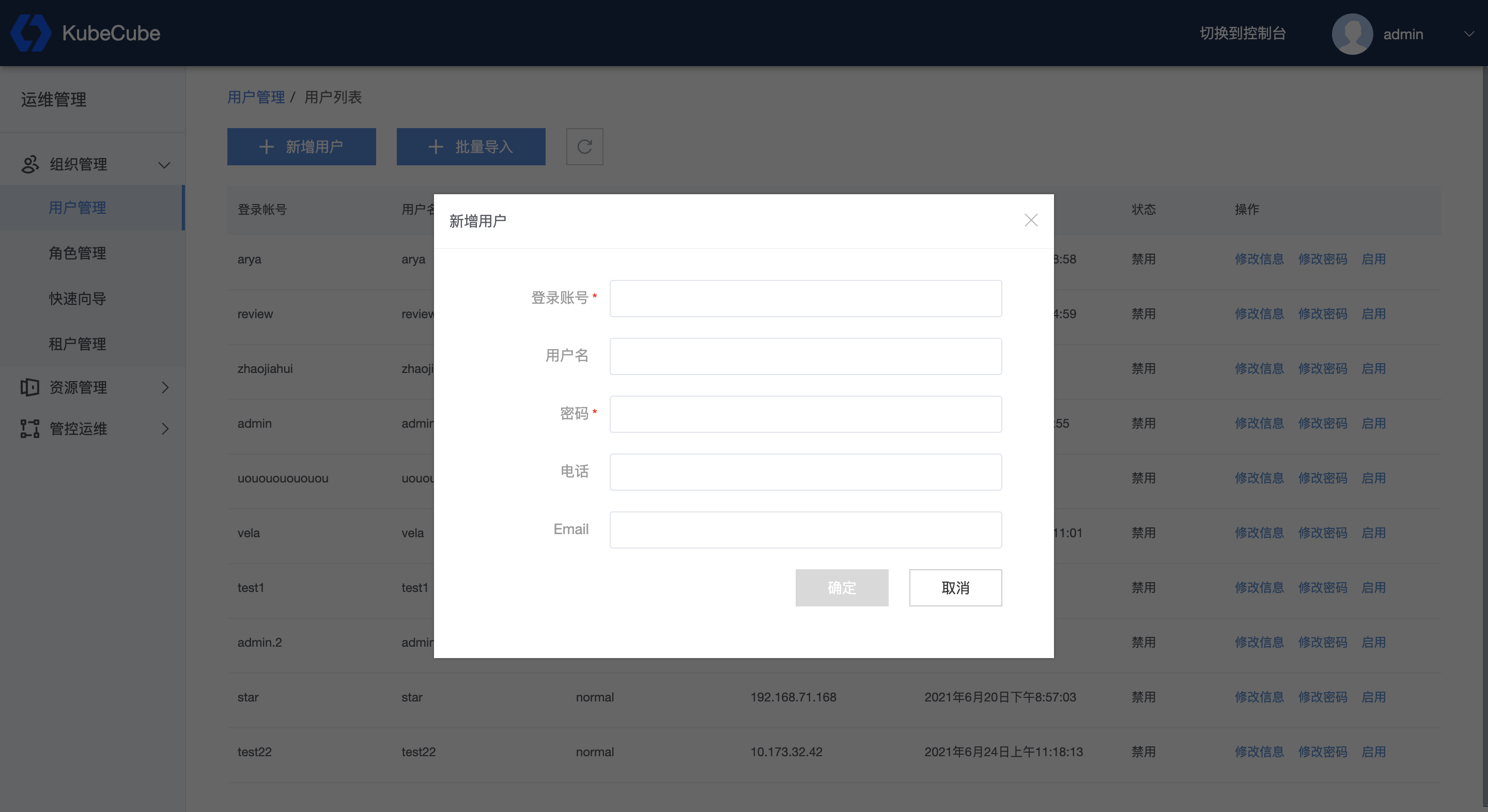

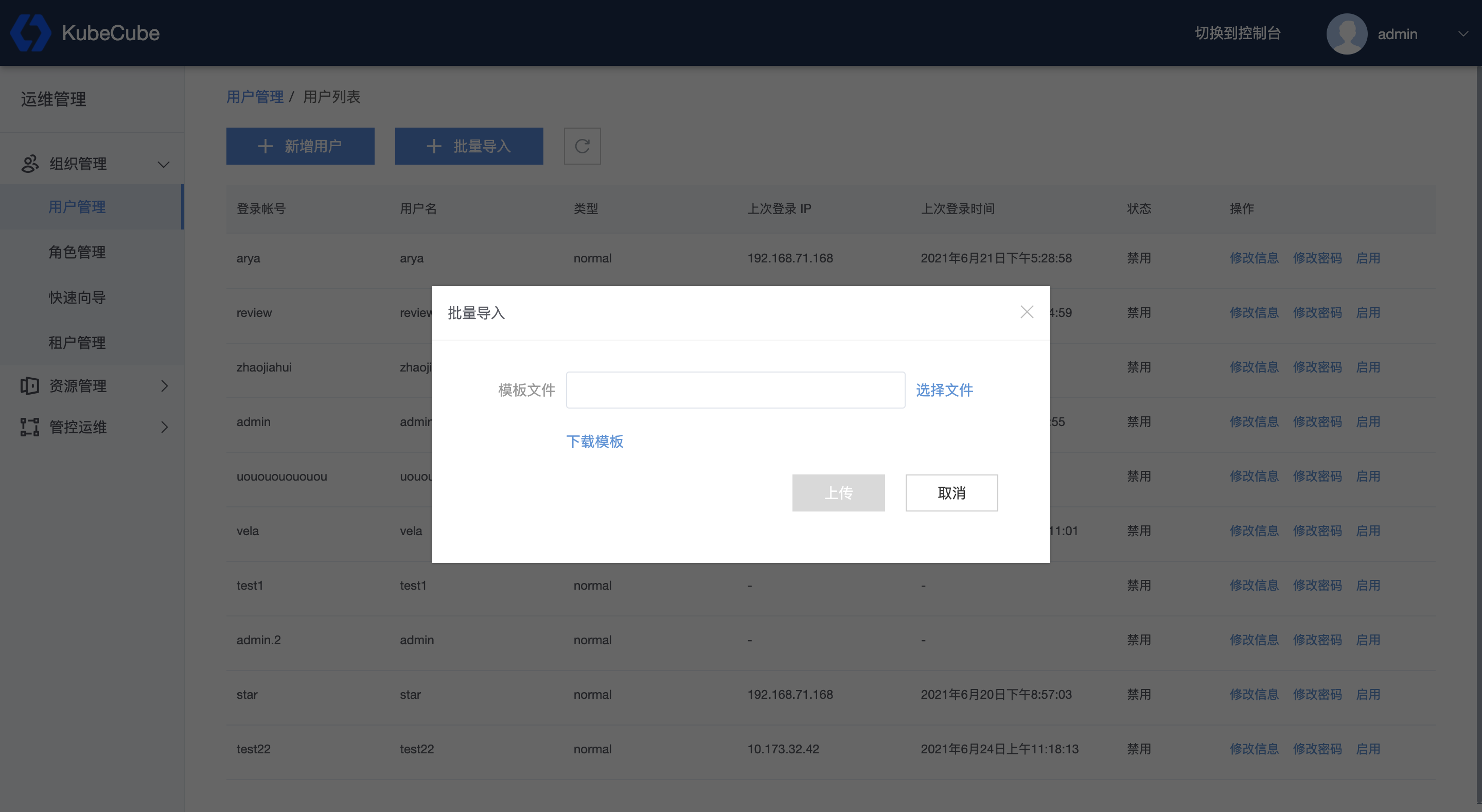

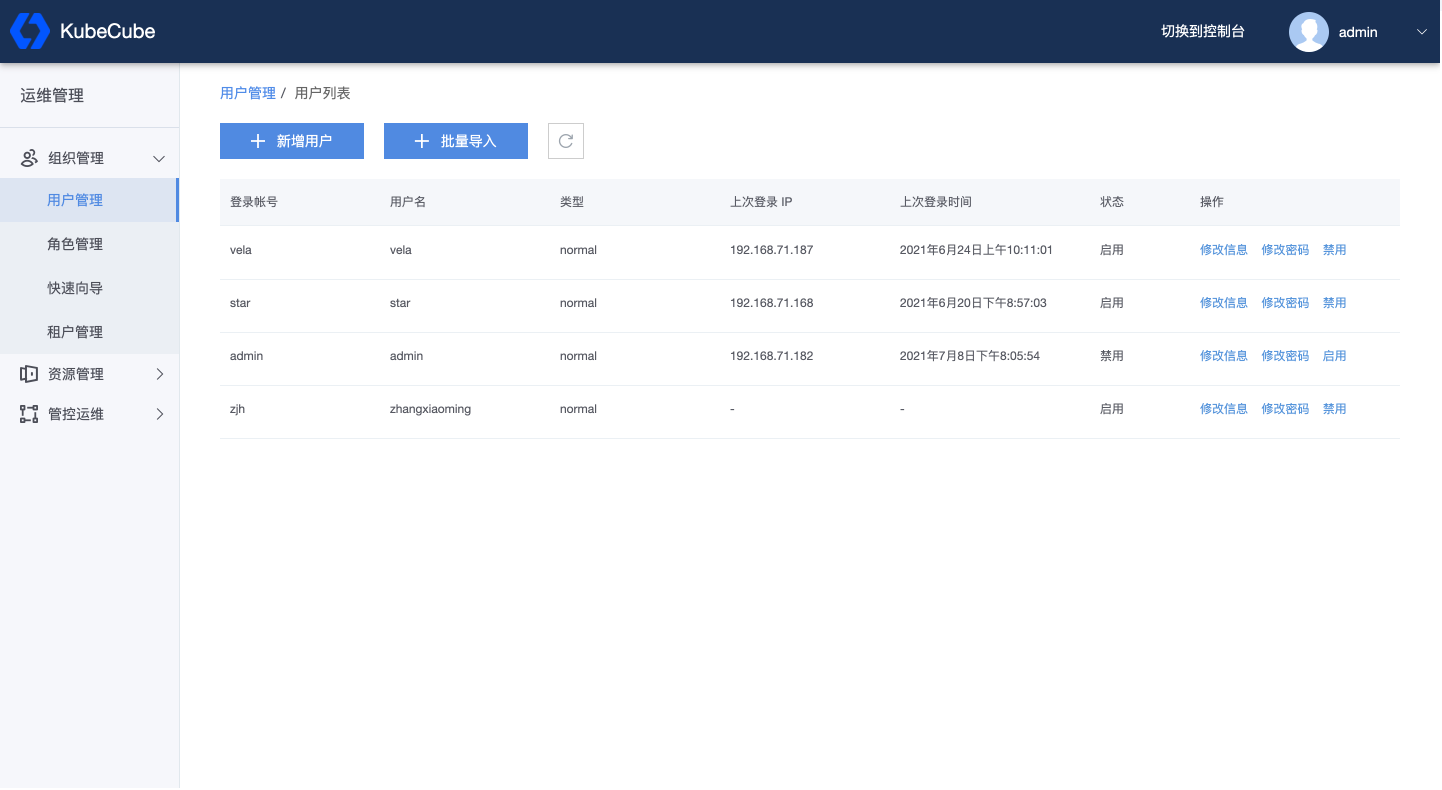

- 4.1.1: 用户管理

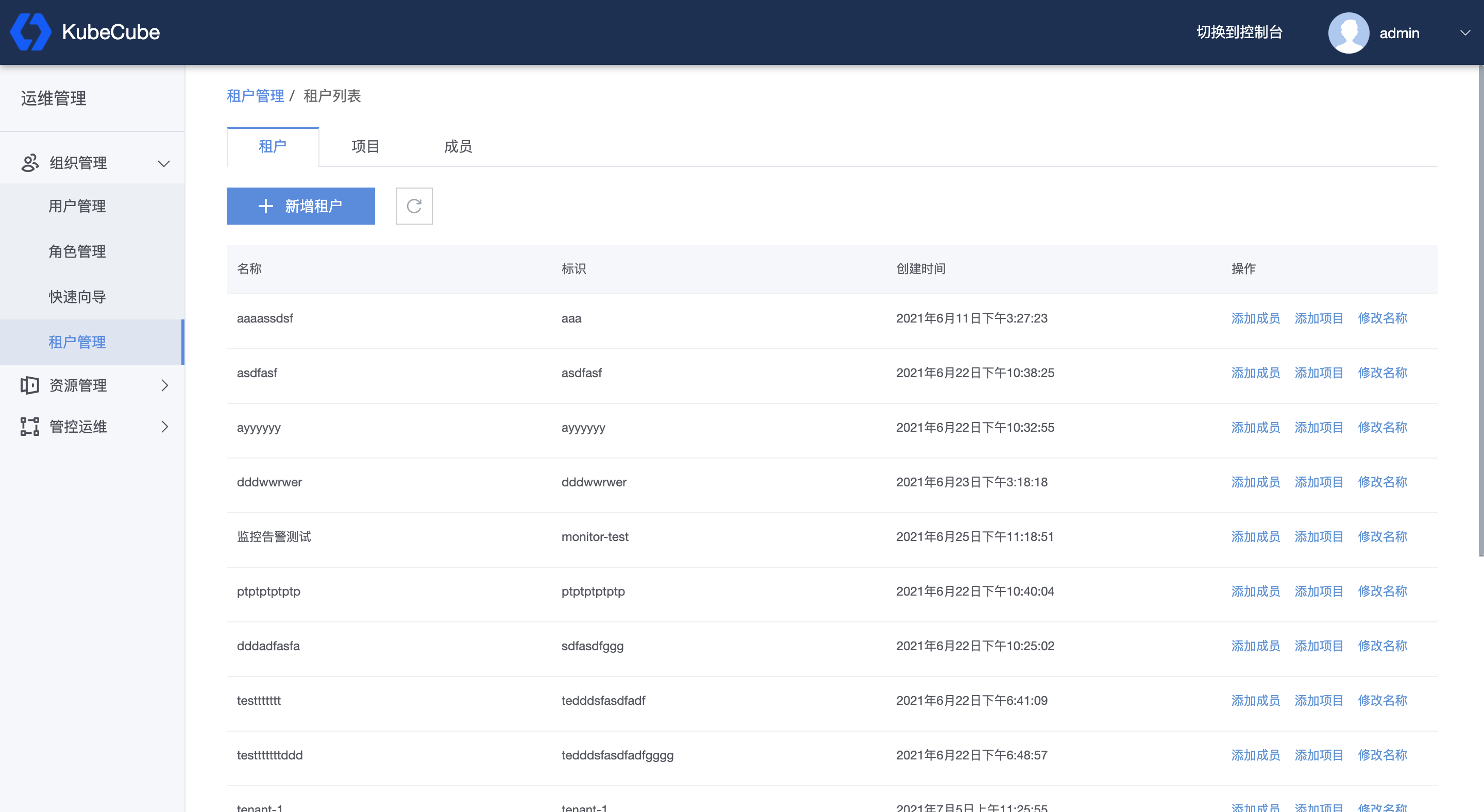

- 4.1.2: 租户管理

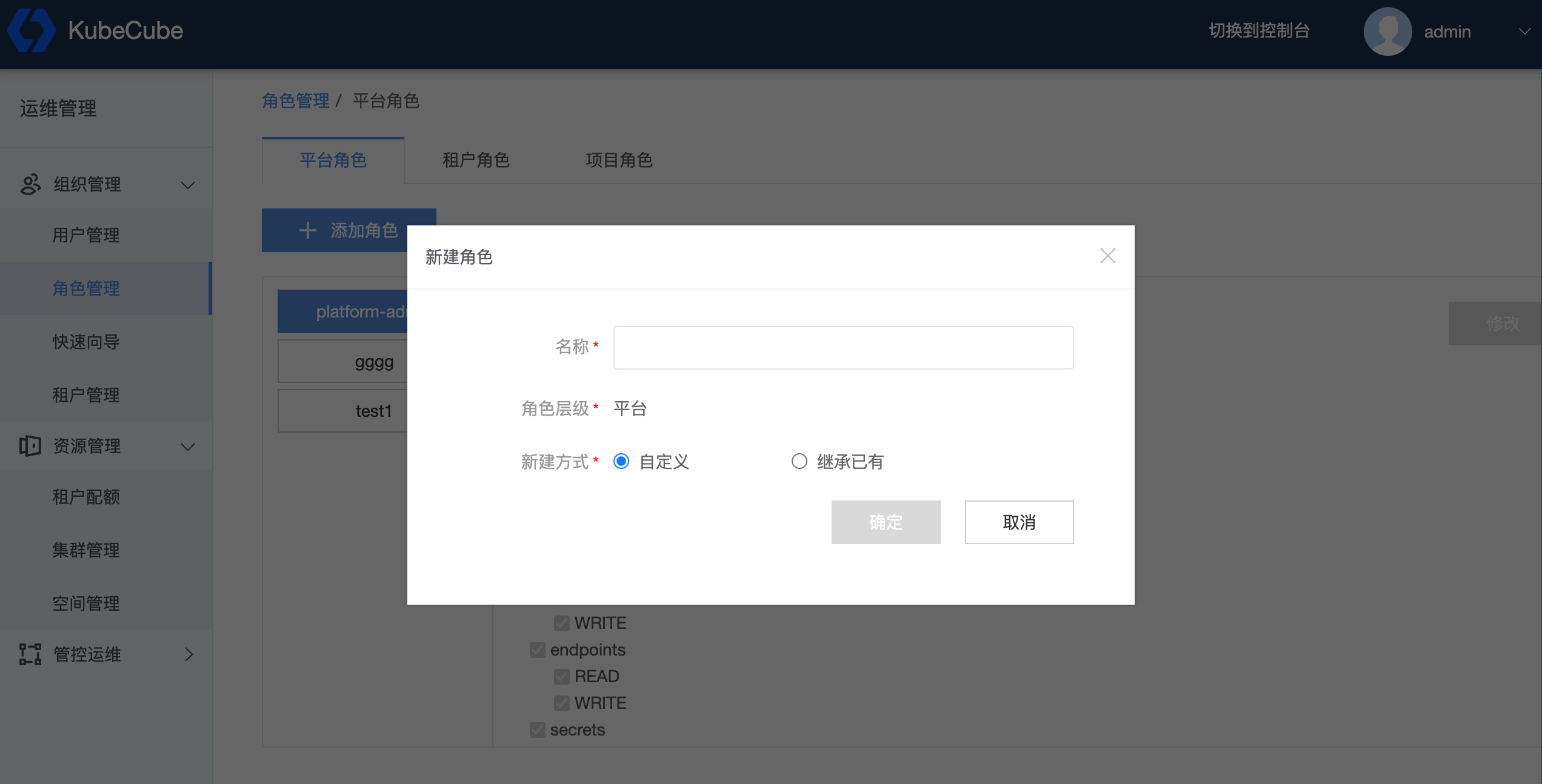

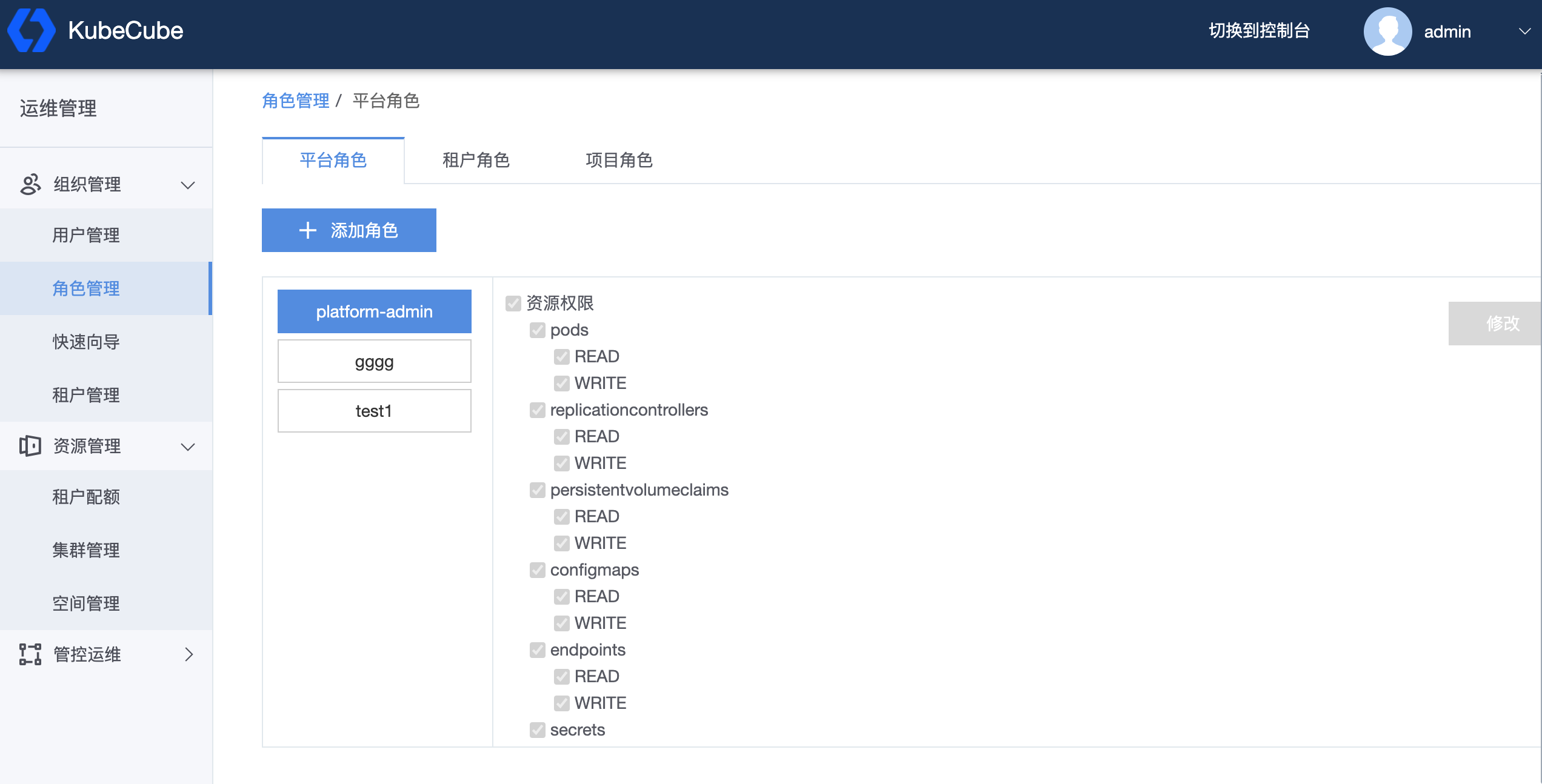

- 4.1.3: 角色管理

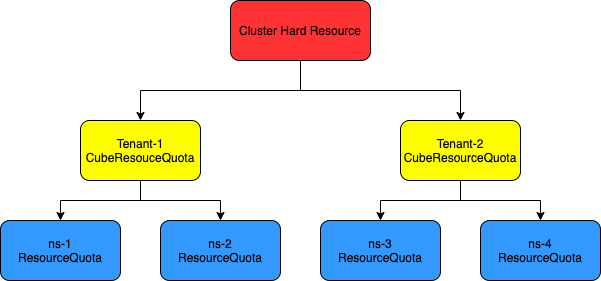

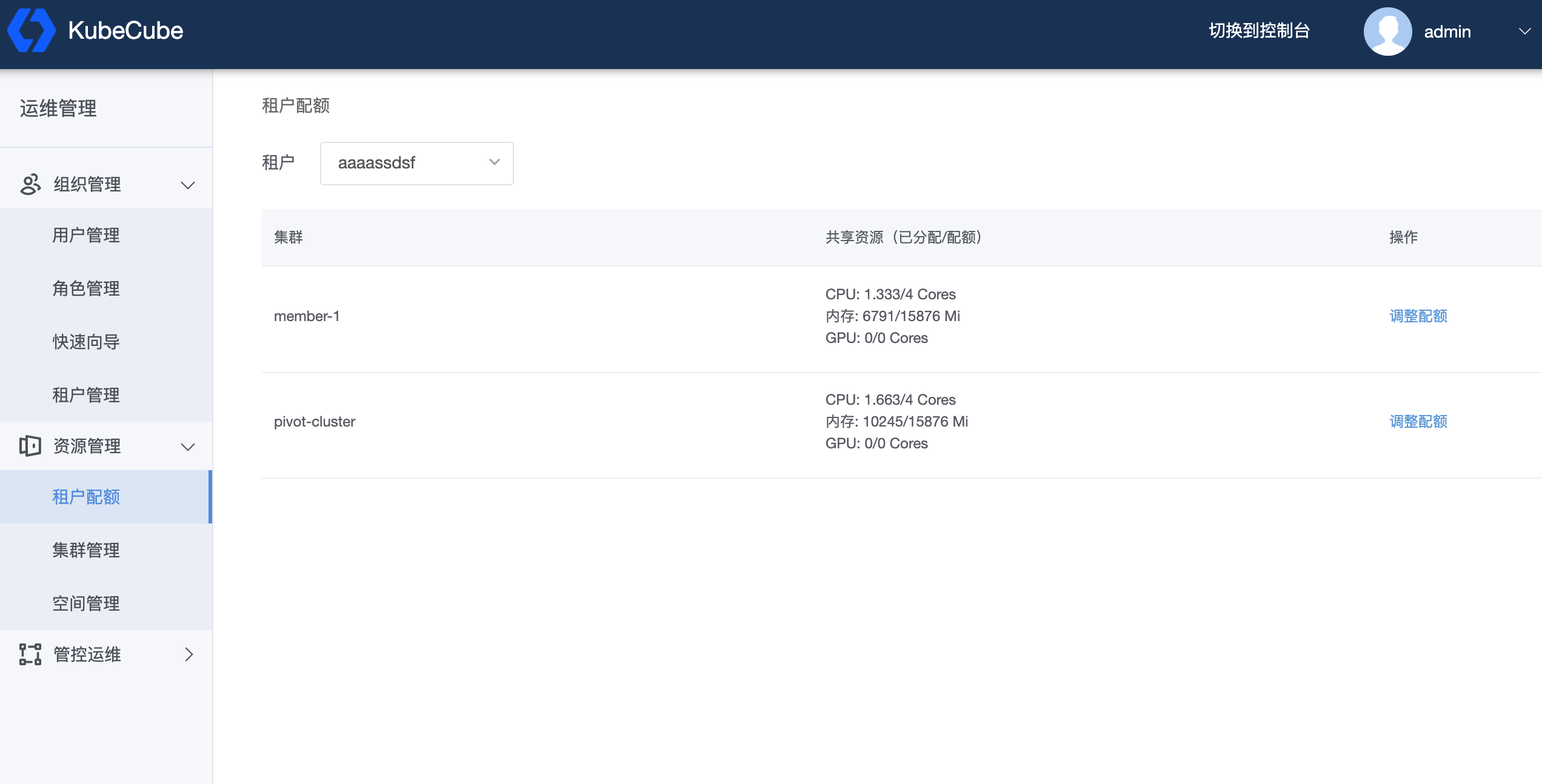

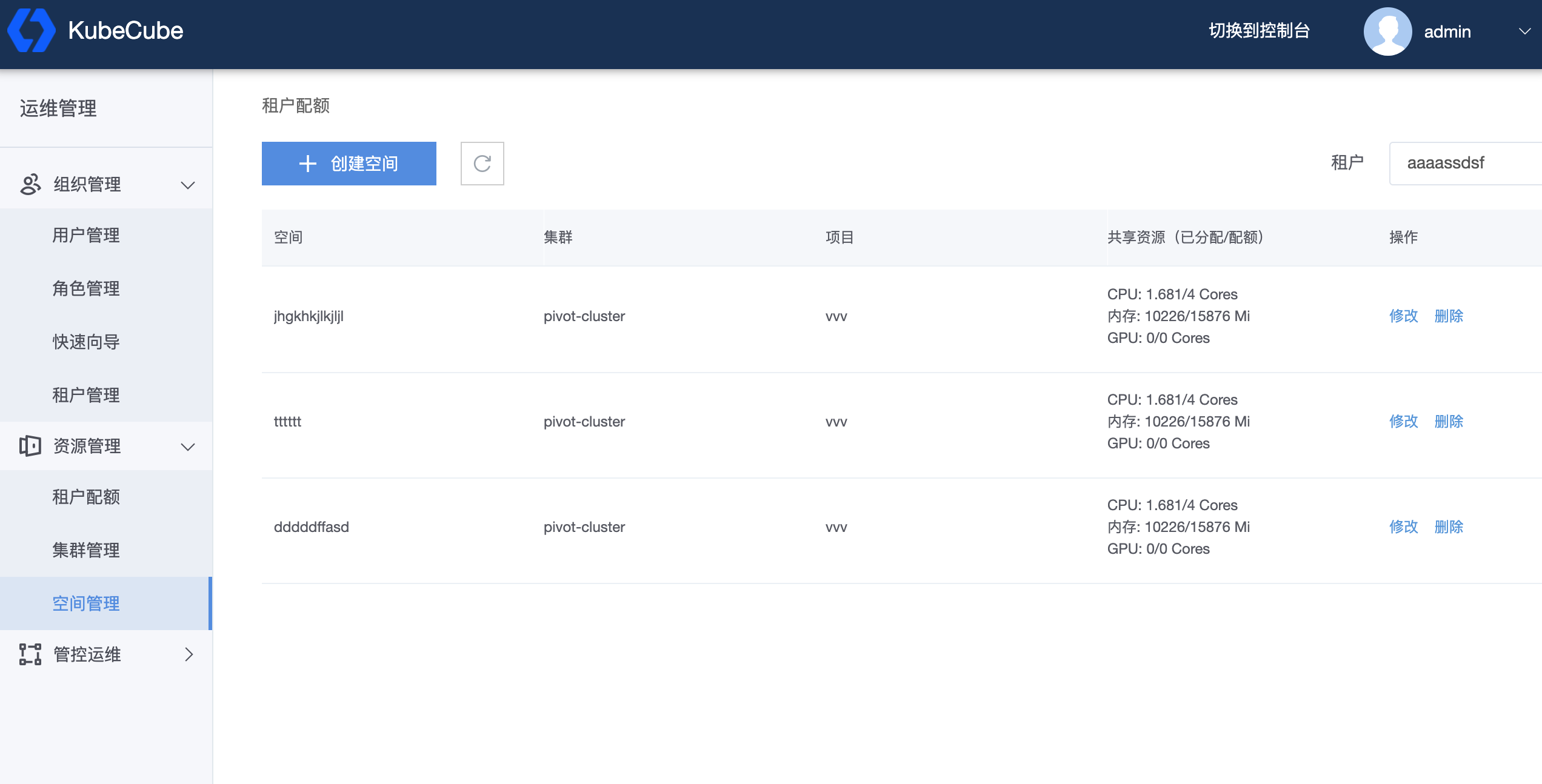

- 4.1.4: 配额管理

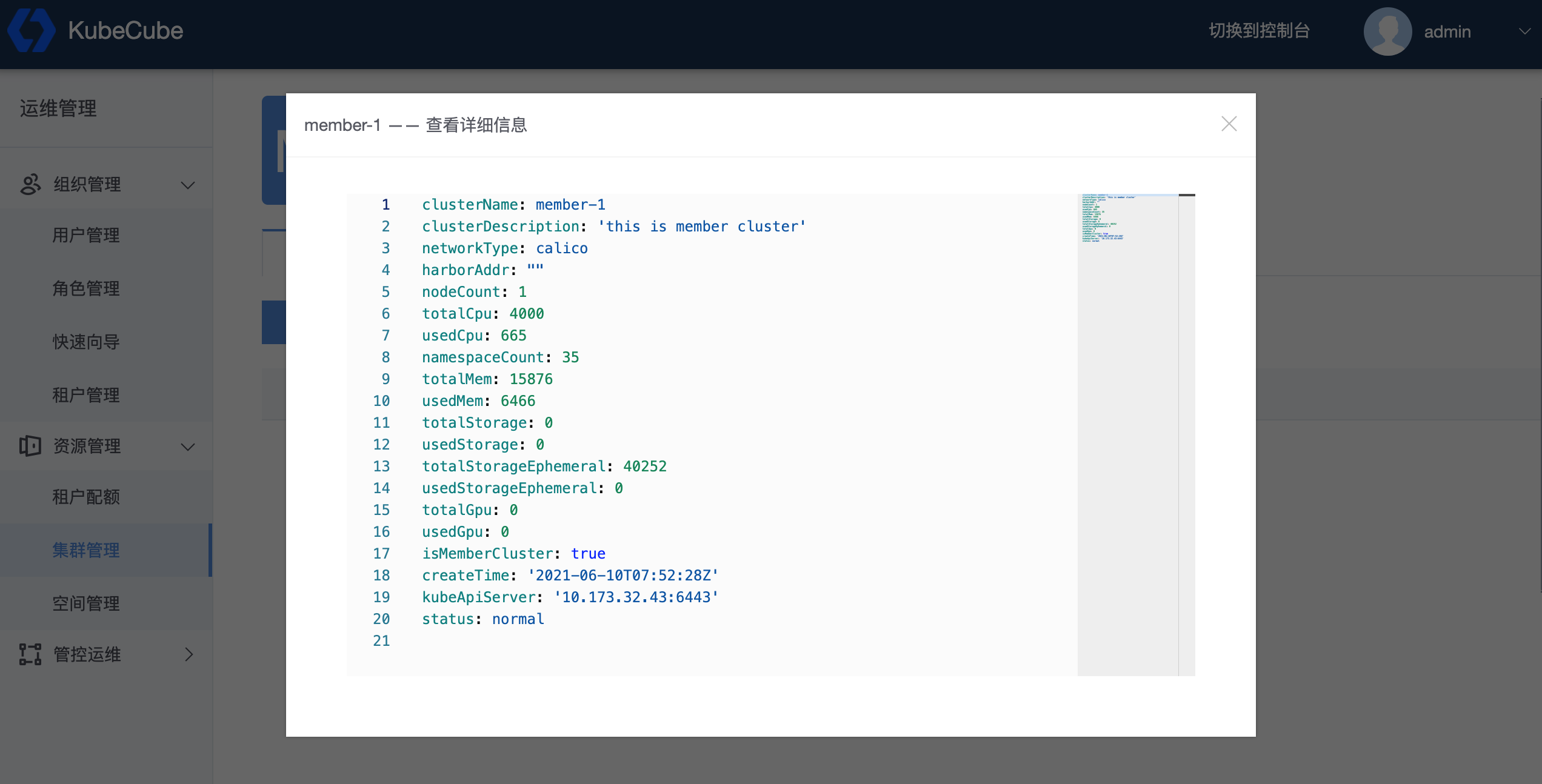

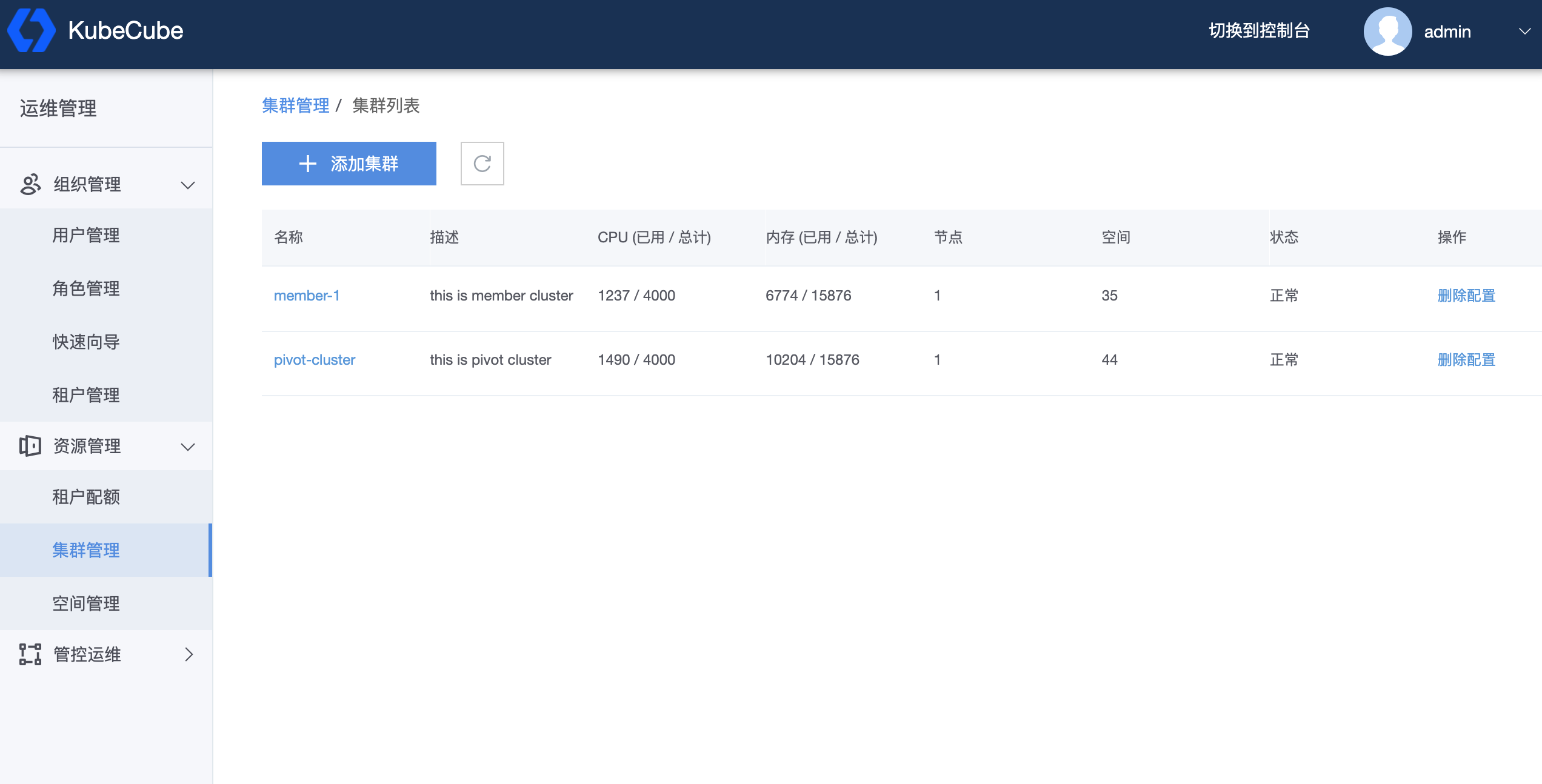

- 4.1.5: K8s集群管理

- 4.1.5.1: 多集群管理

- 4.1.5.2: 集群级资源管理

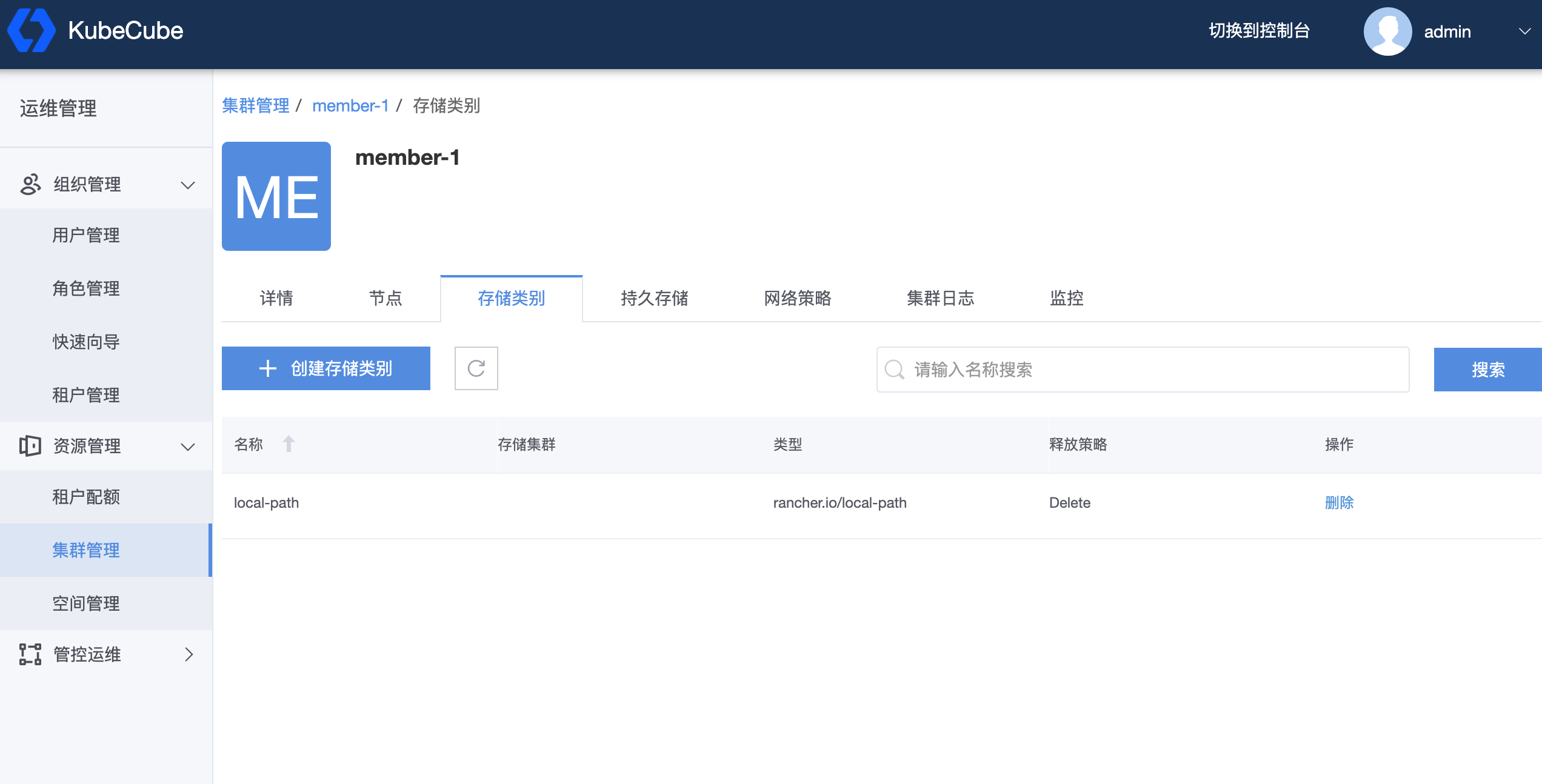

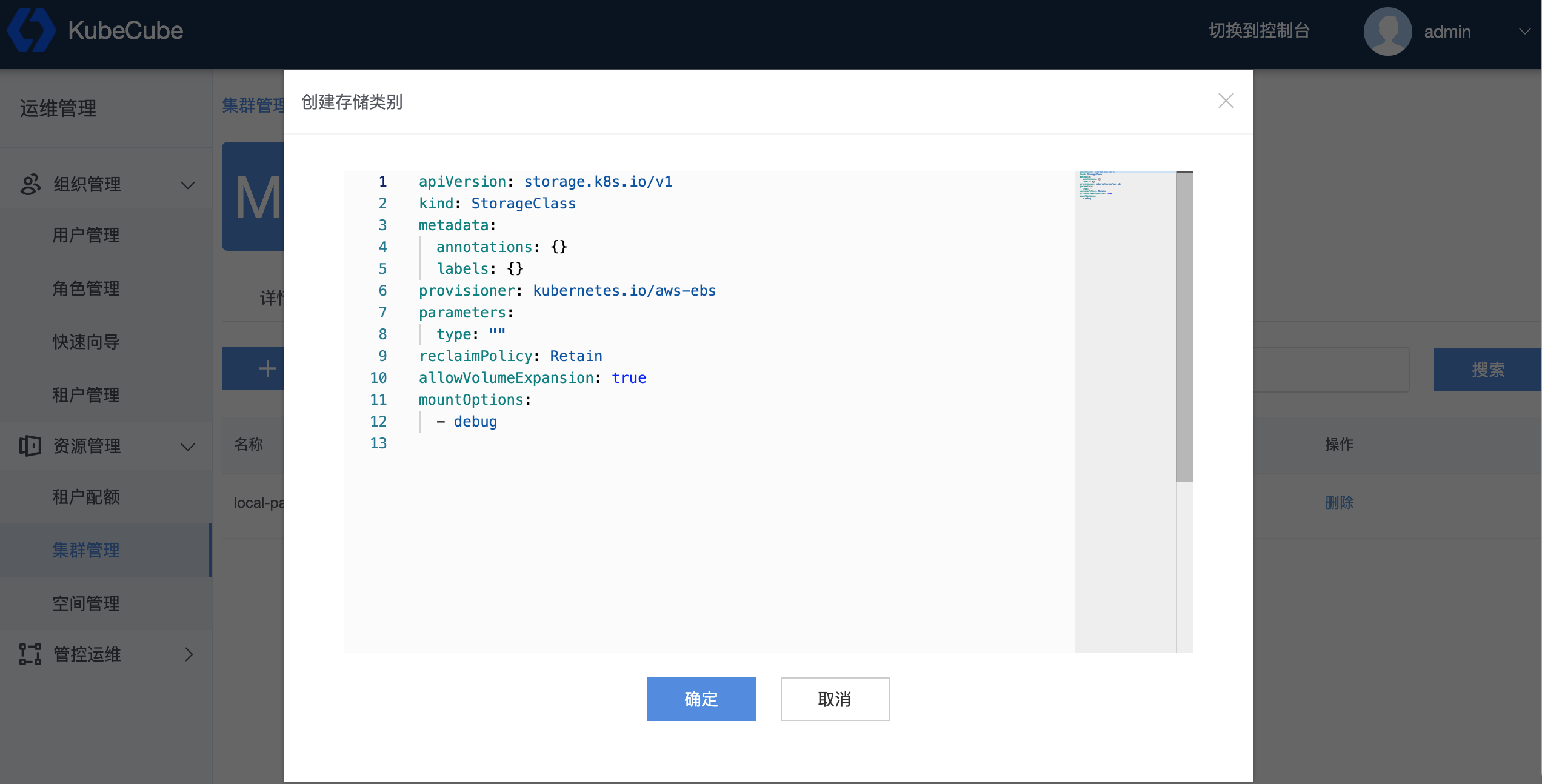

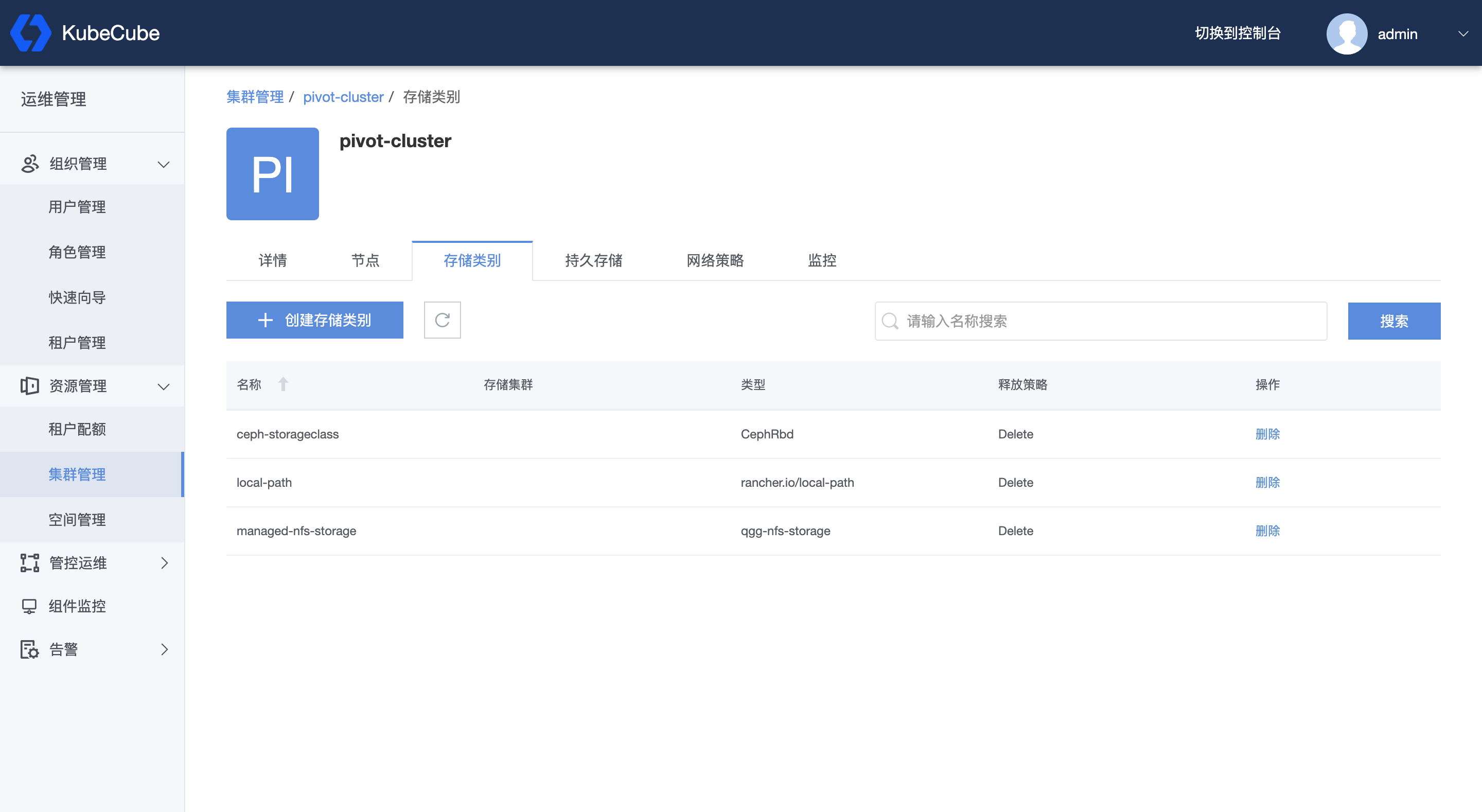

- 4.1.5.2.1: 存储类别(StorageClass)

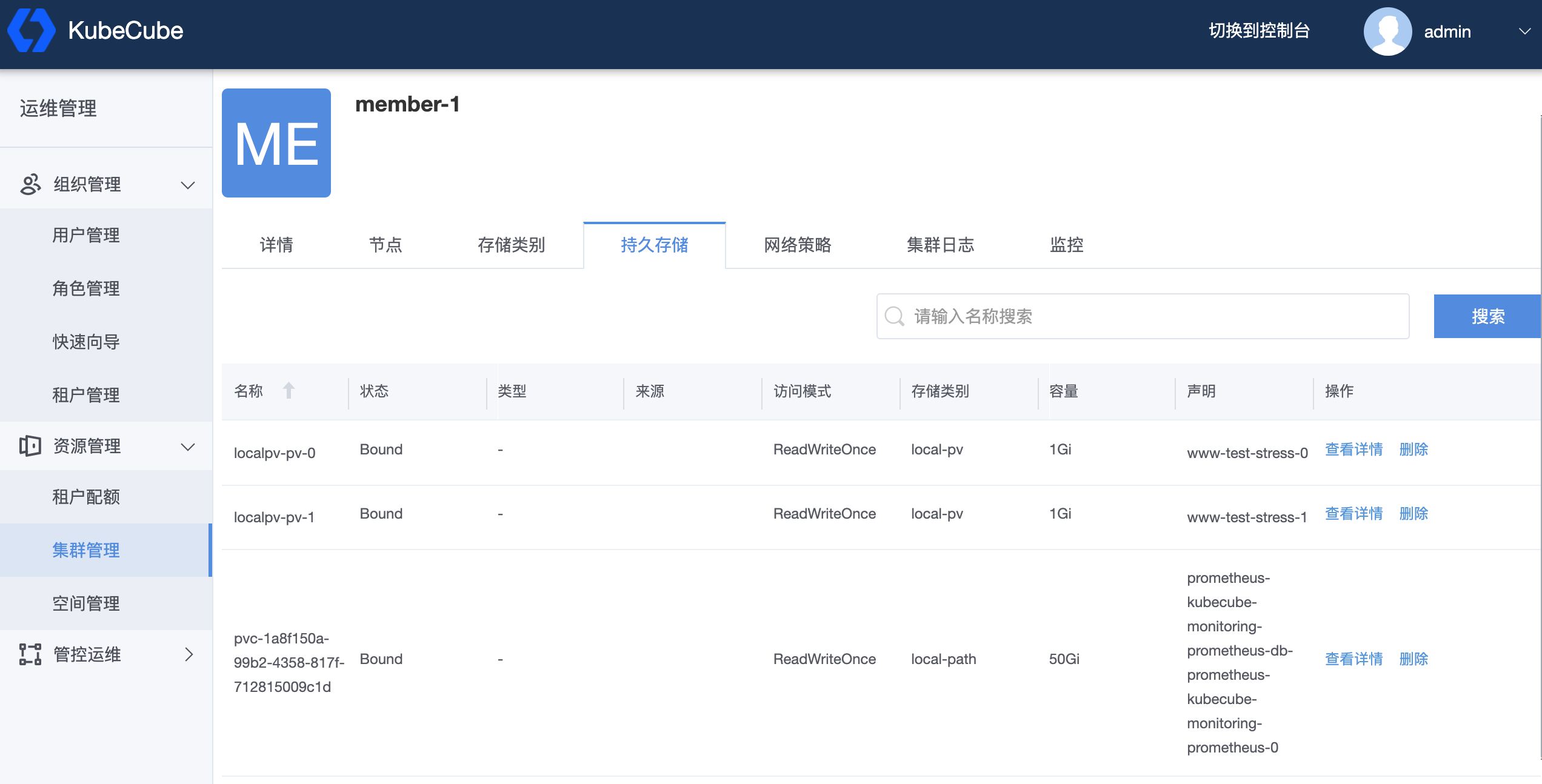

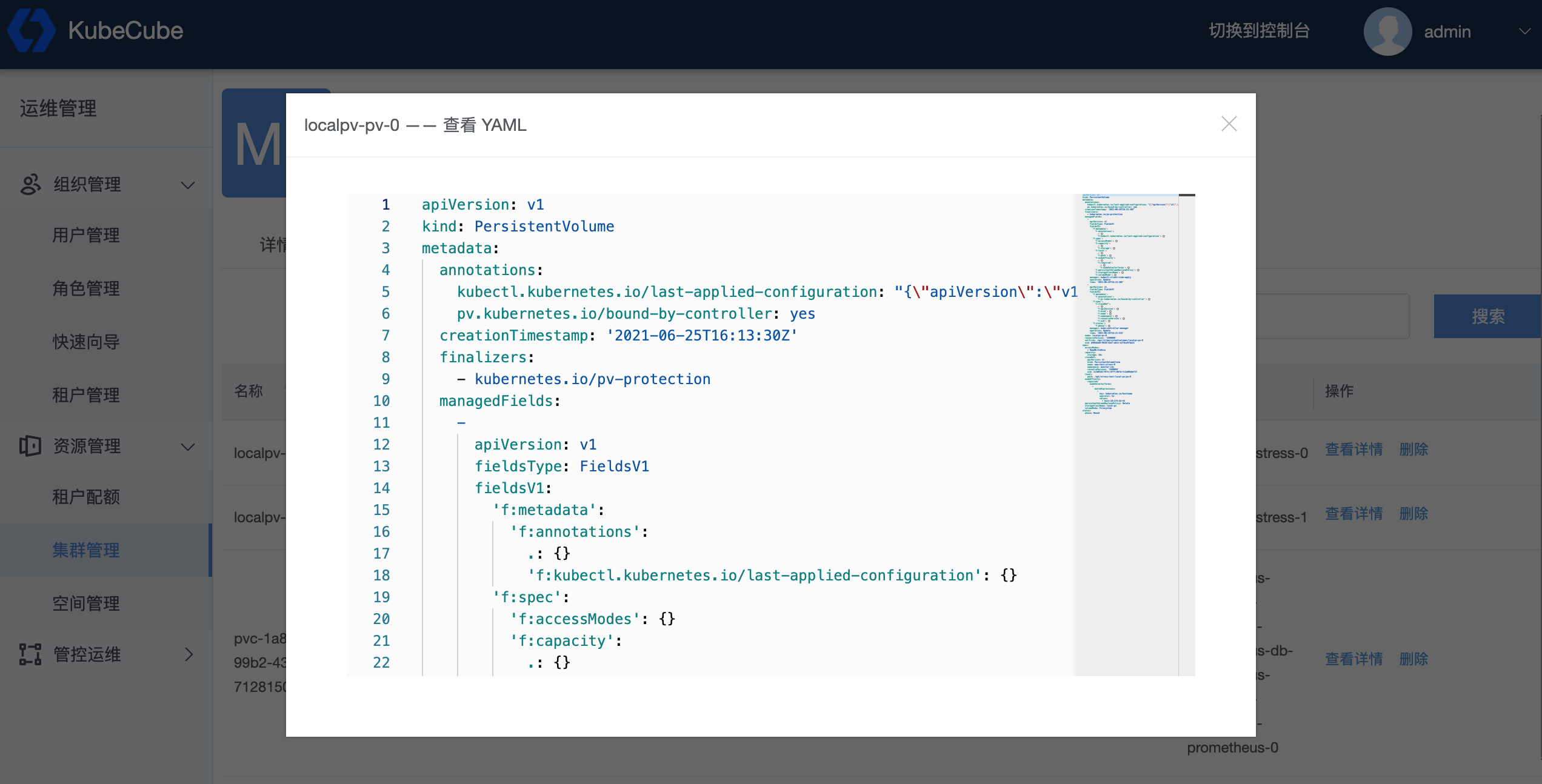

- 4.1.5.2.2: 存储声明(PV)

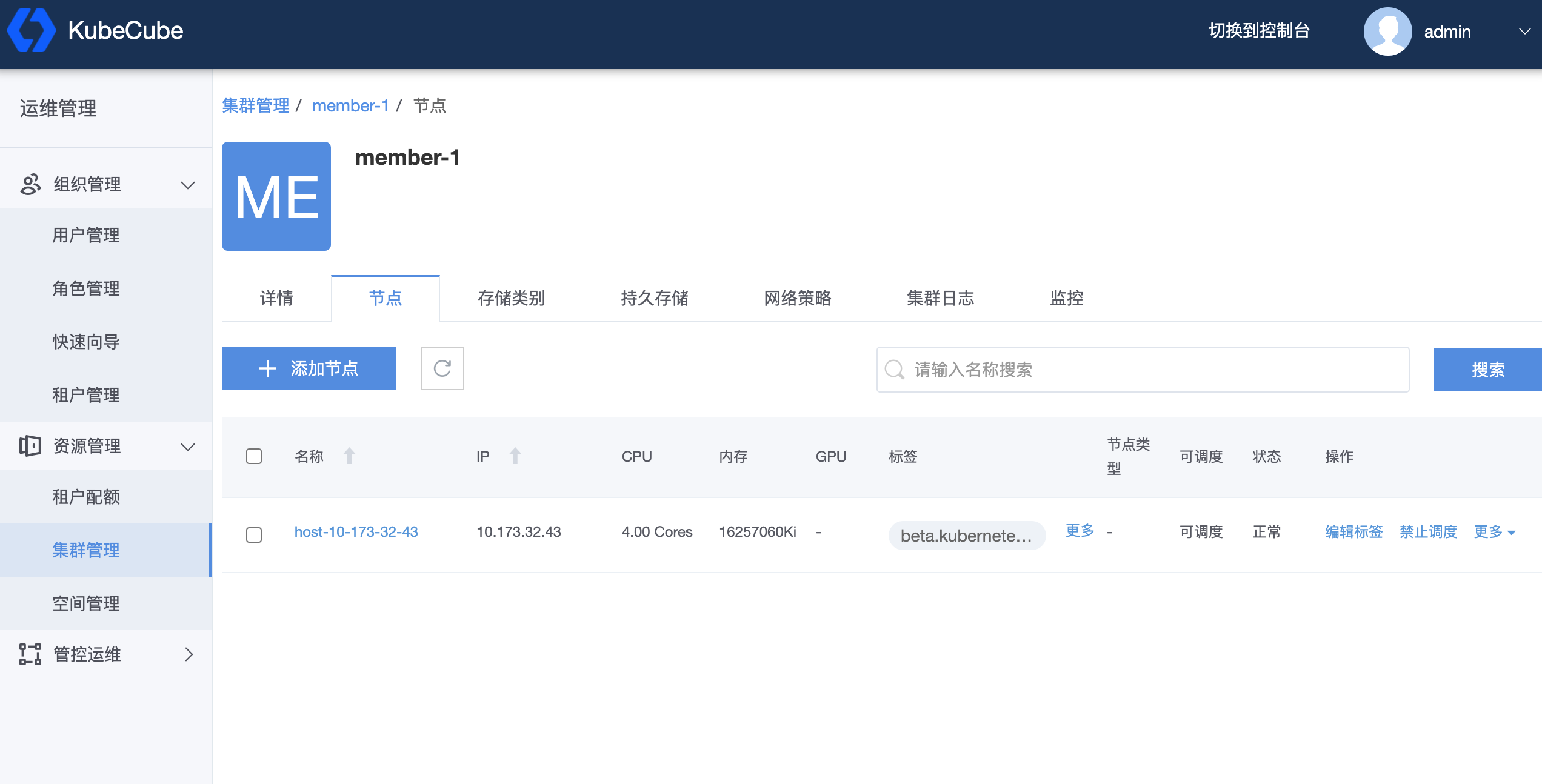

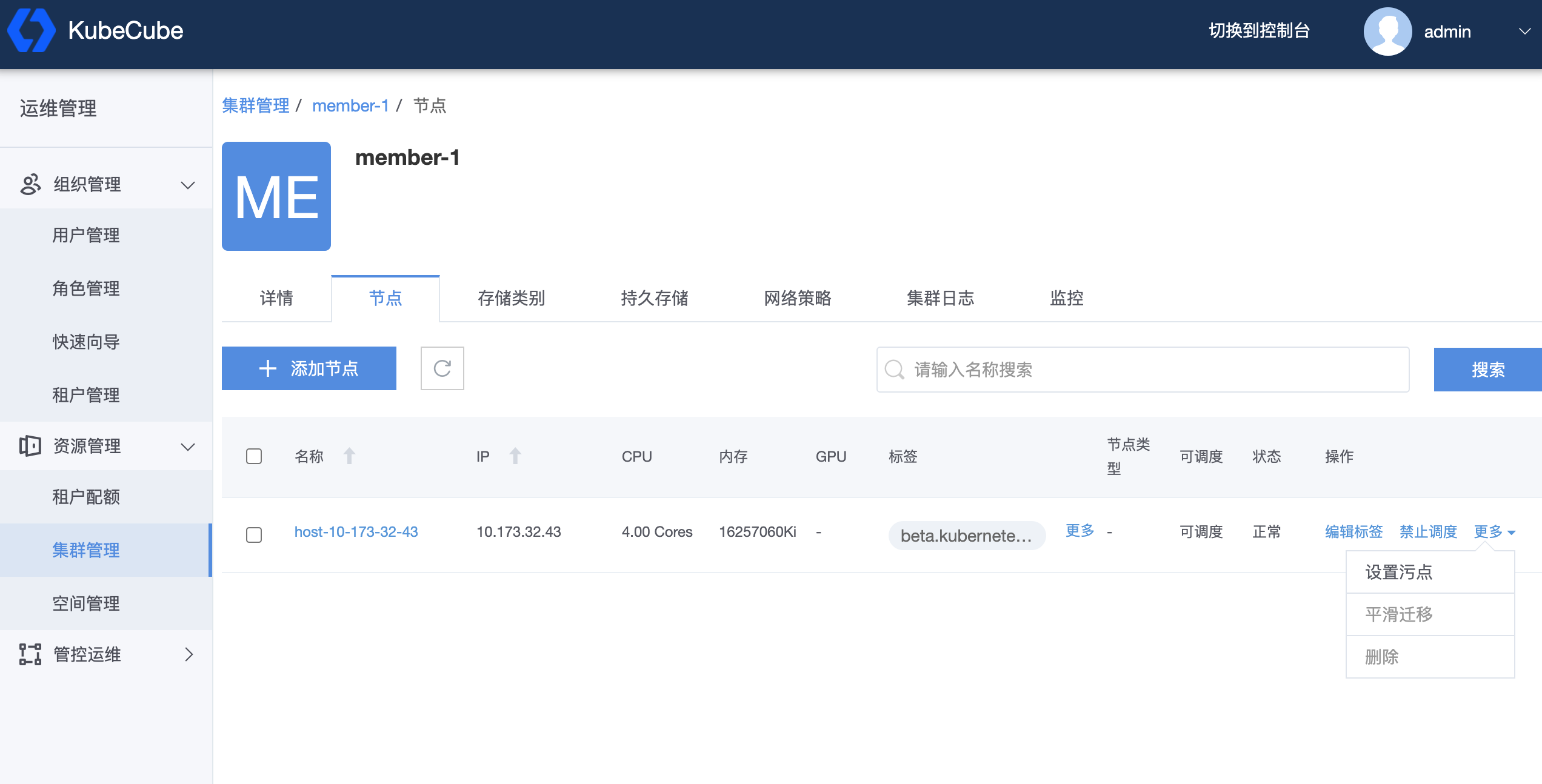

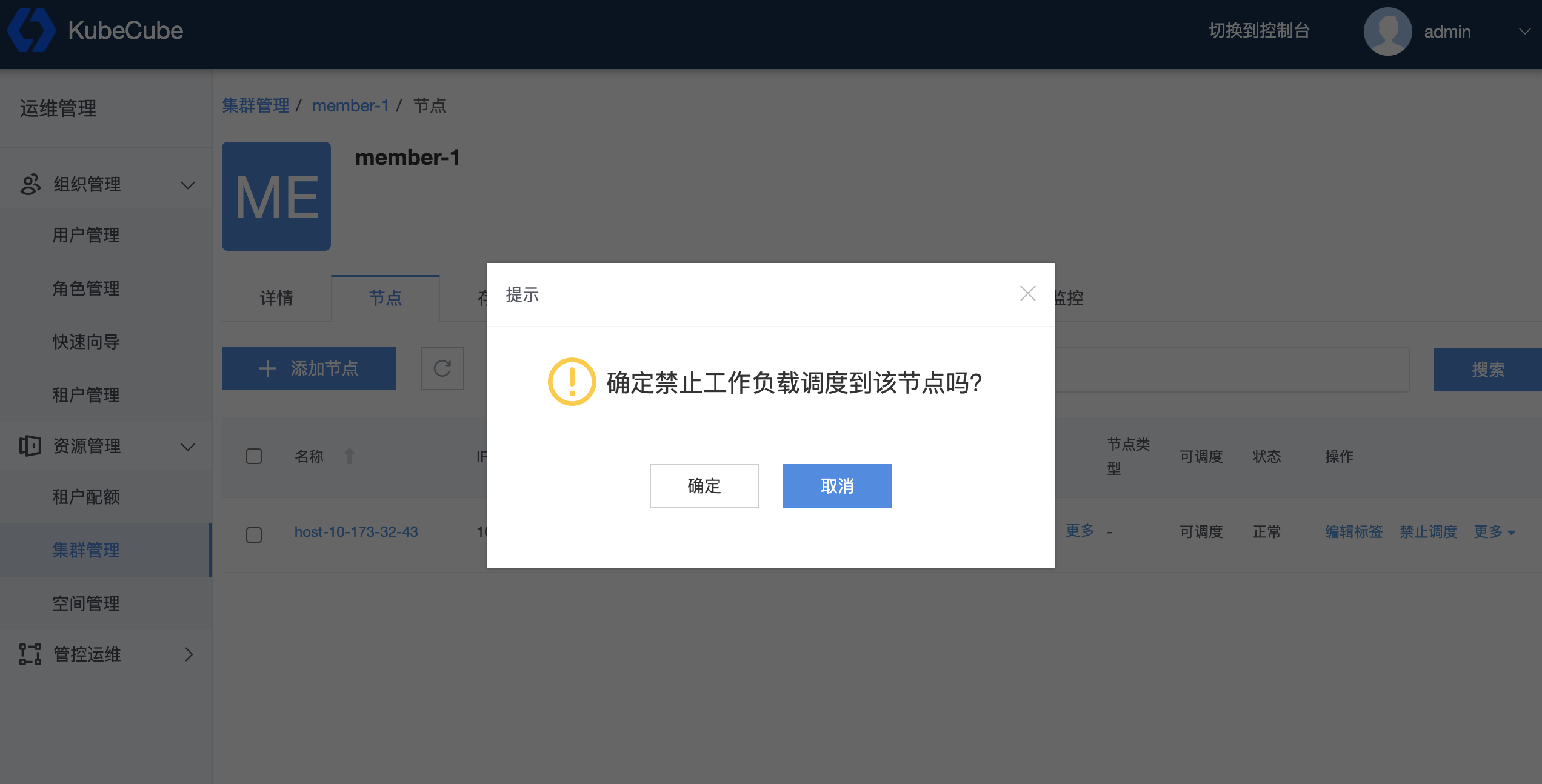

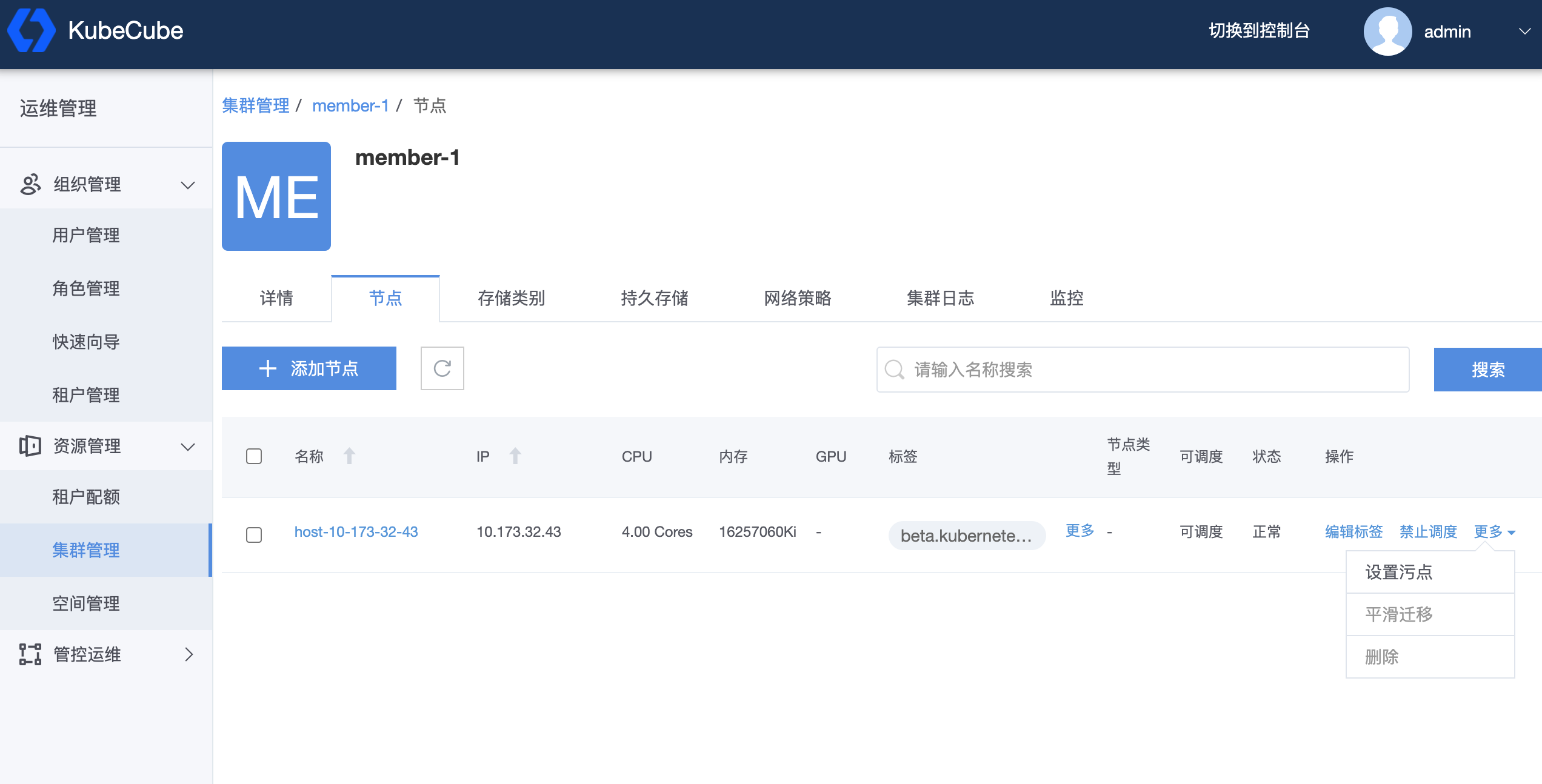

- 4.1.5.2.3: 集群节点(Node)

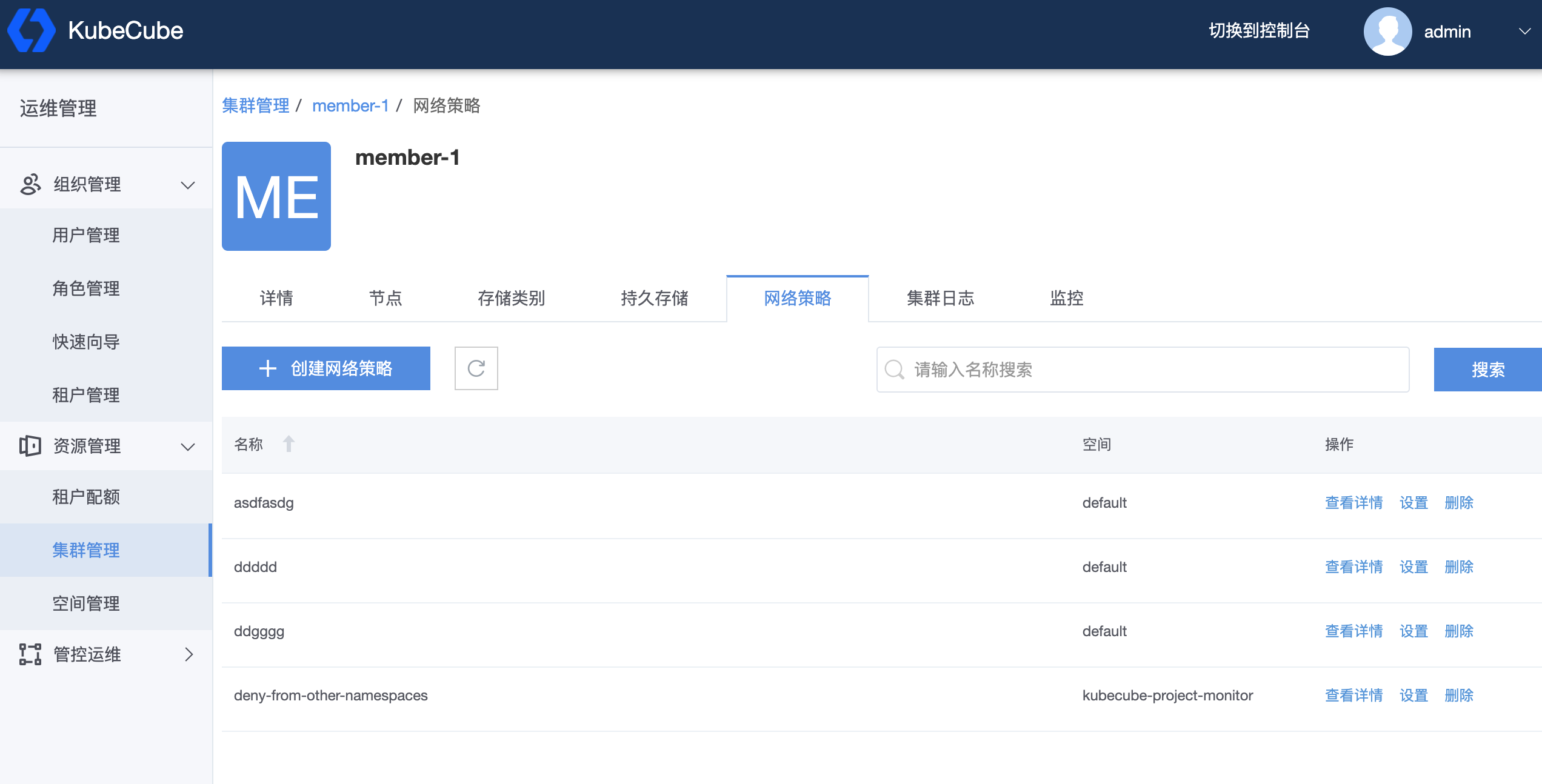

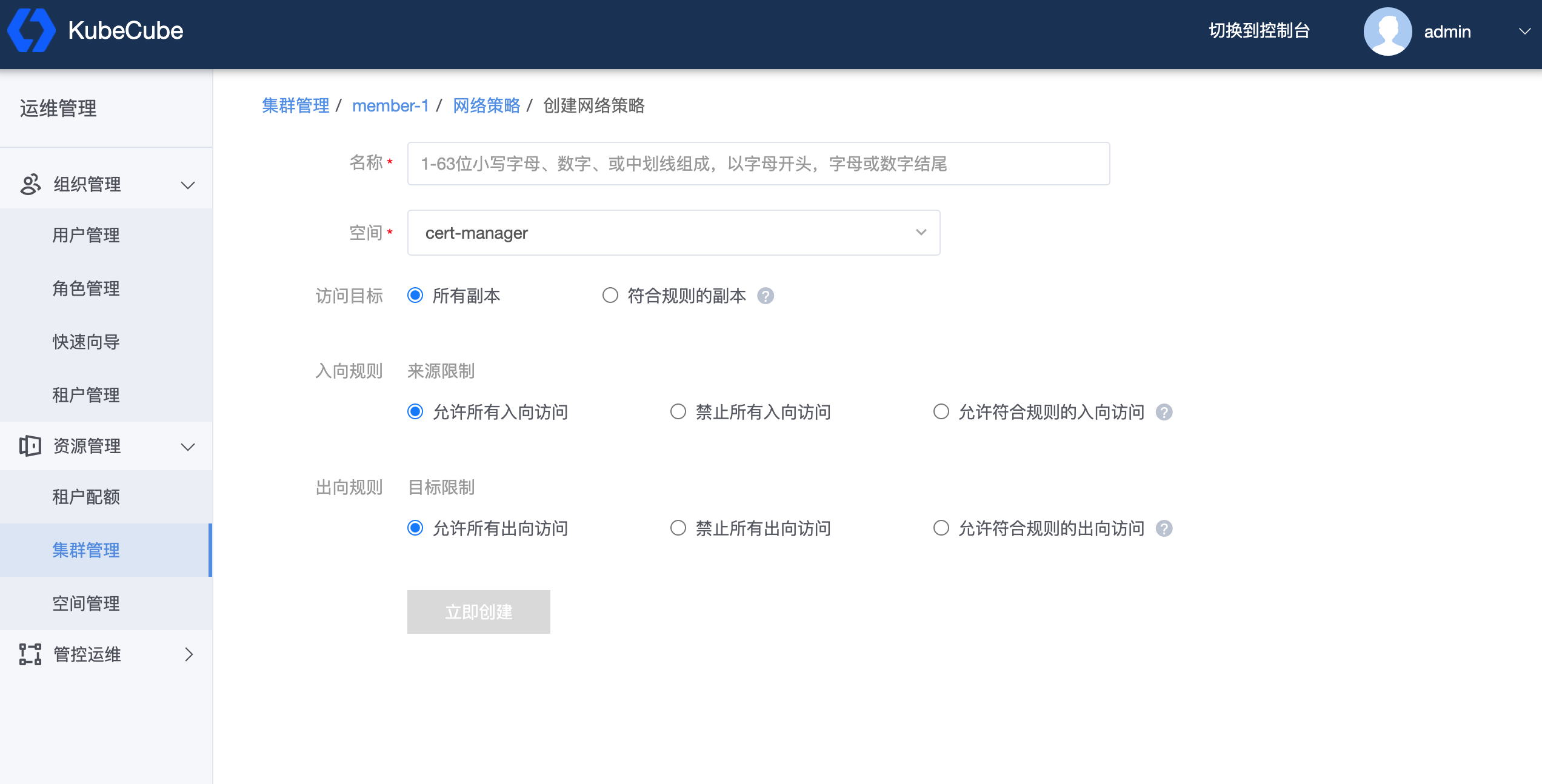

- 4.1.5.2.4: 网络策略(NetworkPolicy)

- 4.1.6: 操作审计

- 4.2: K8s资源管理

- 4.2.1: 工作负载管理

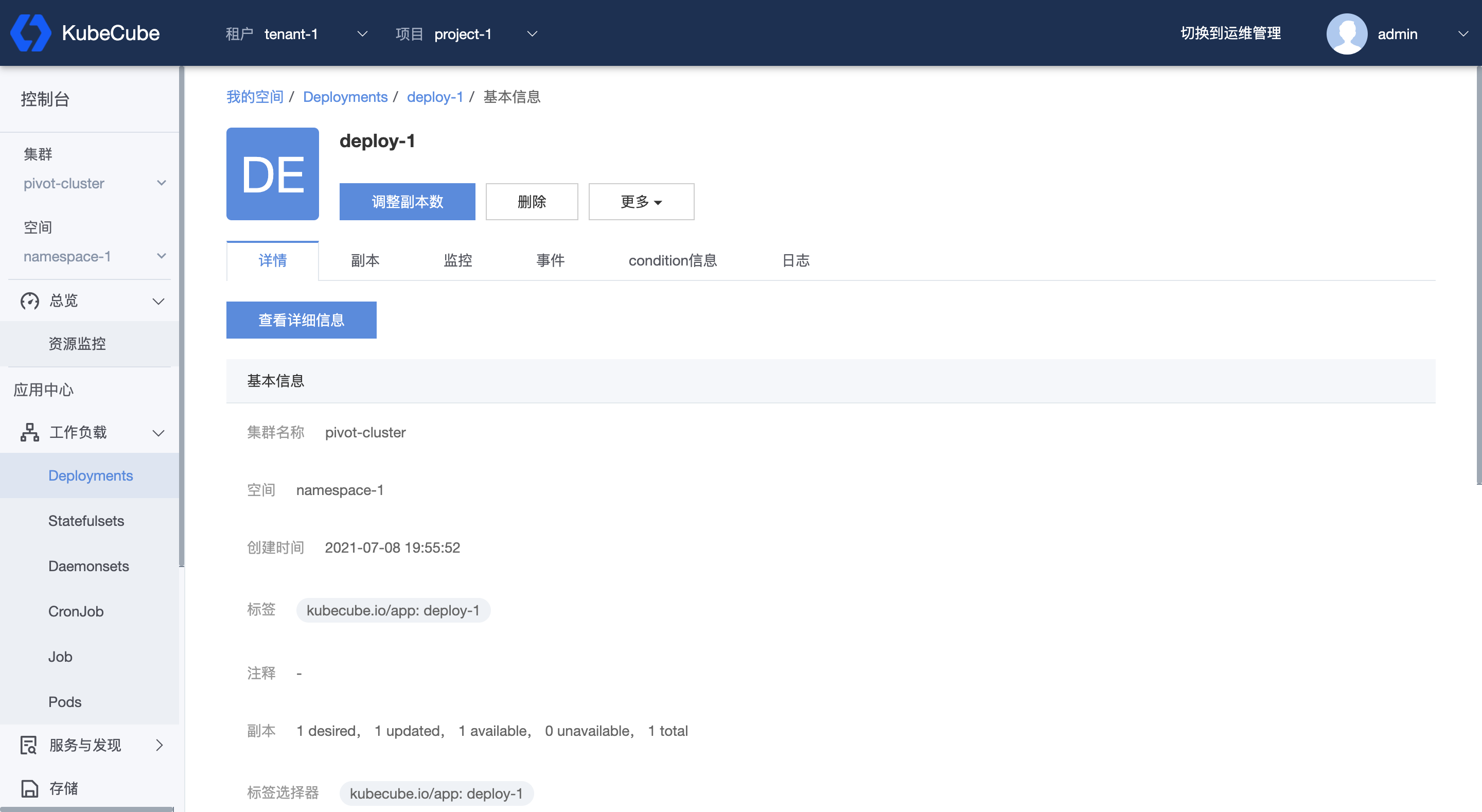

- 4.2.1.1: Deployment

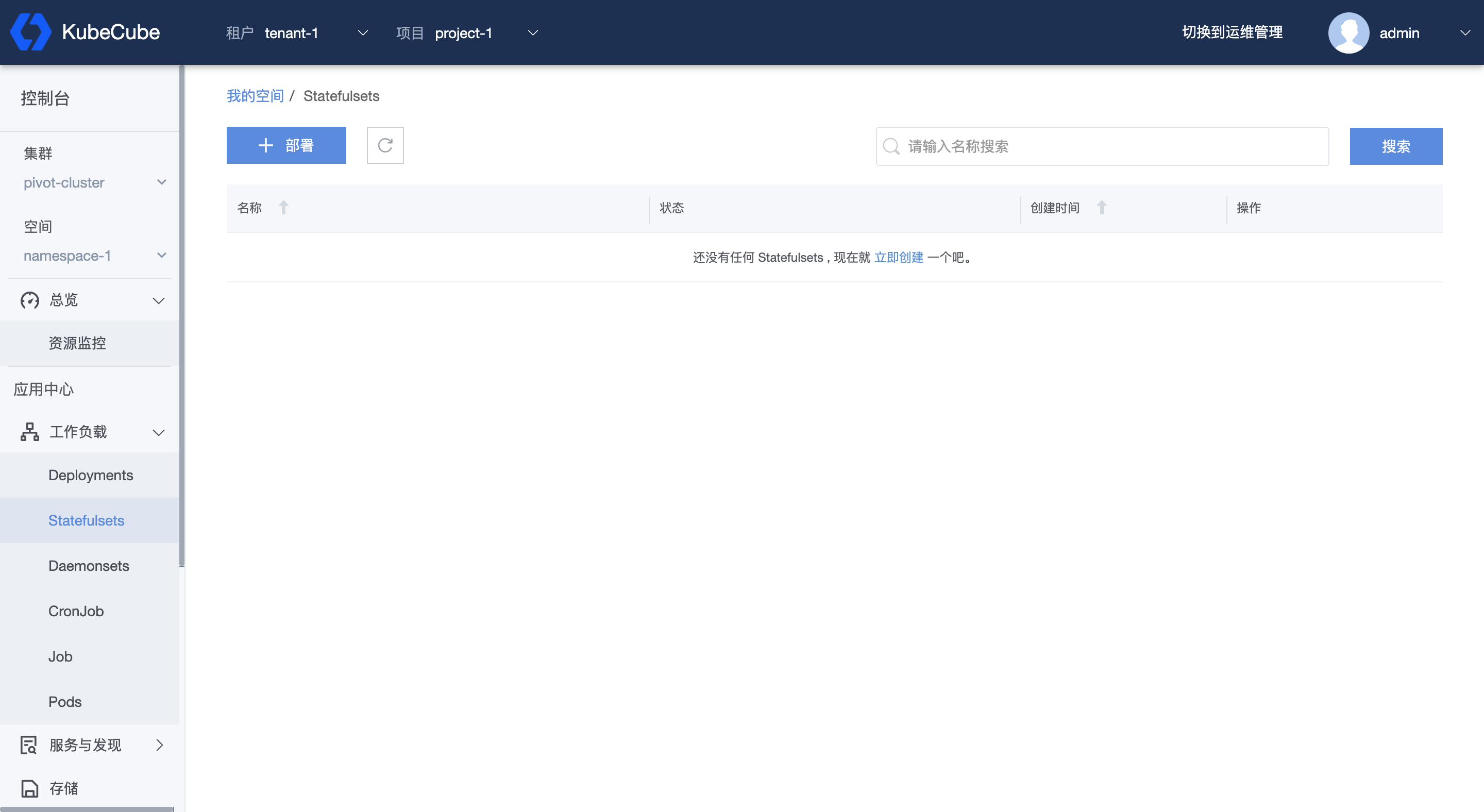

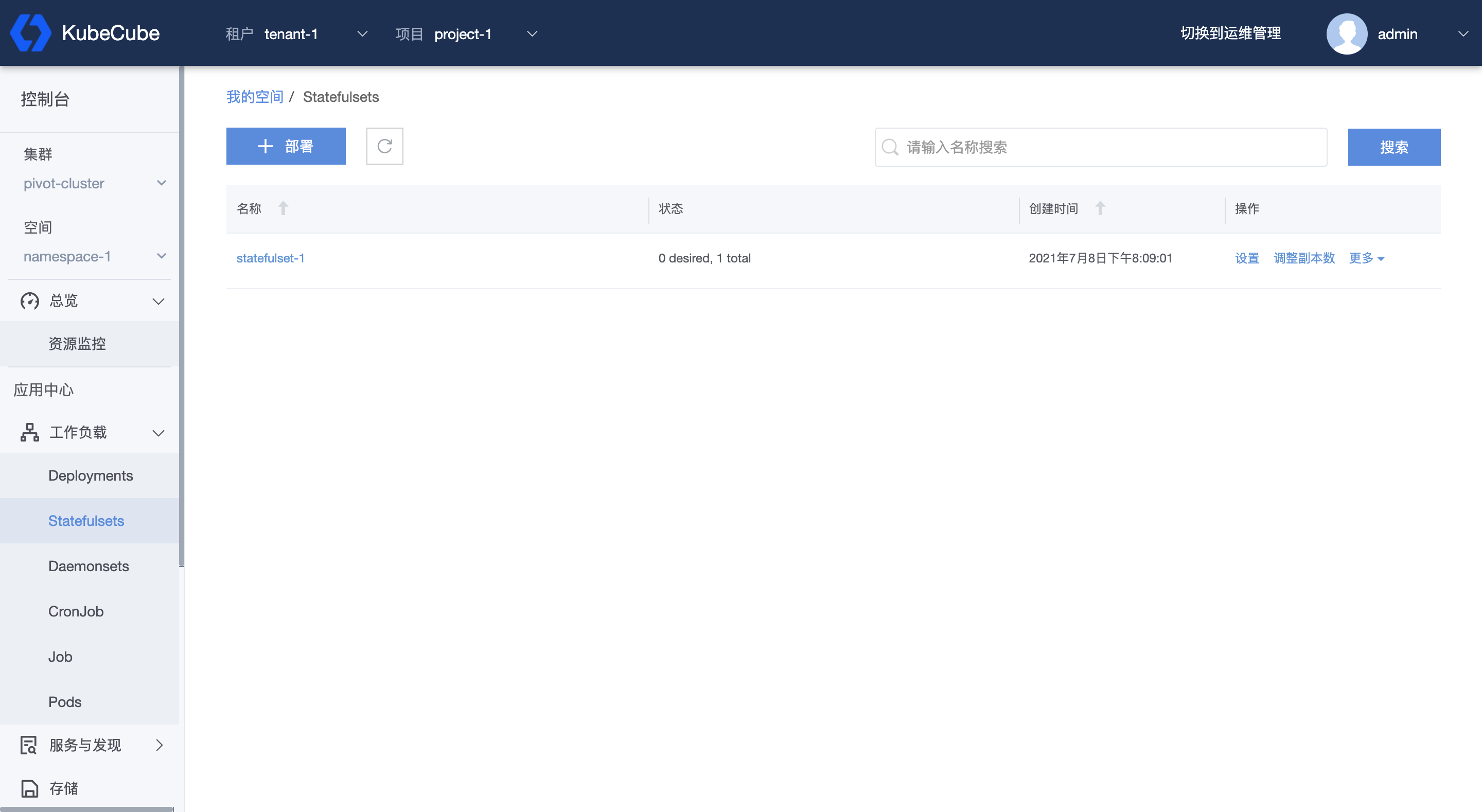

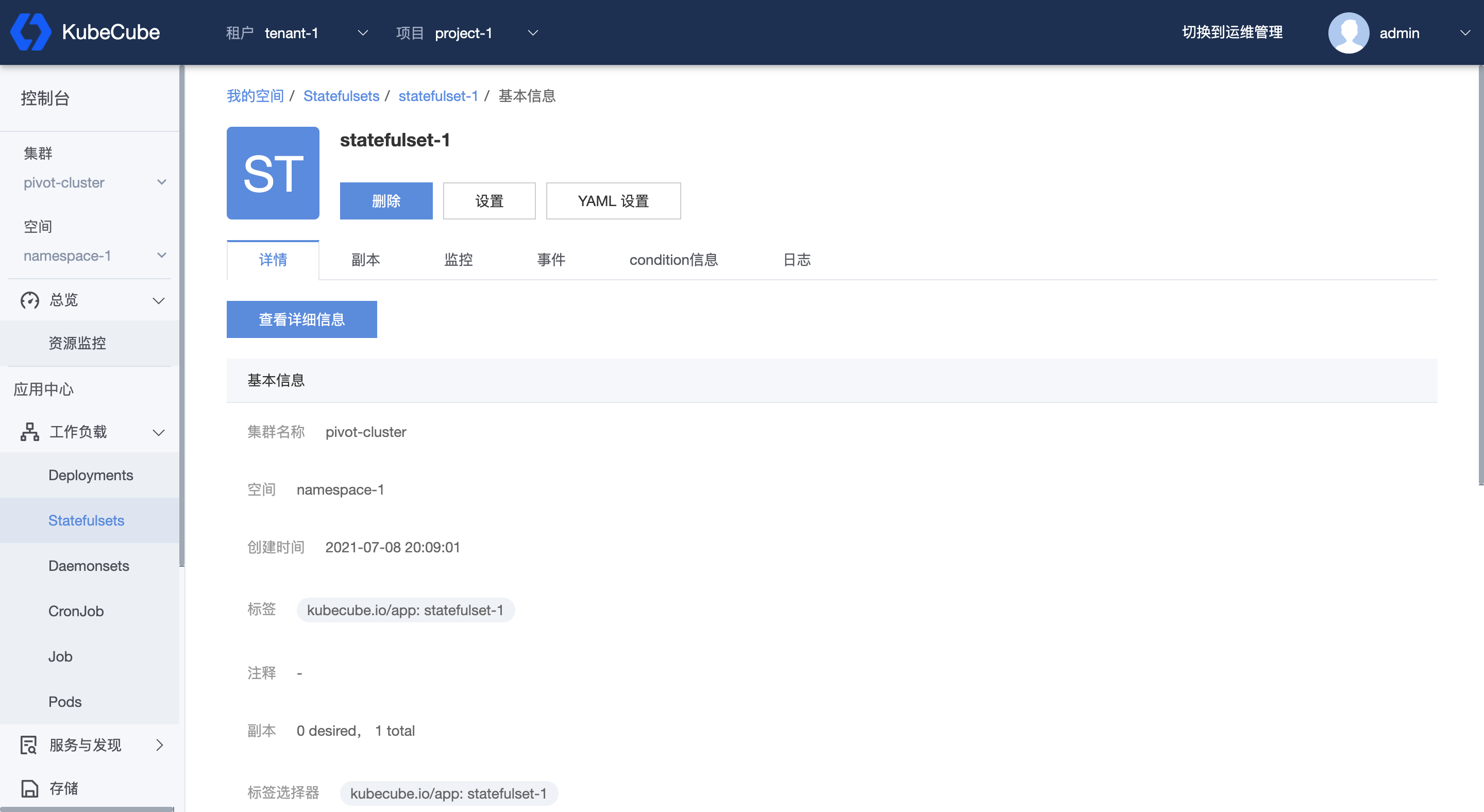

- 4.2.1.2: StatefulSet

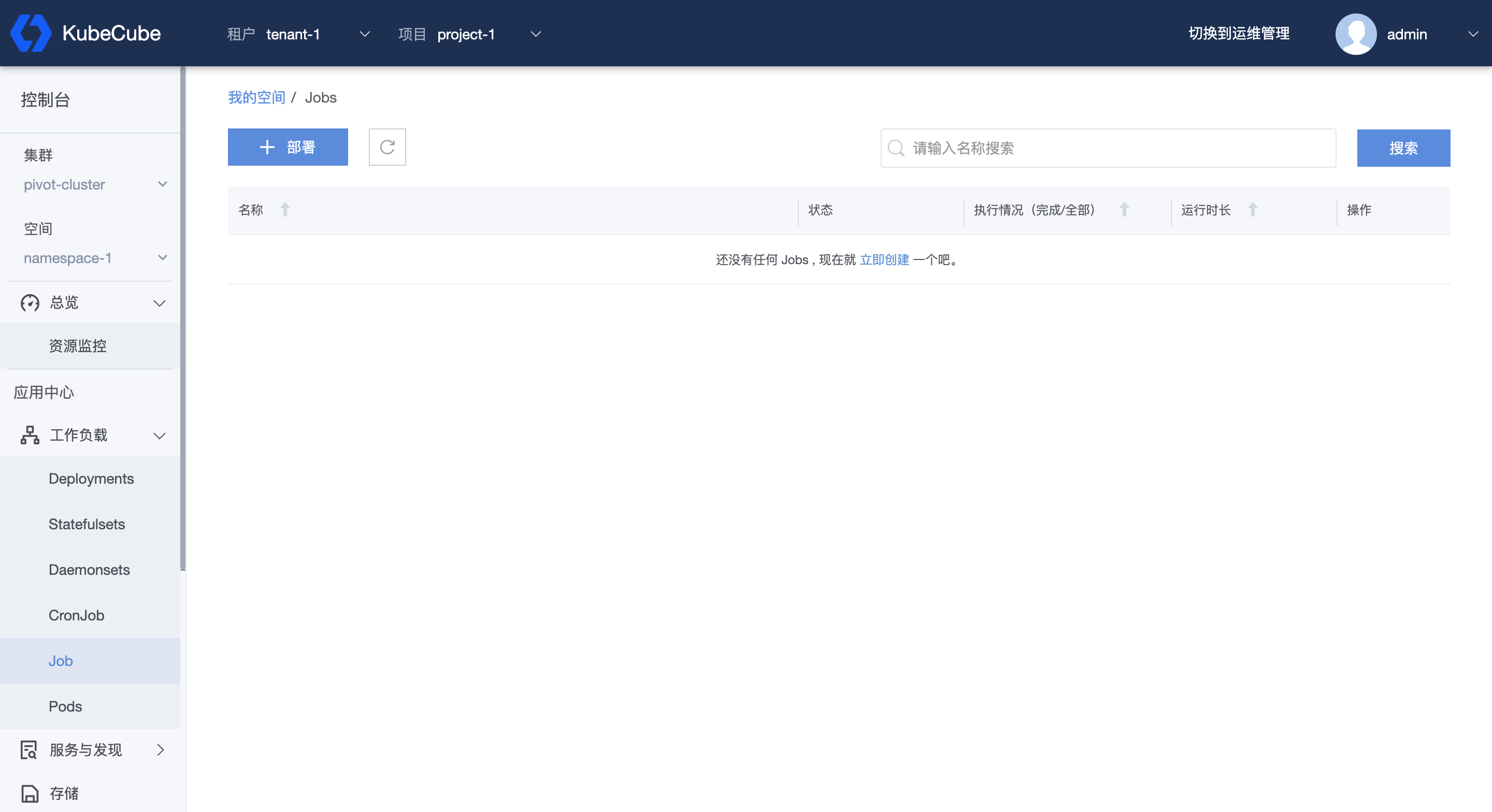

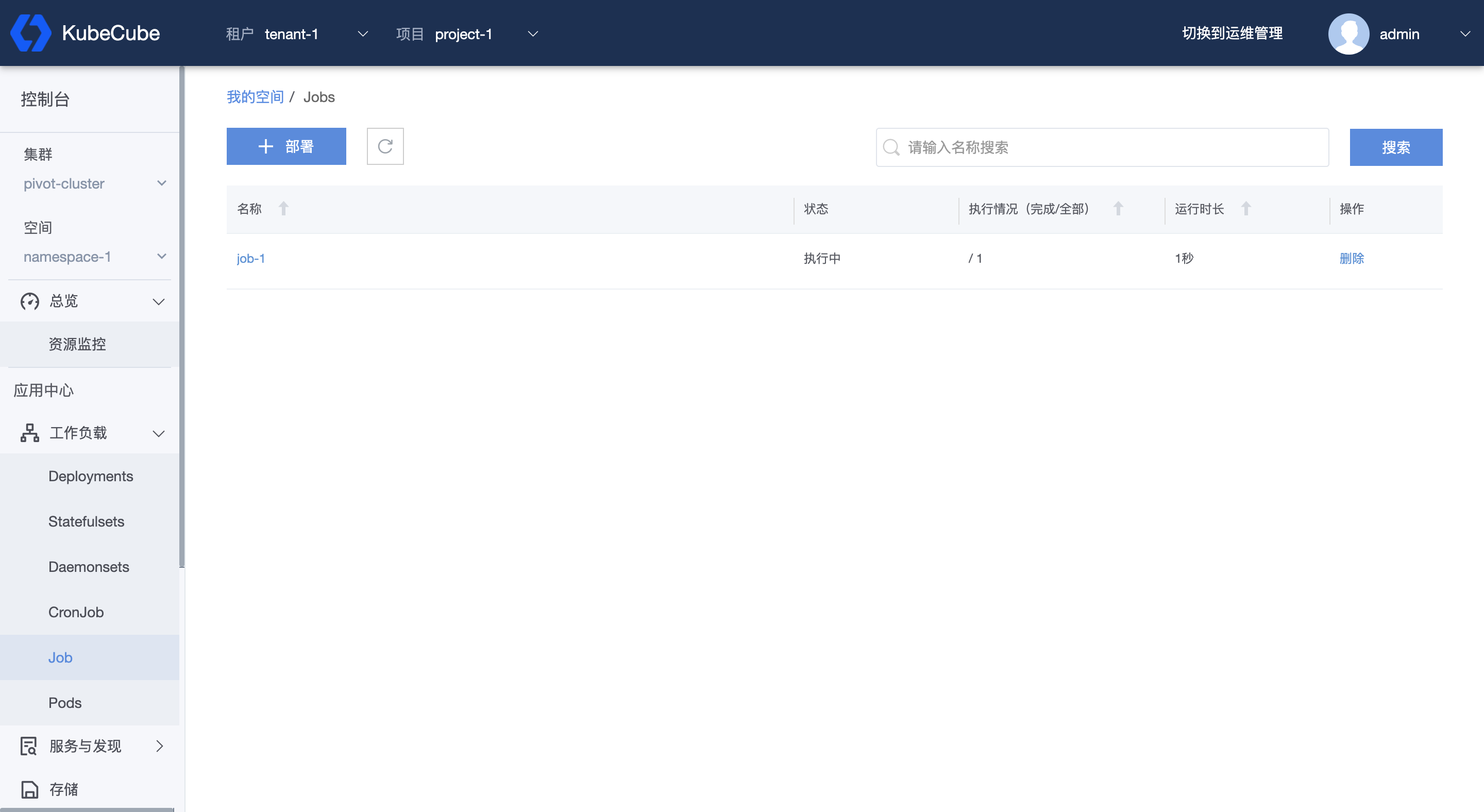

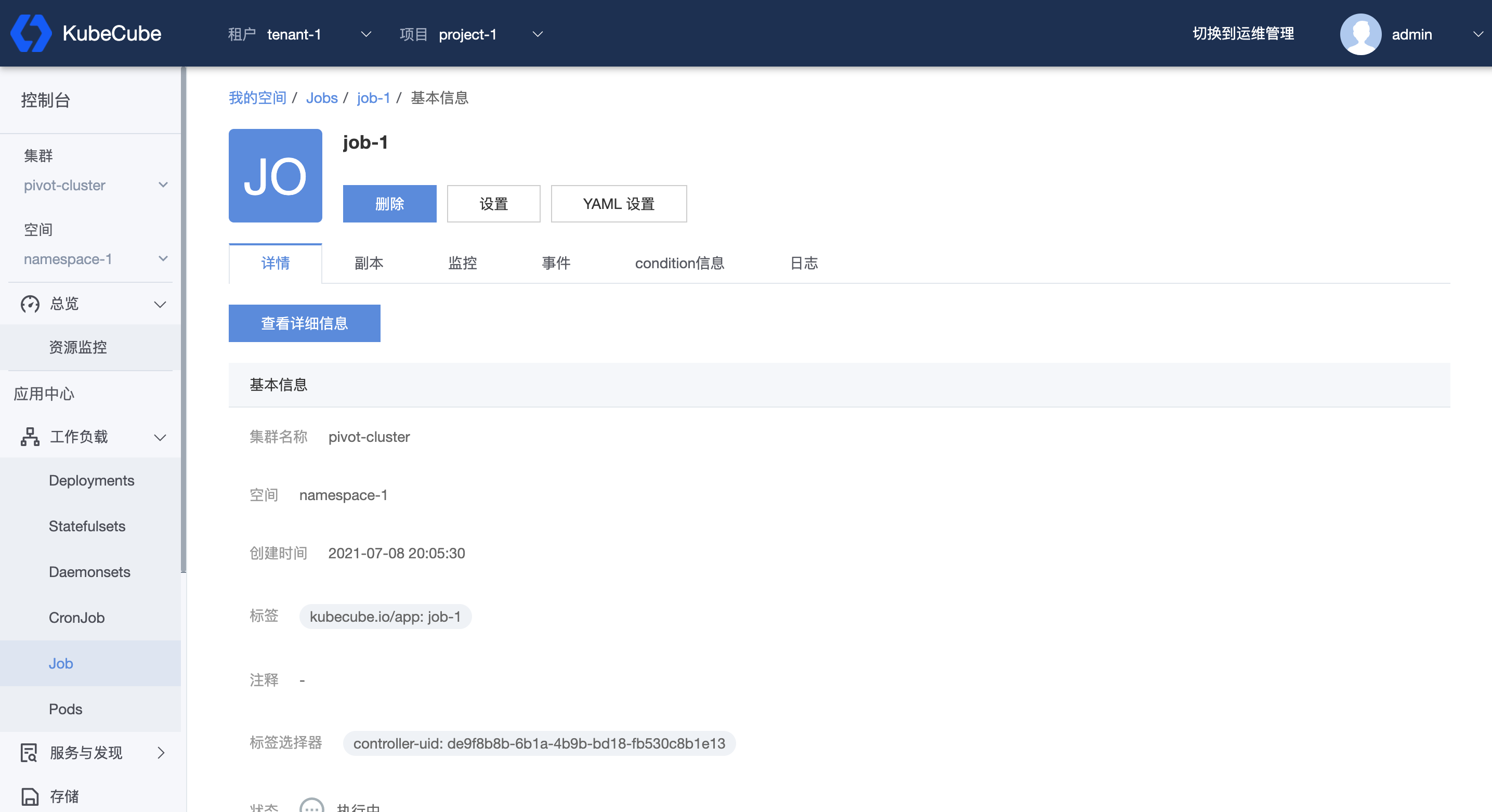

- 4.2.1.3: Job

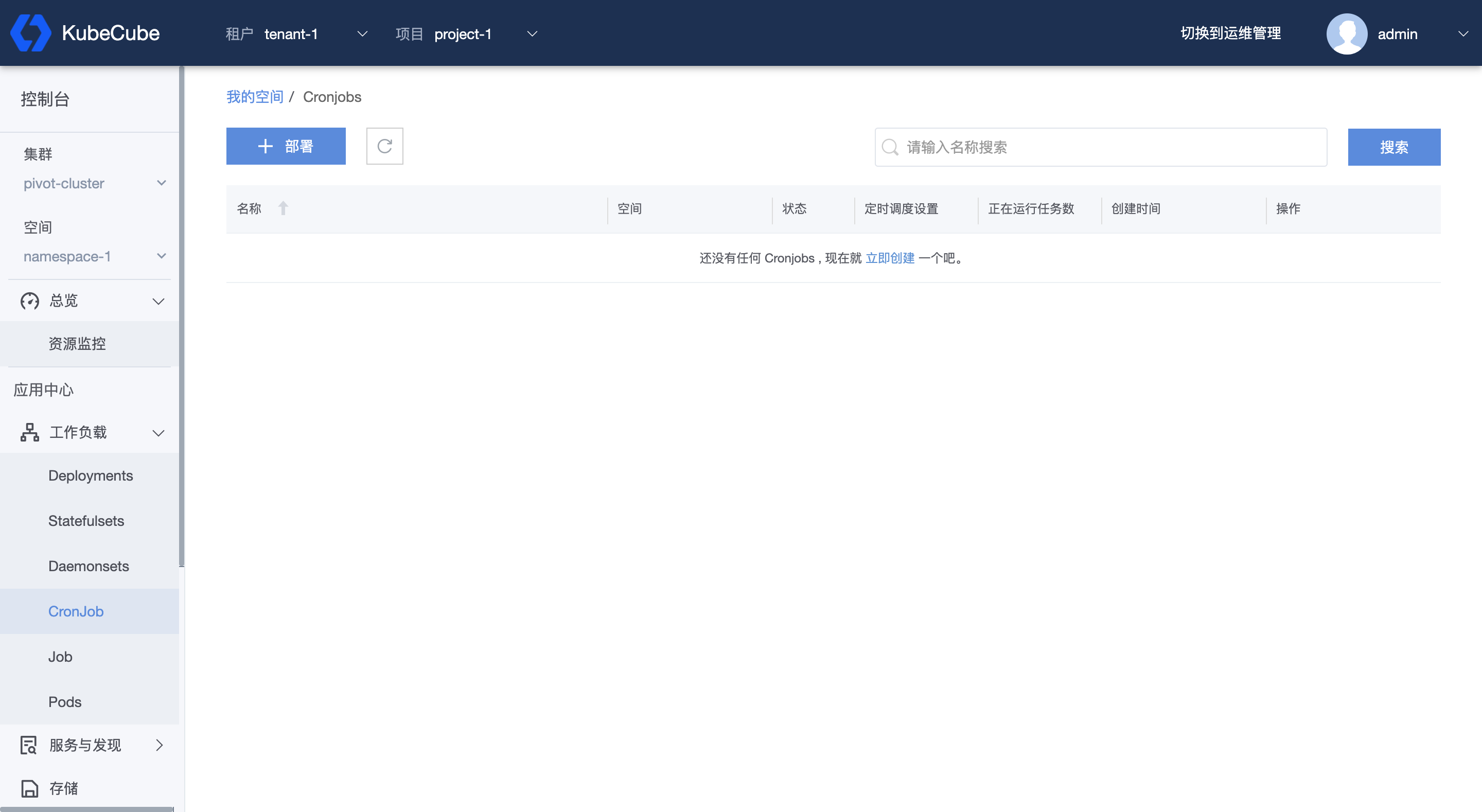

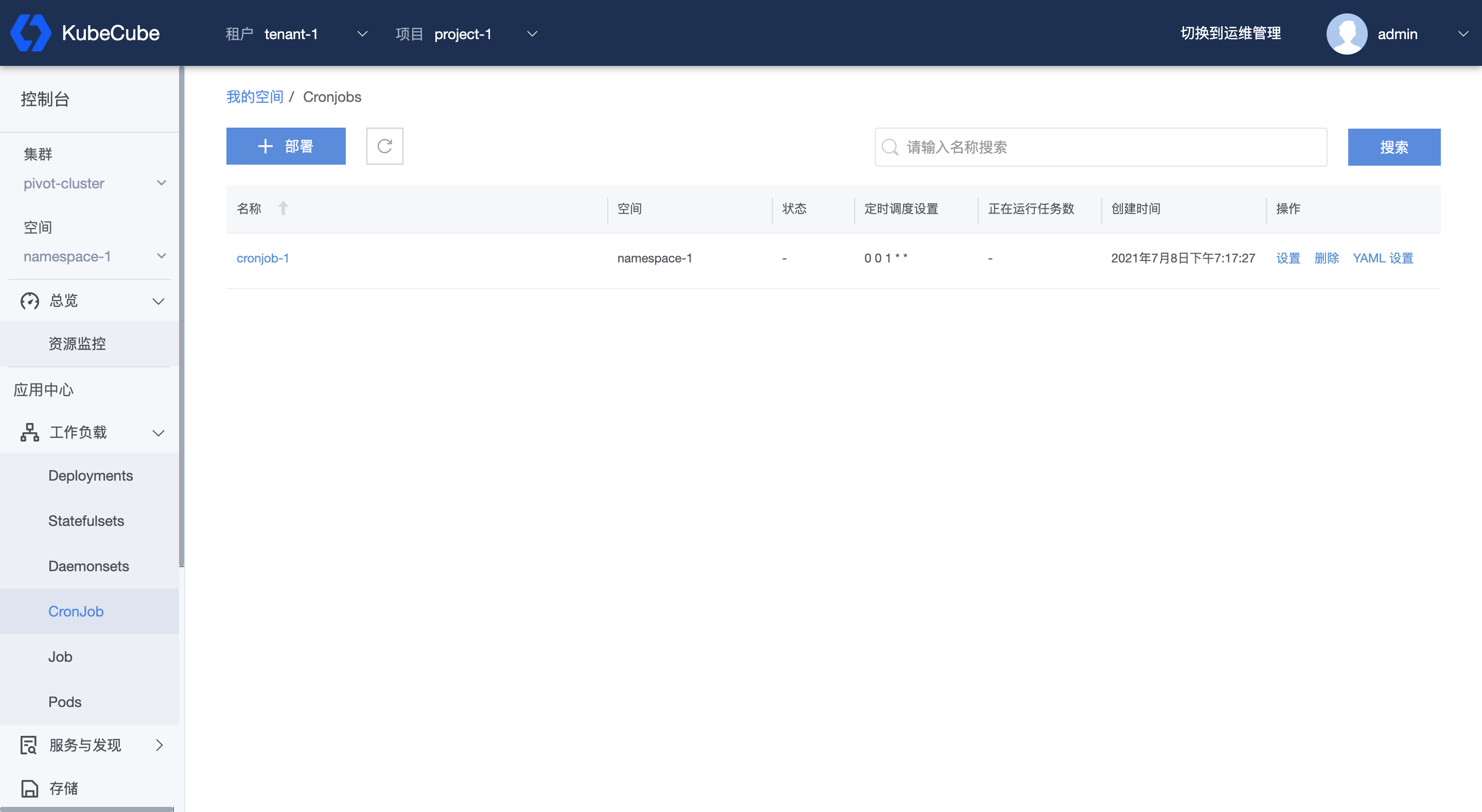

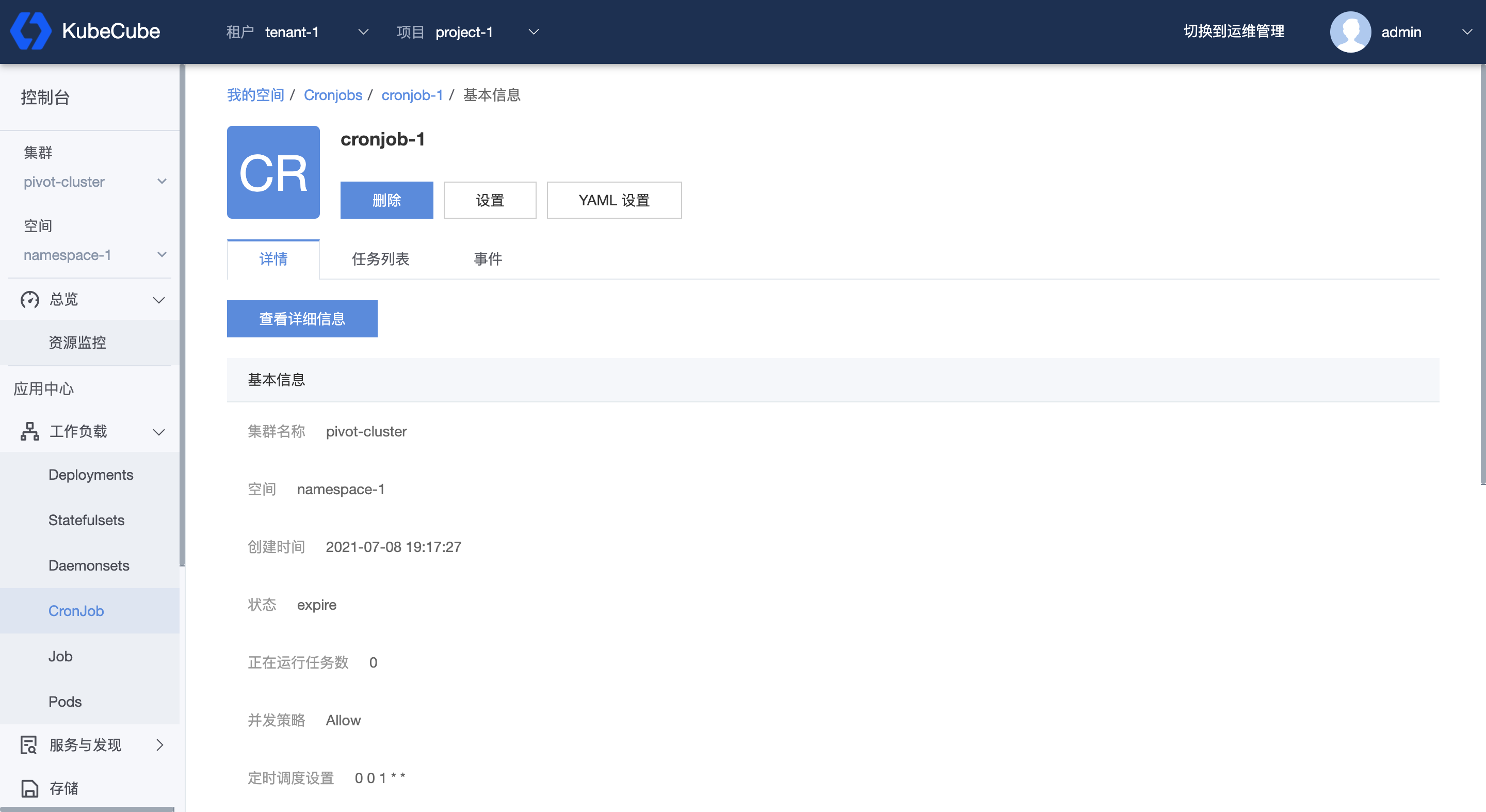

- 4.2.1.4: CronJob

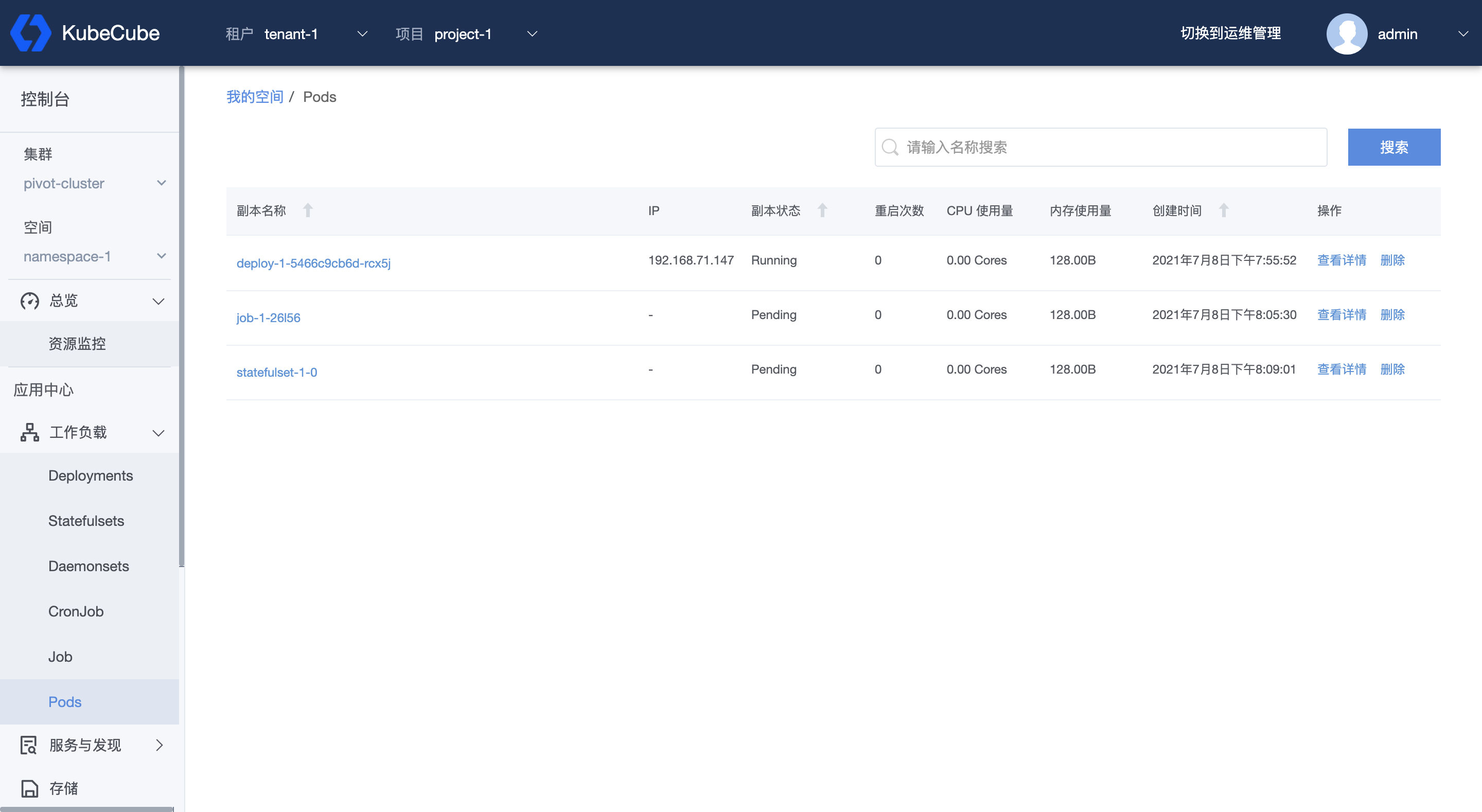

- 4.2.1.5: Pod

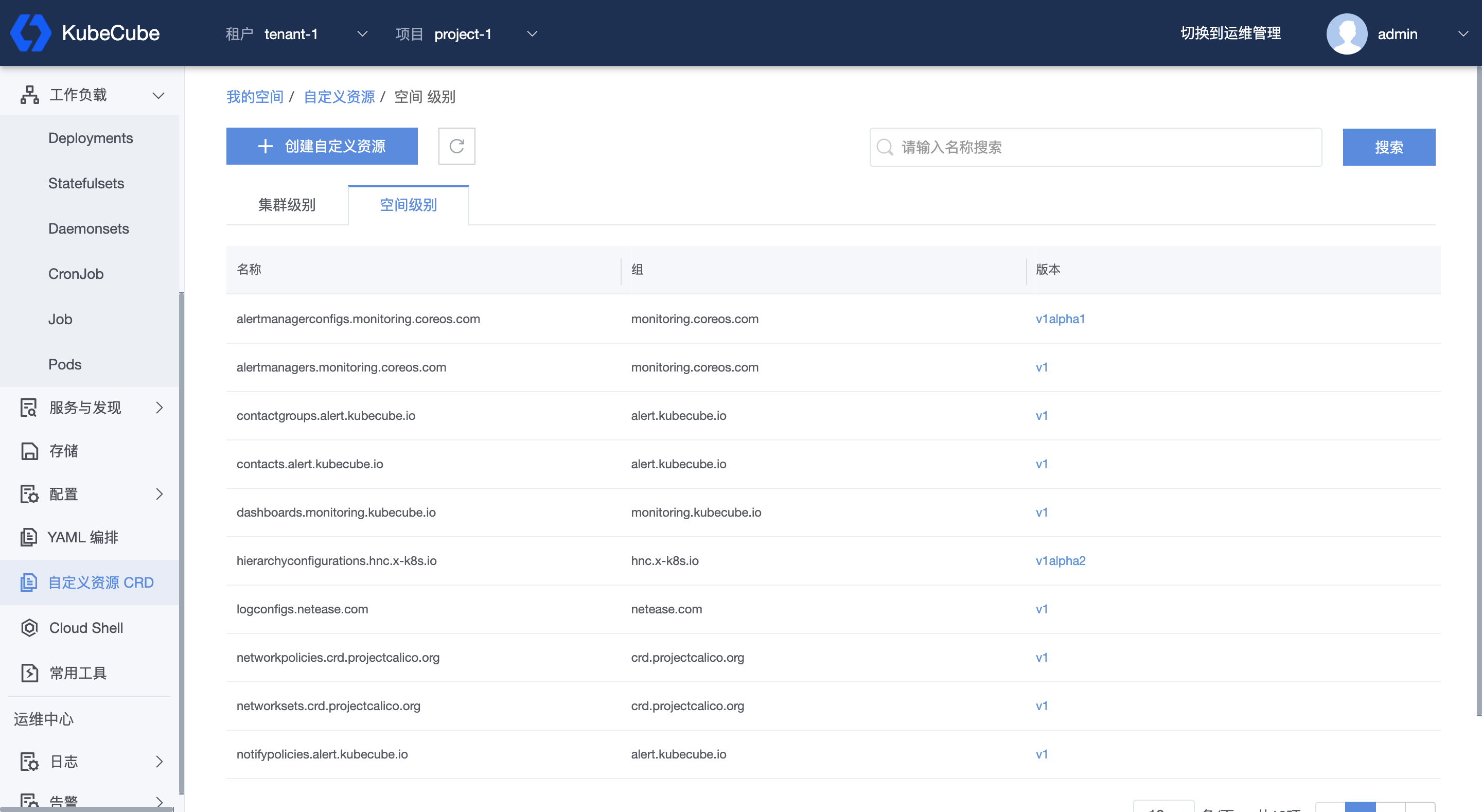

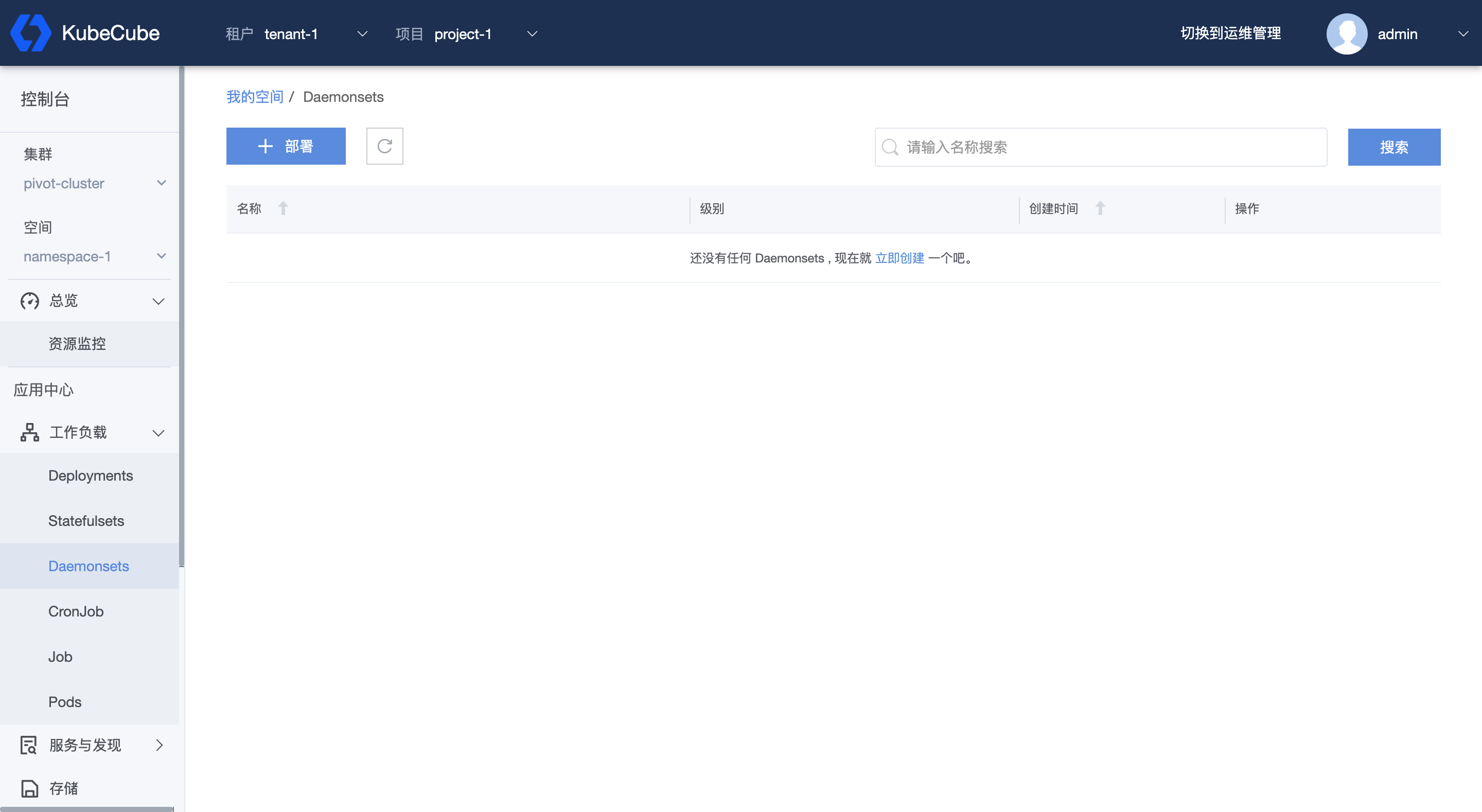

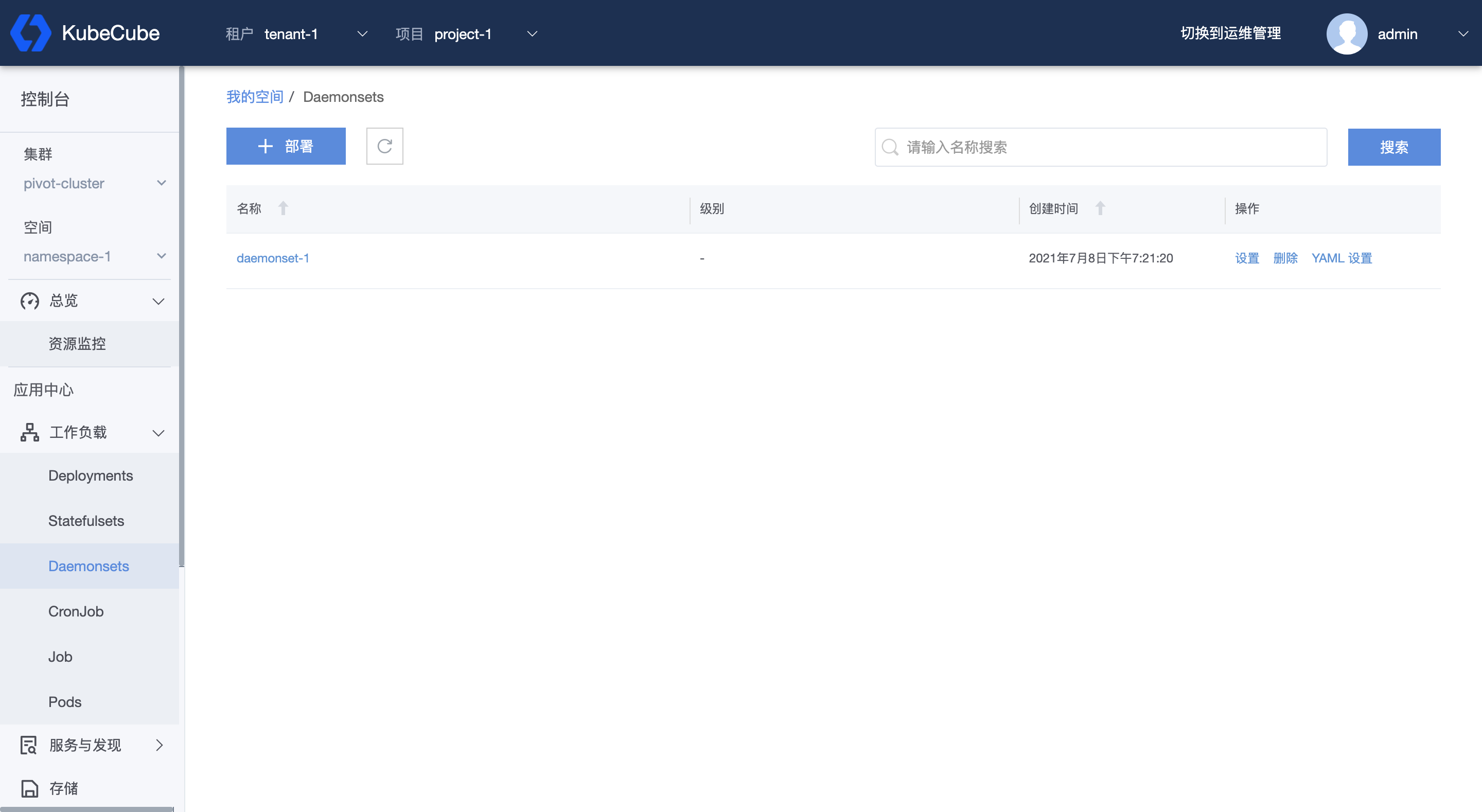

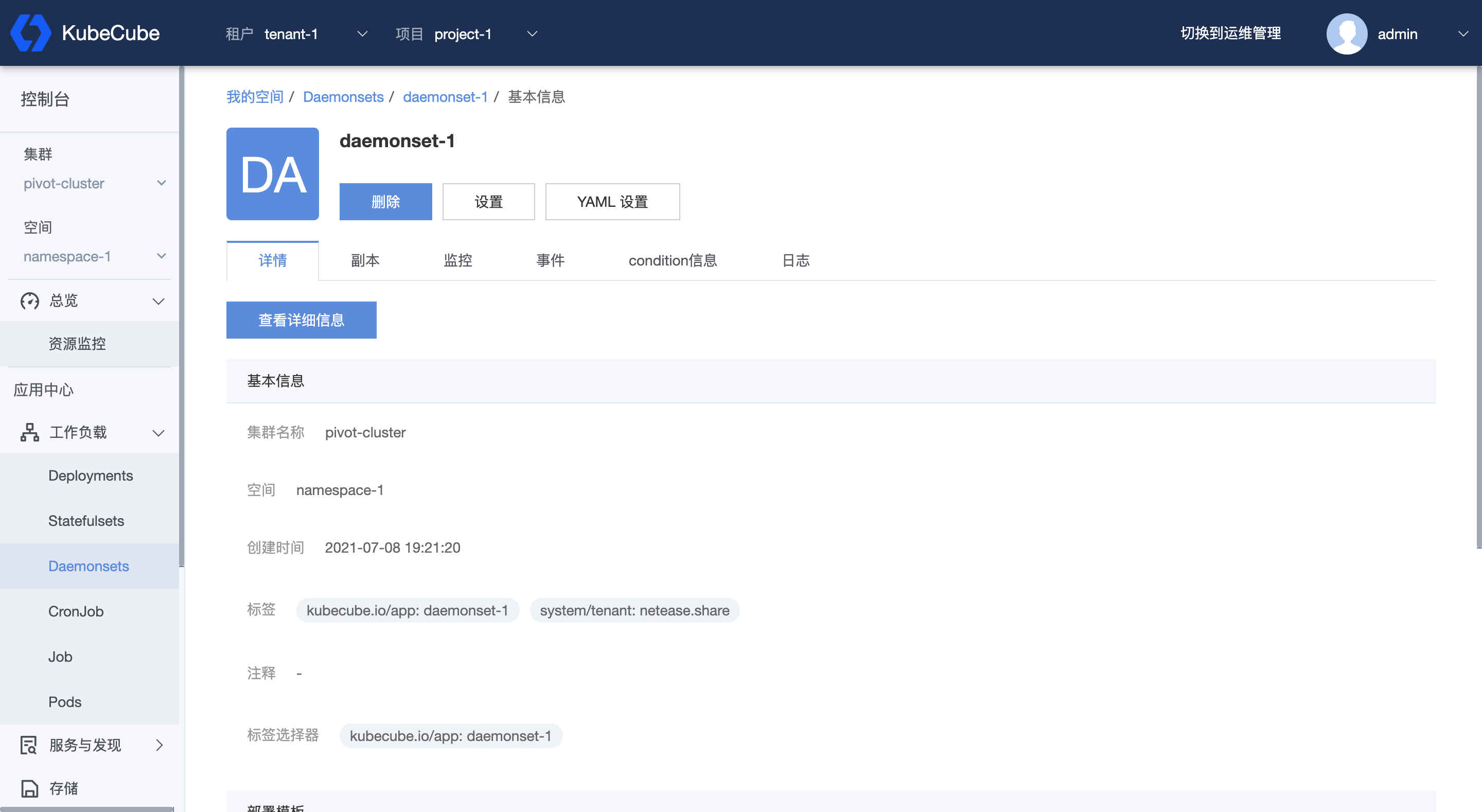

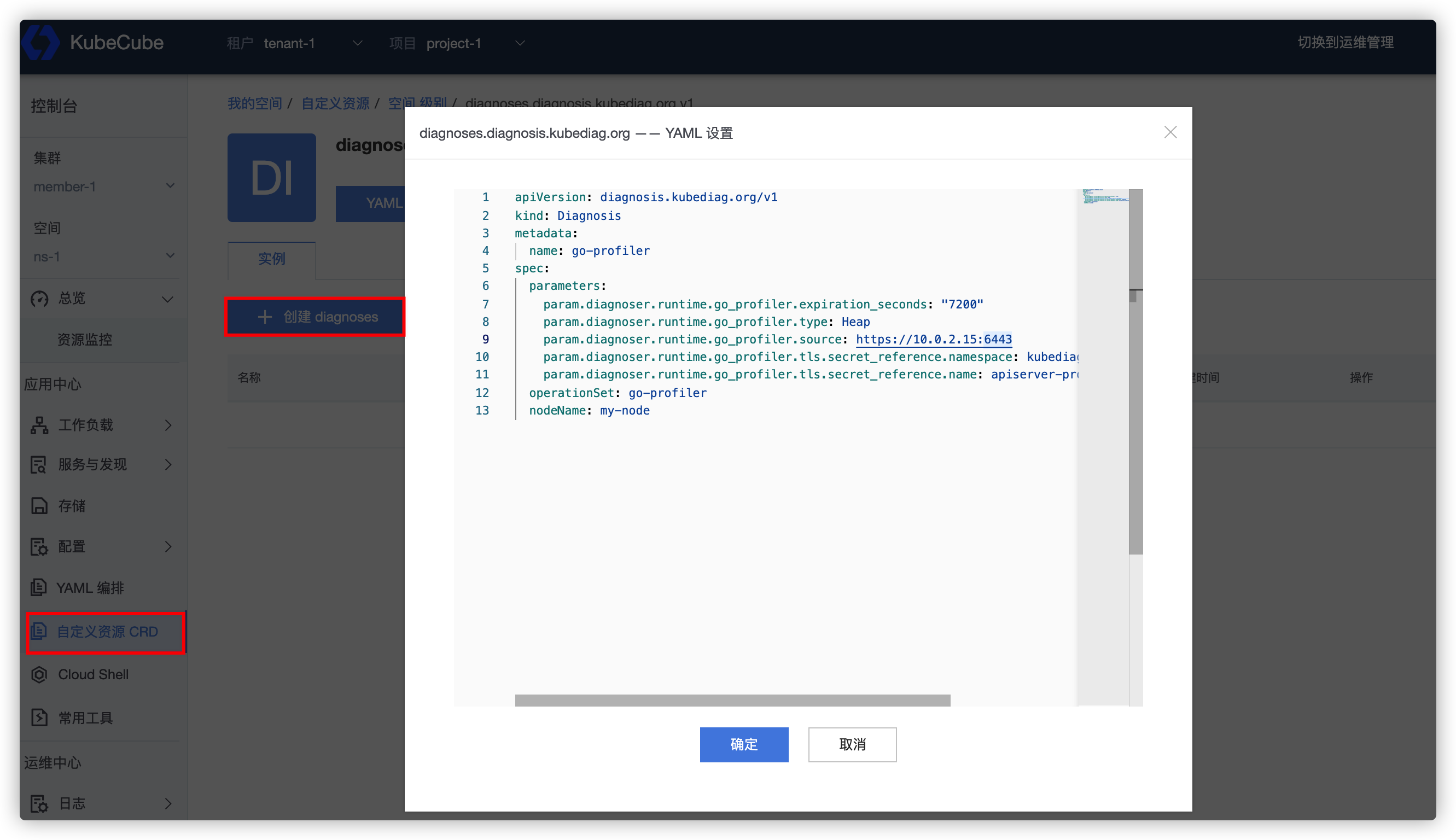

- 4.2.1.6: CRD

- 4.2.1.7: DaemonSet

- 4.2.2: 服务与发现

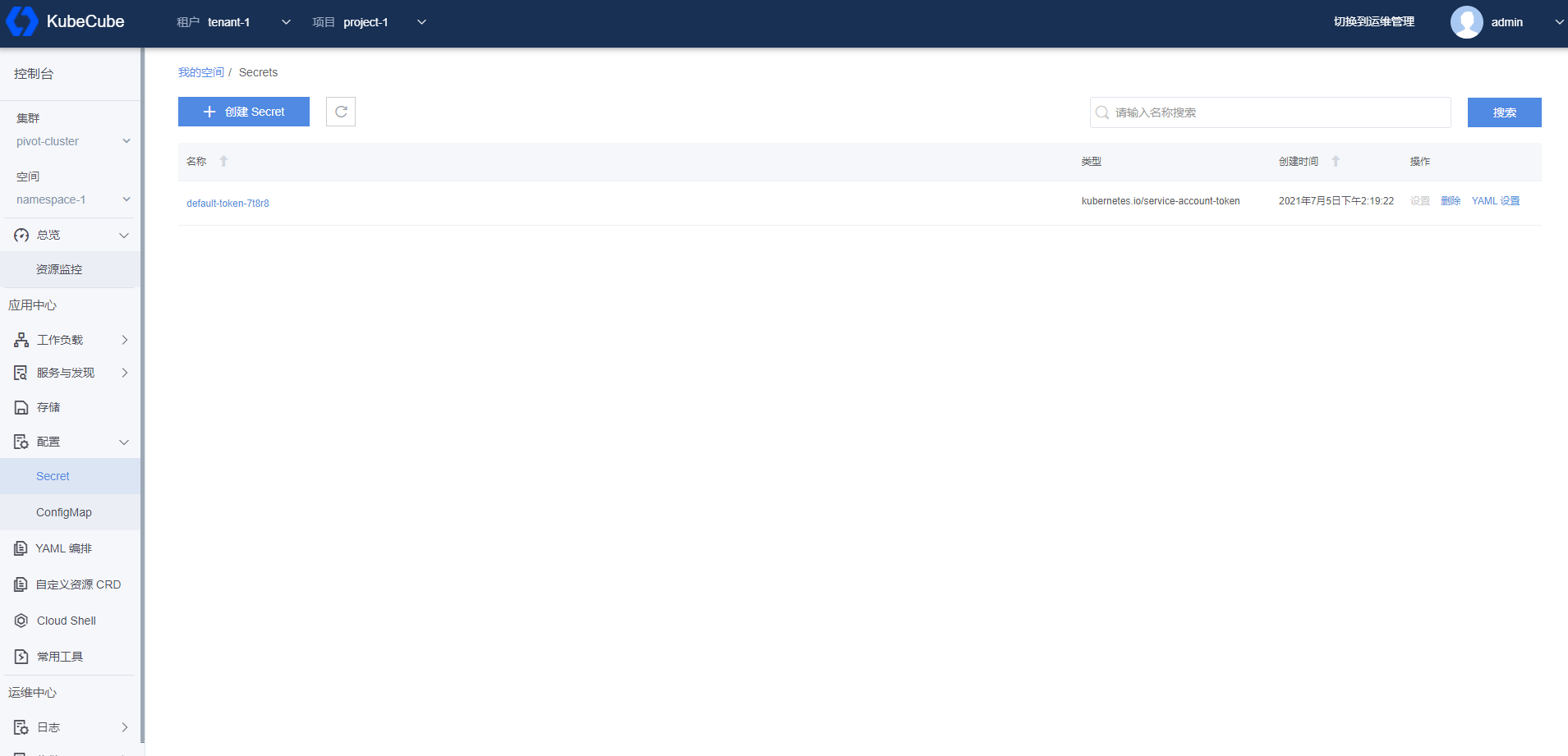

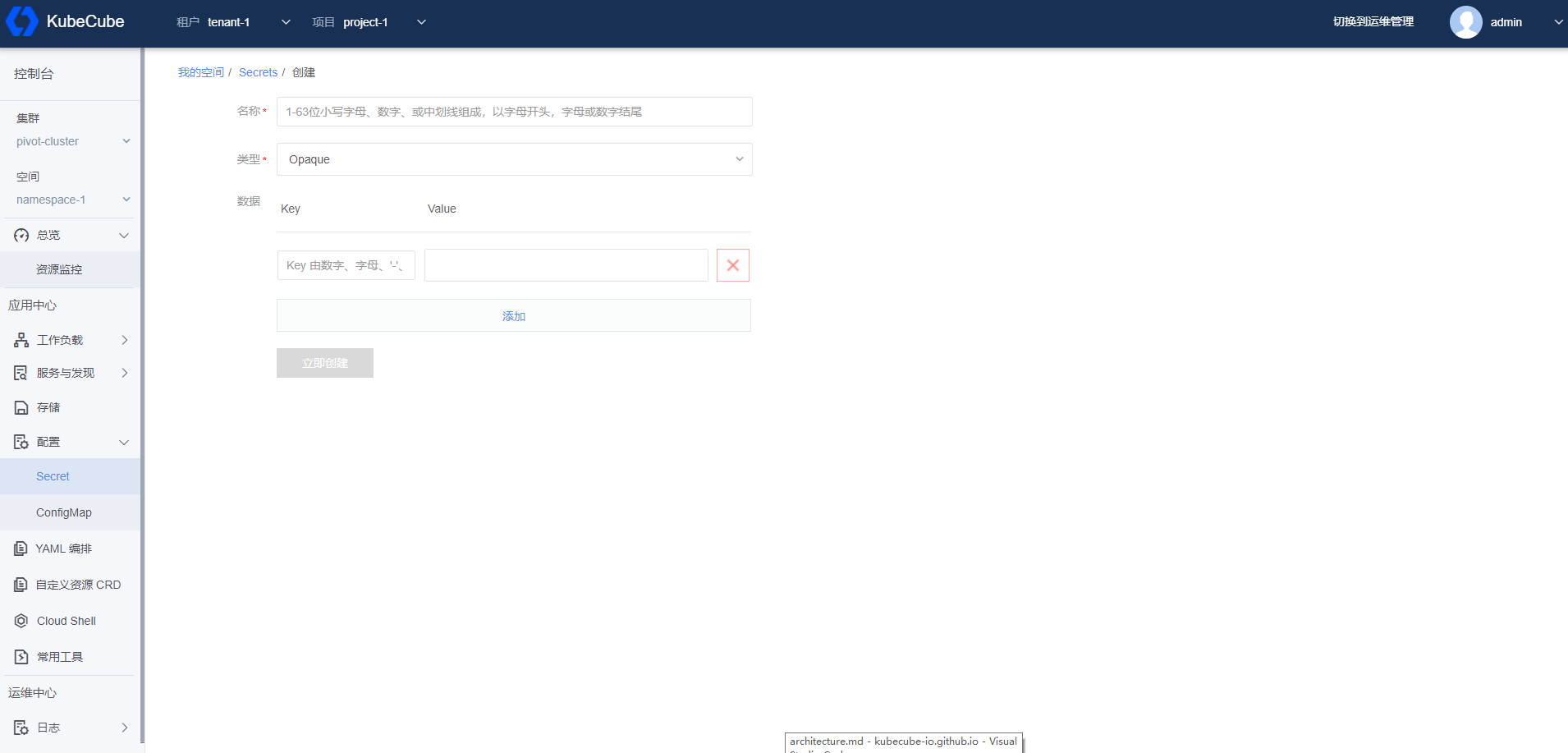

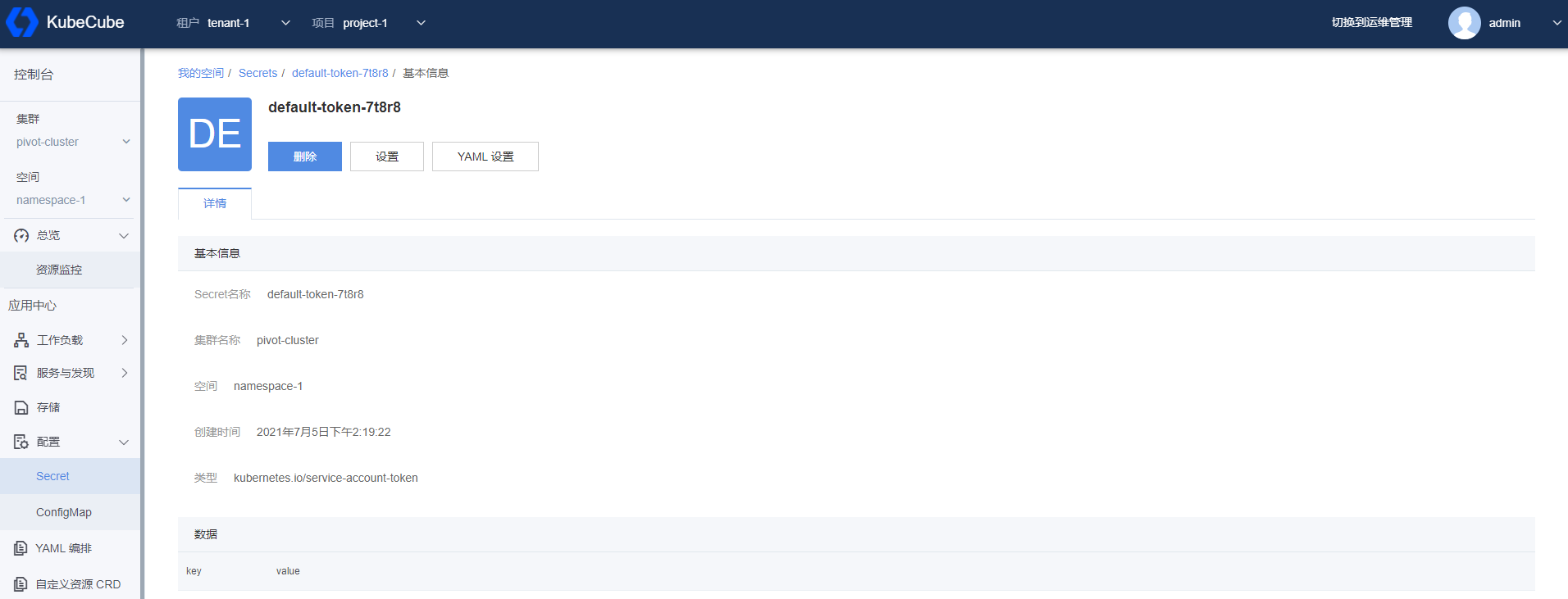

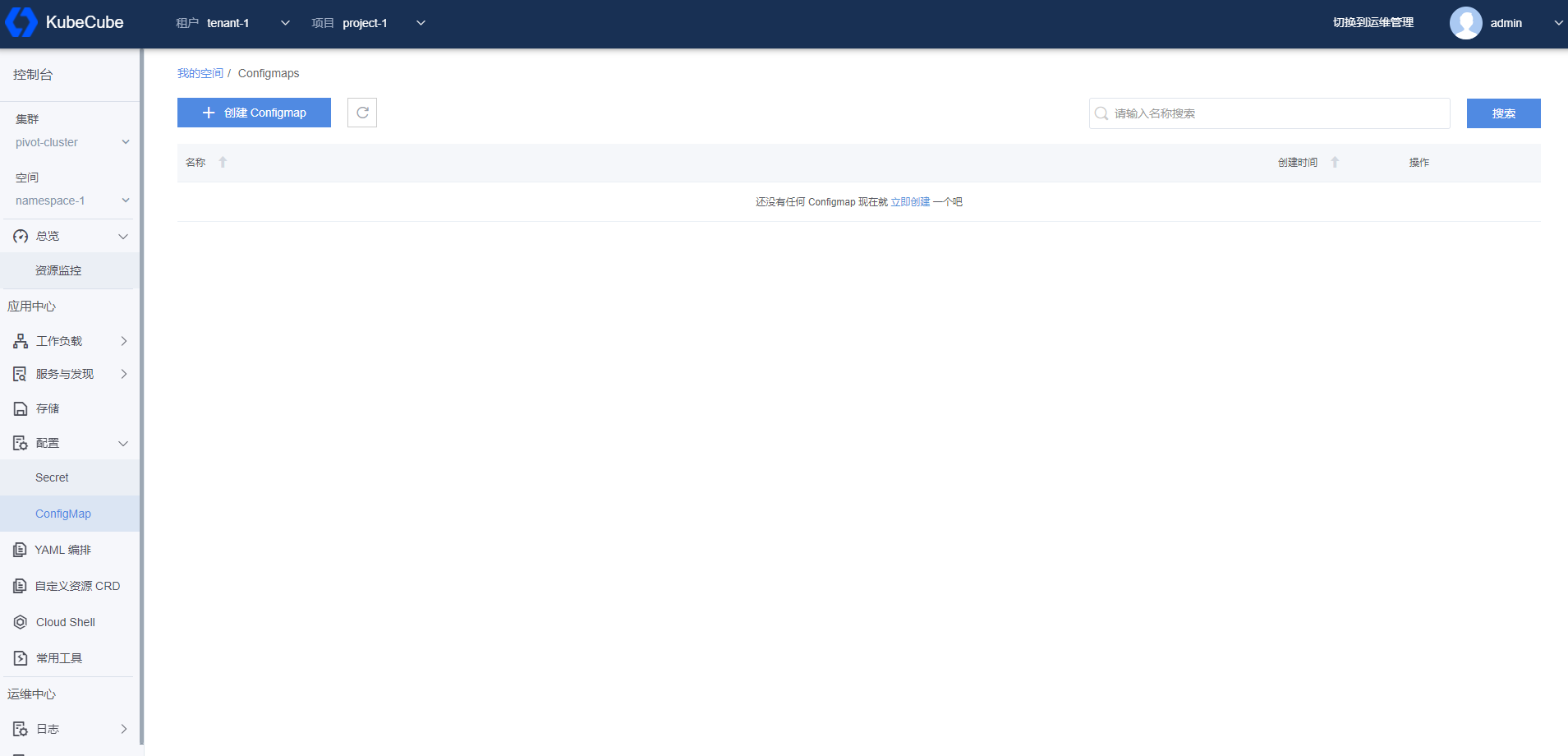

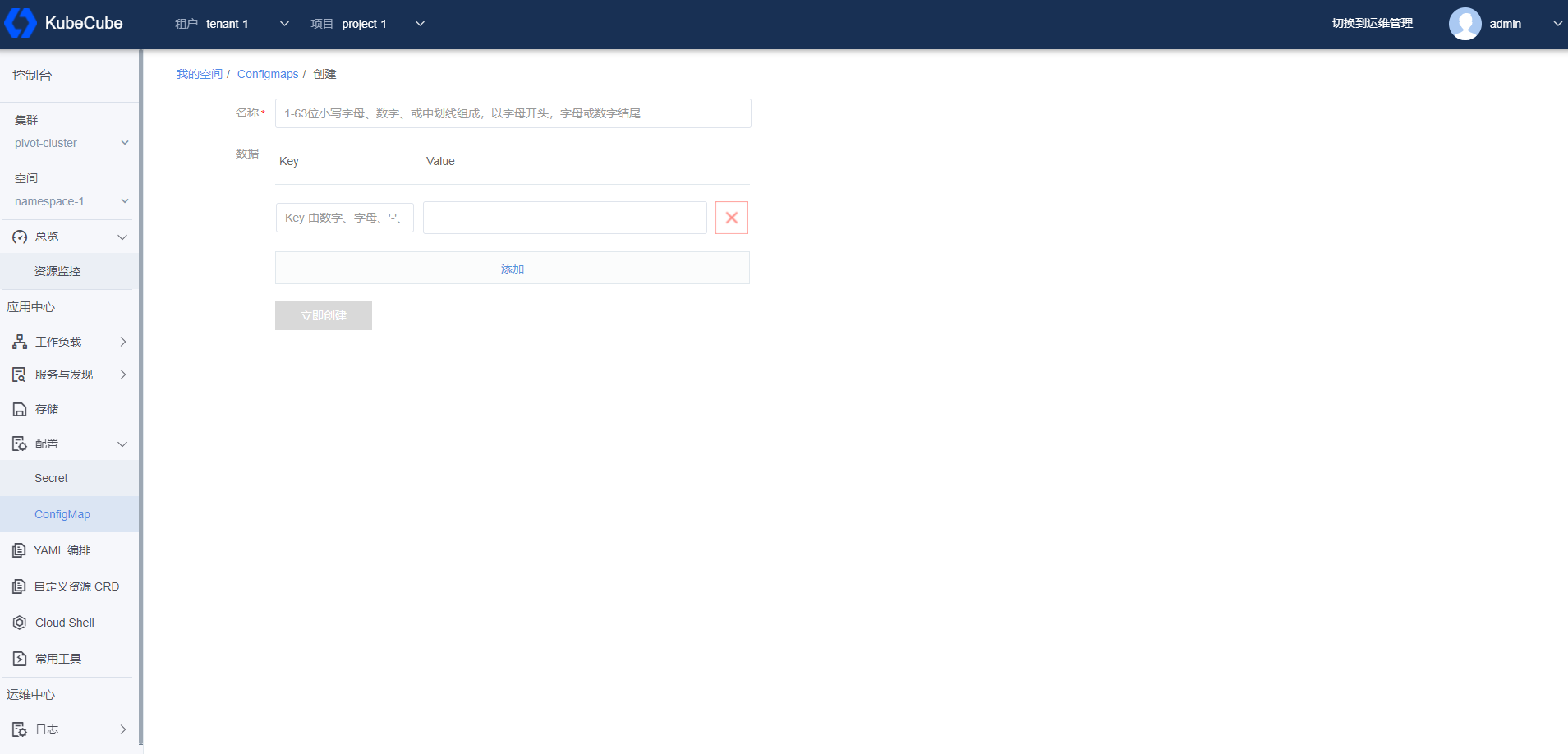

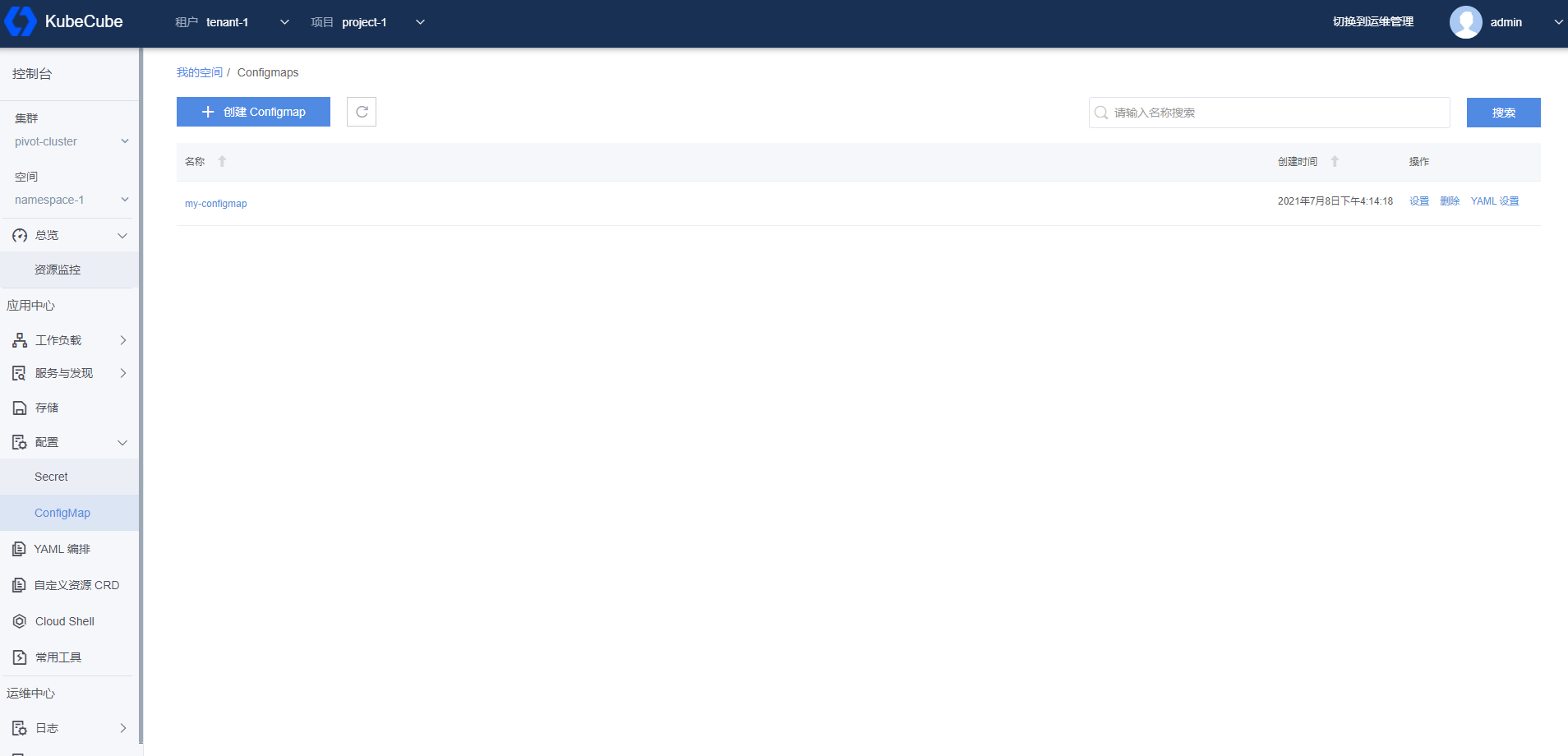

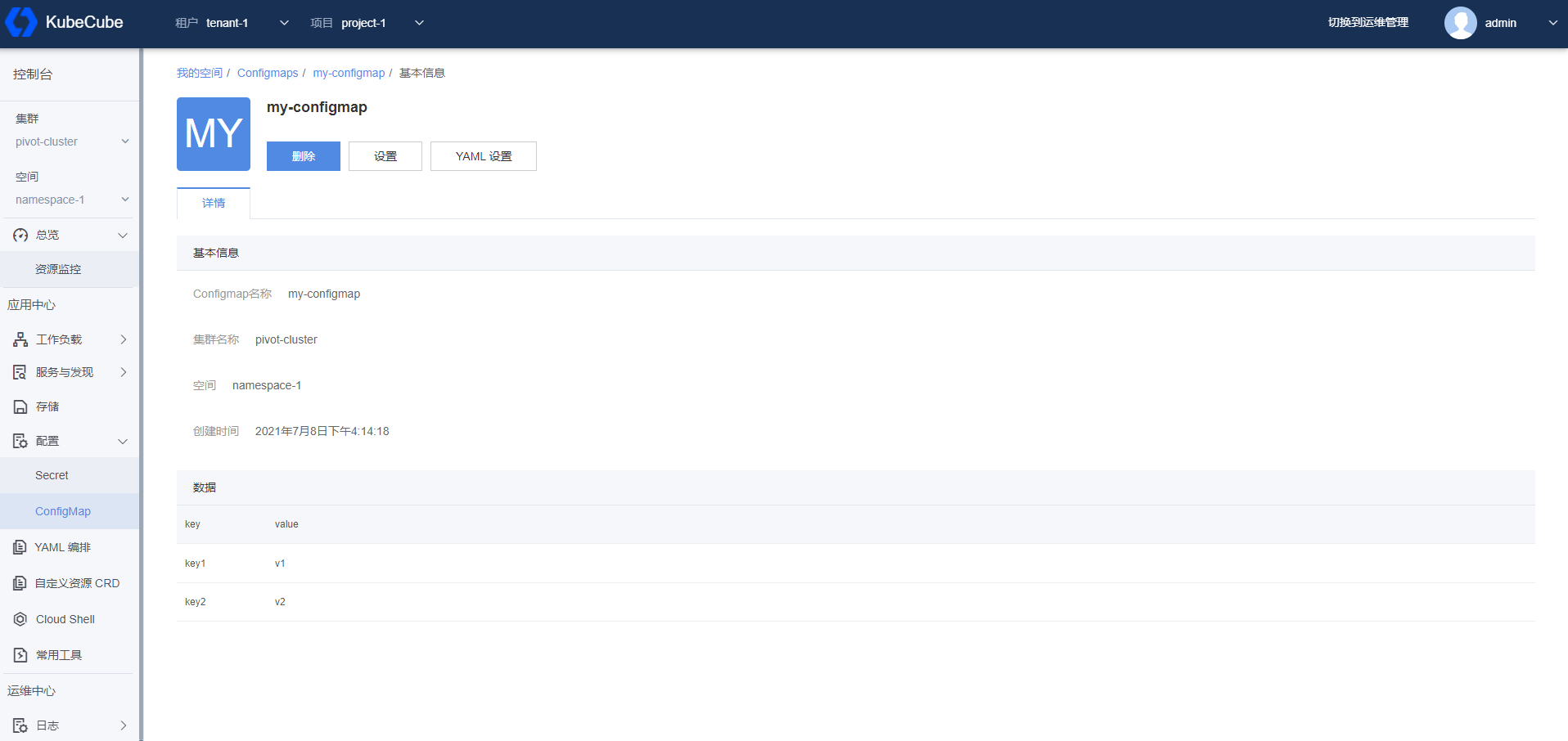

- 4.2.3: 配置管理

- 4.2.4: 存储管理

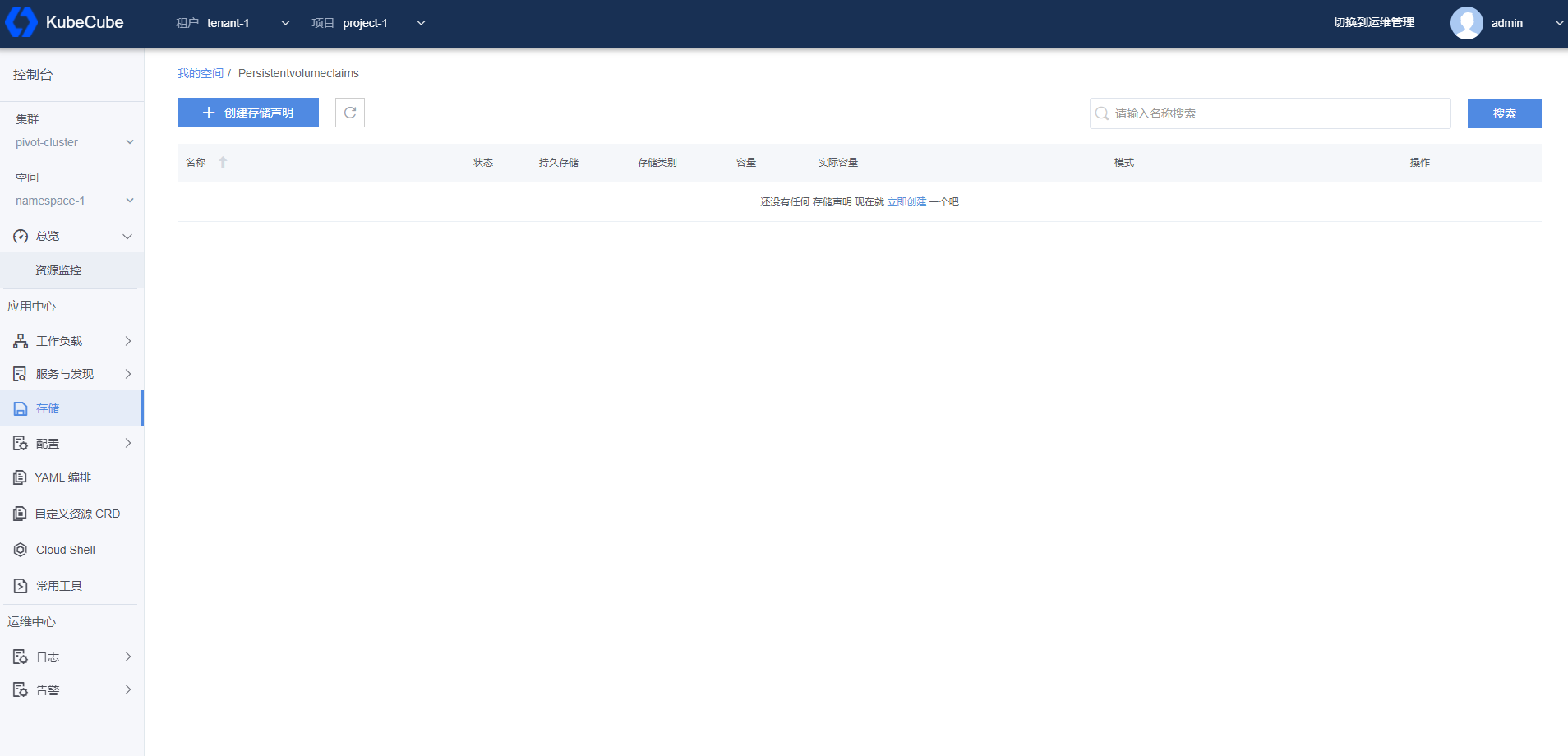

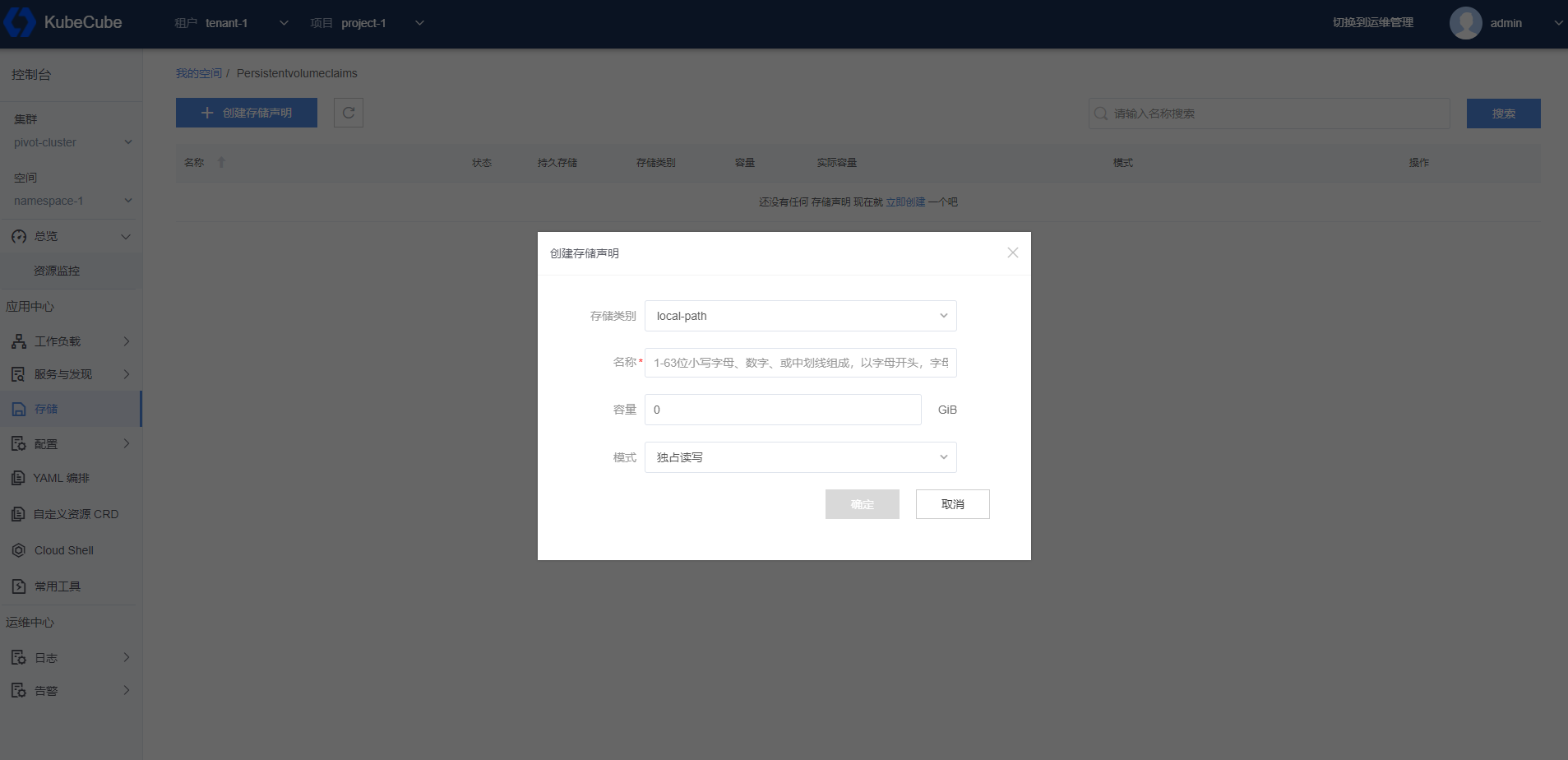

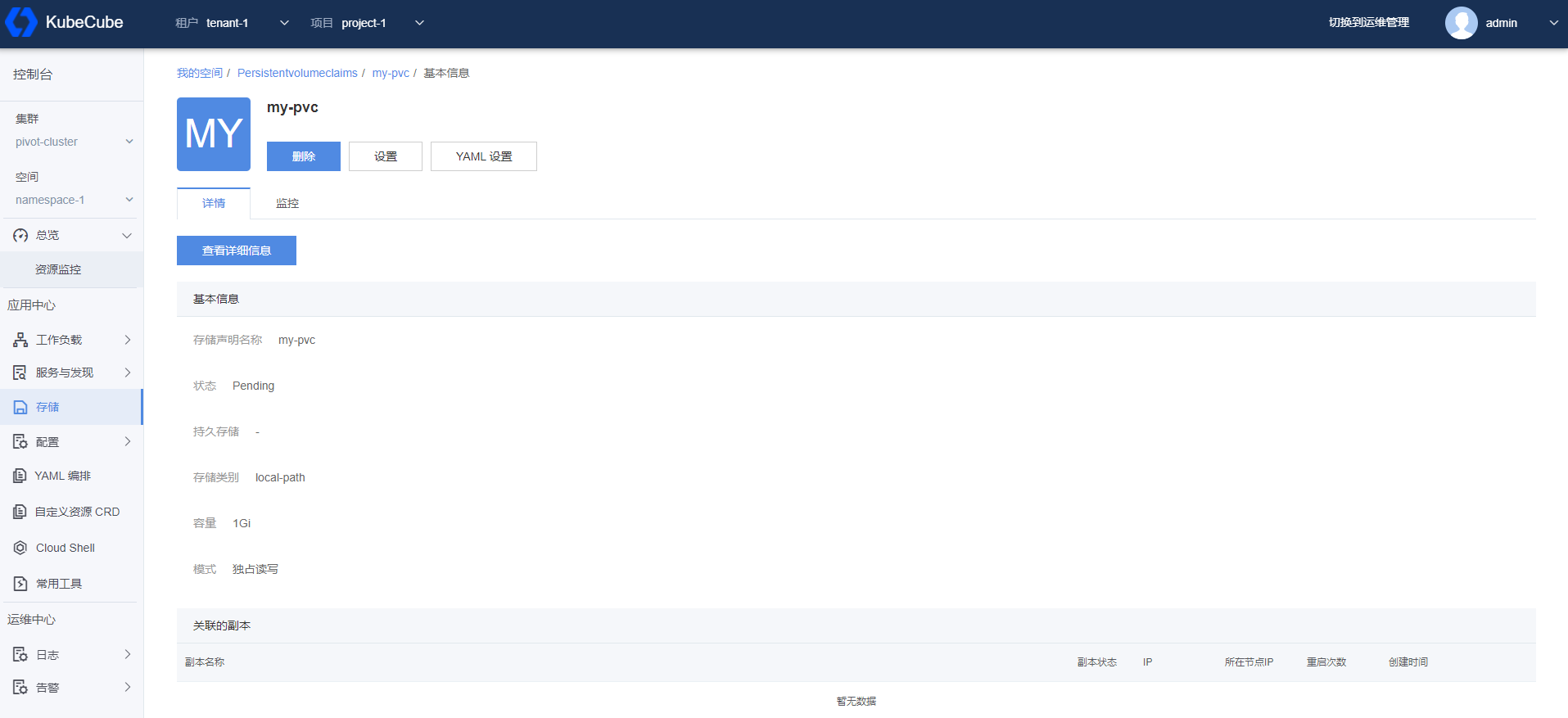

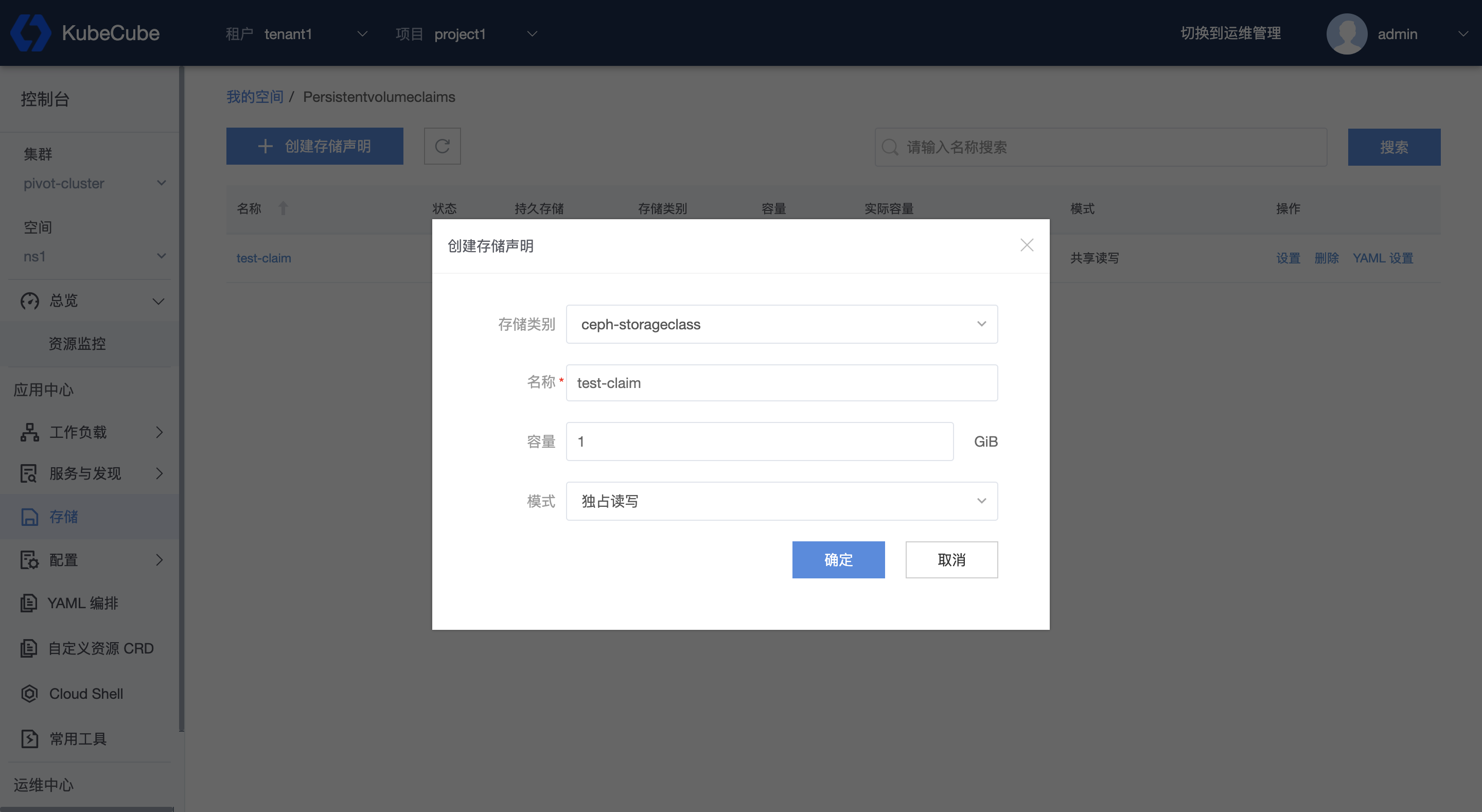

- 4.2.4.1: PVC

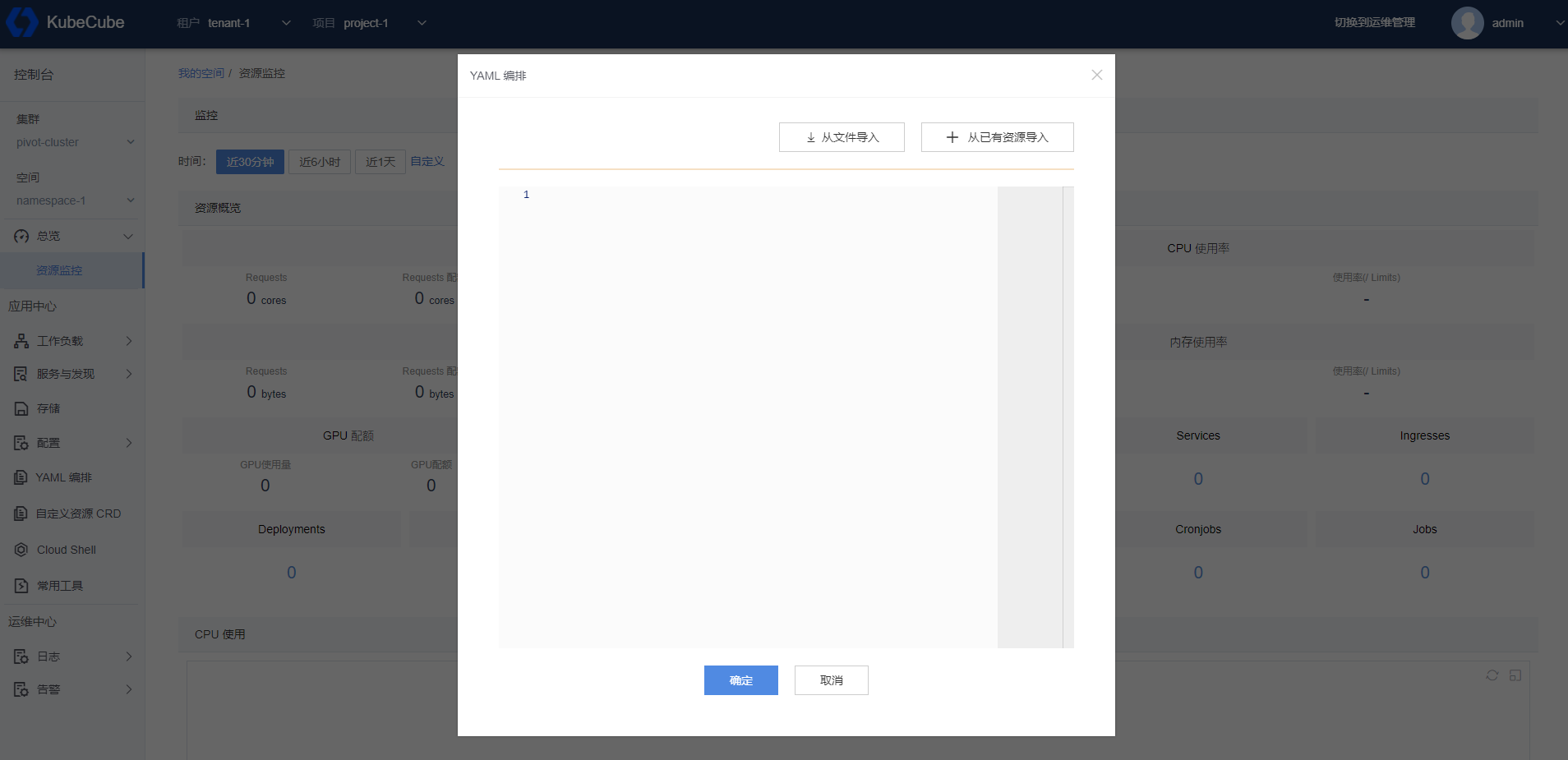

- 4.2.5: 其他

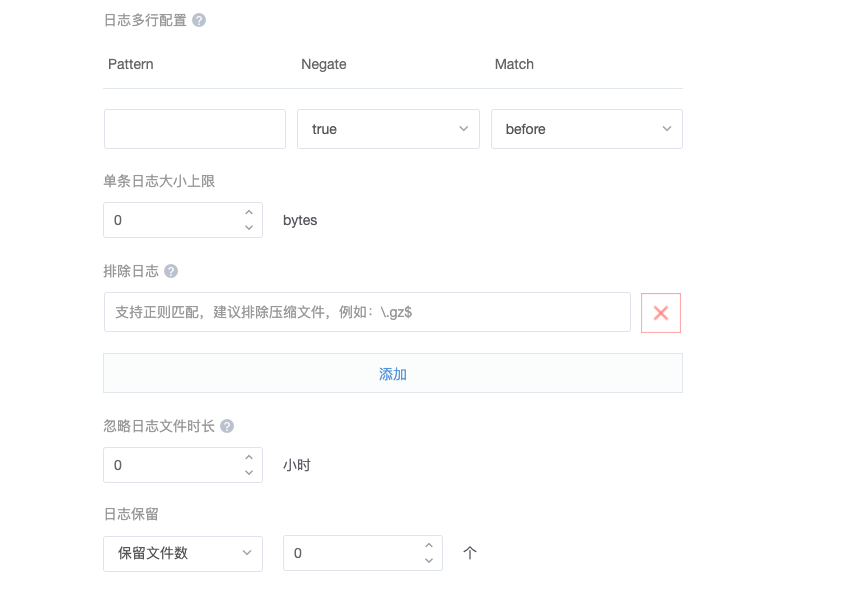

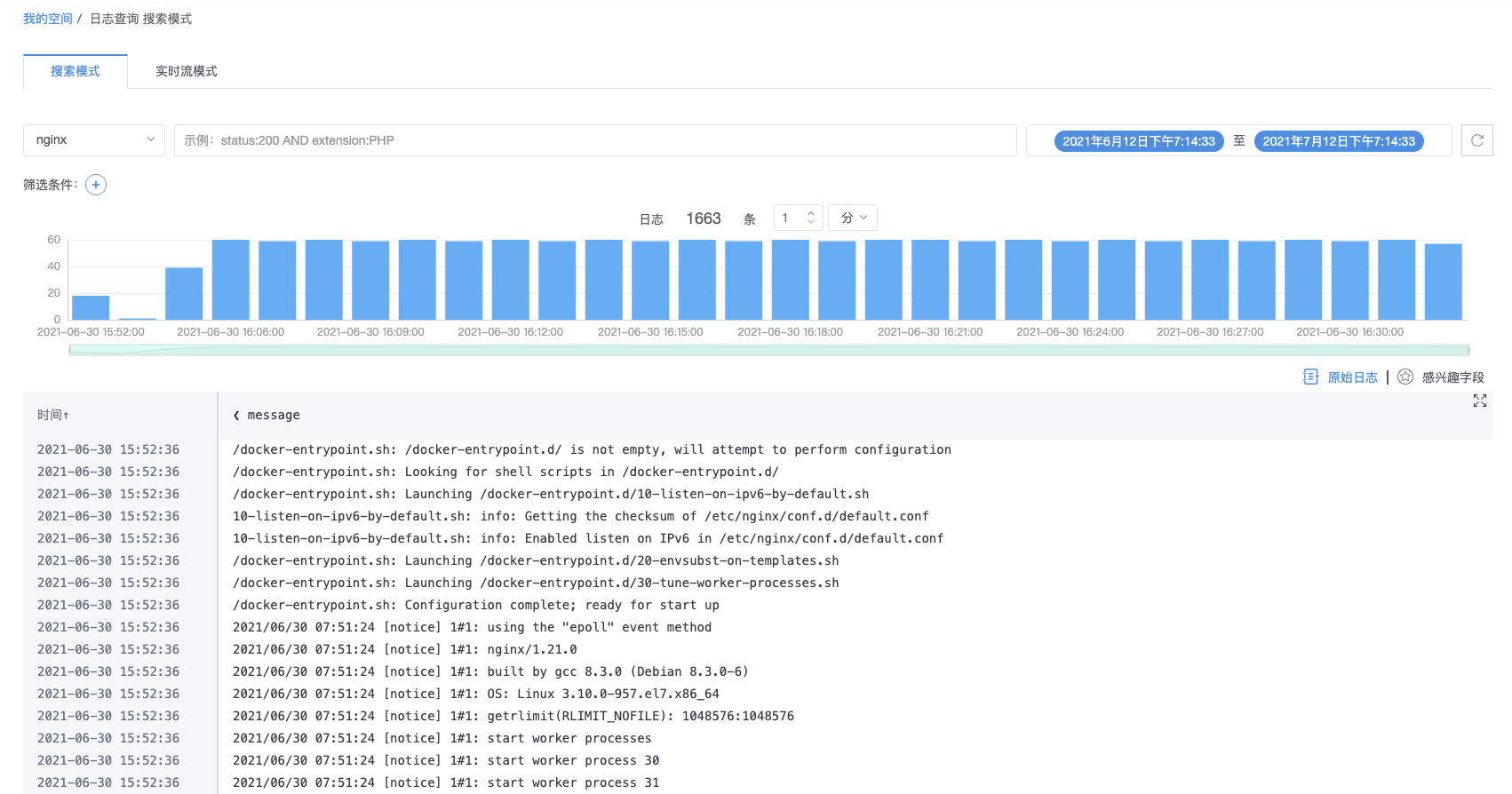

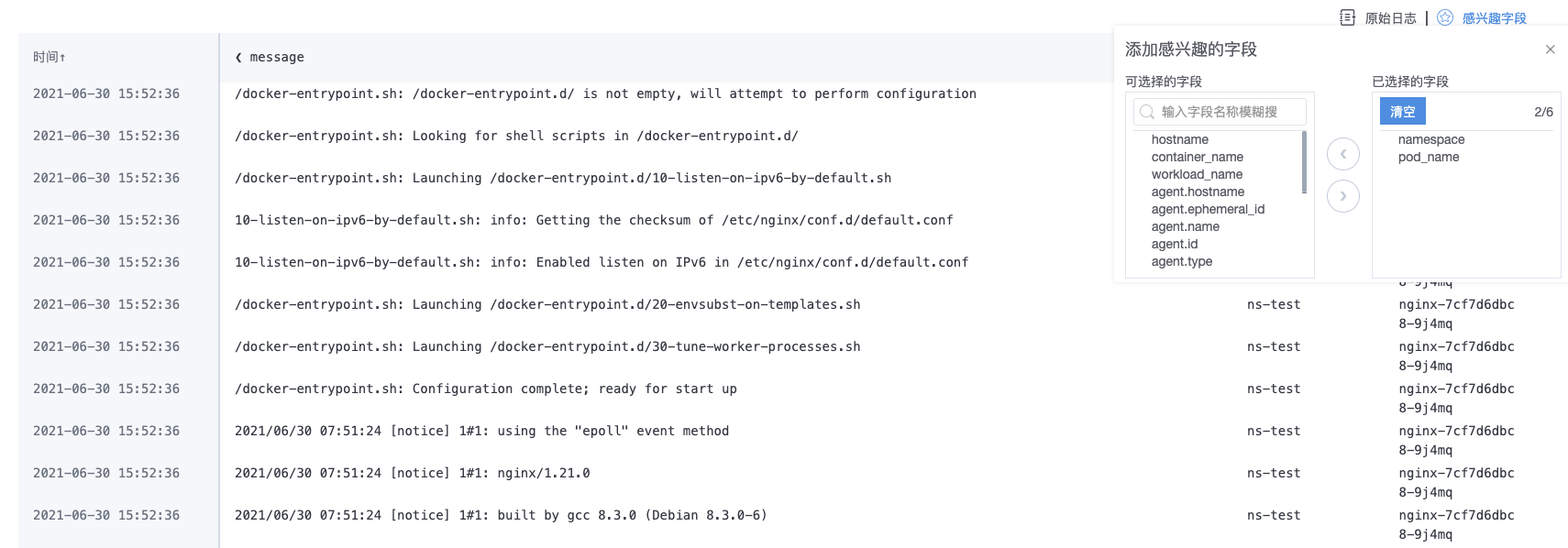

- 4.3: 日志

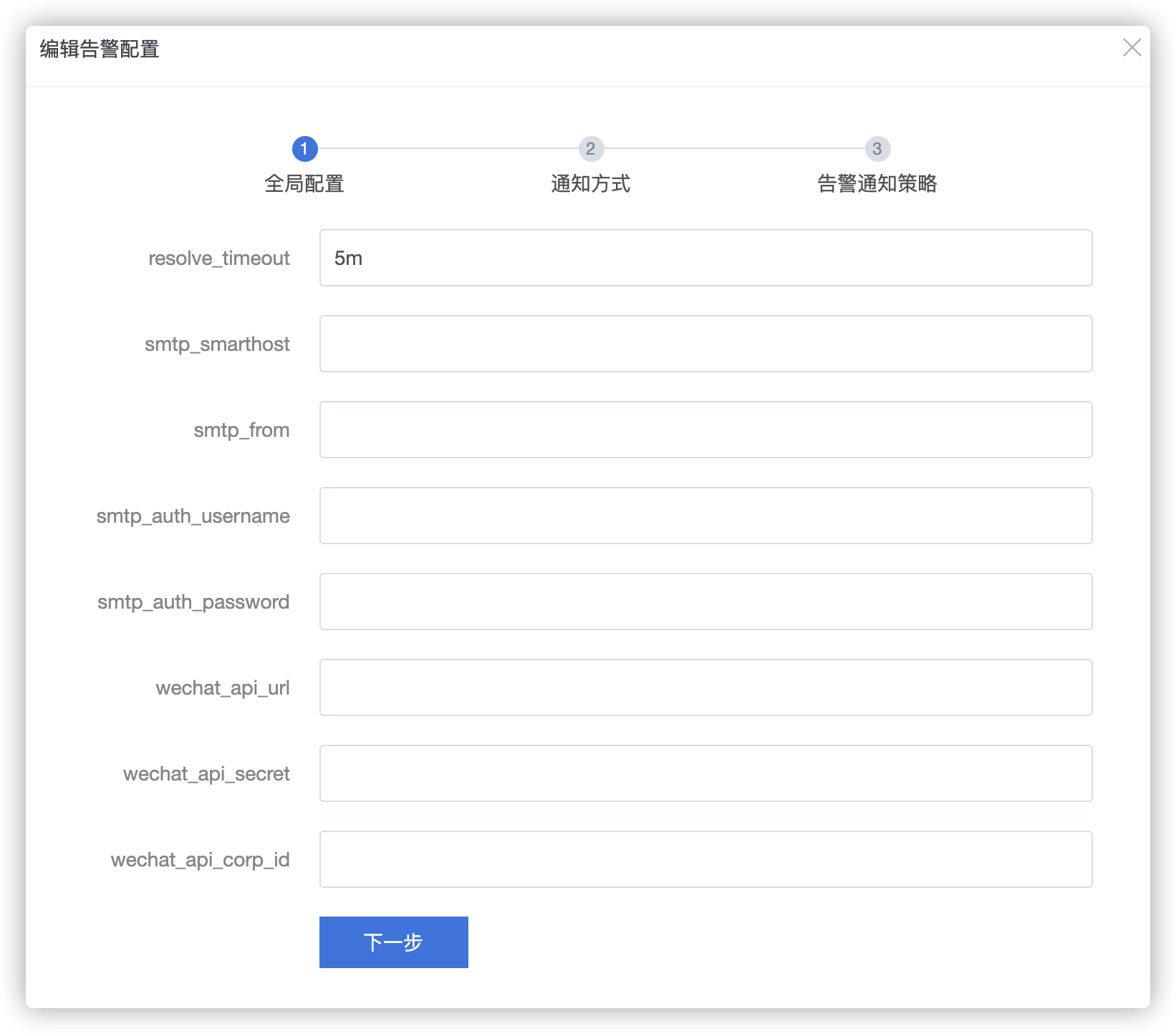

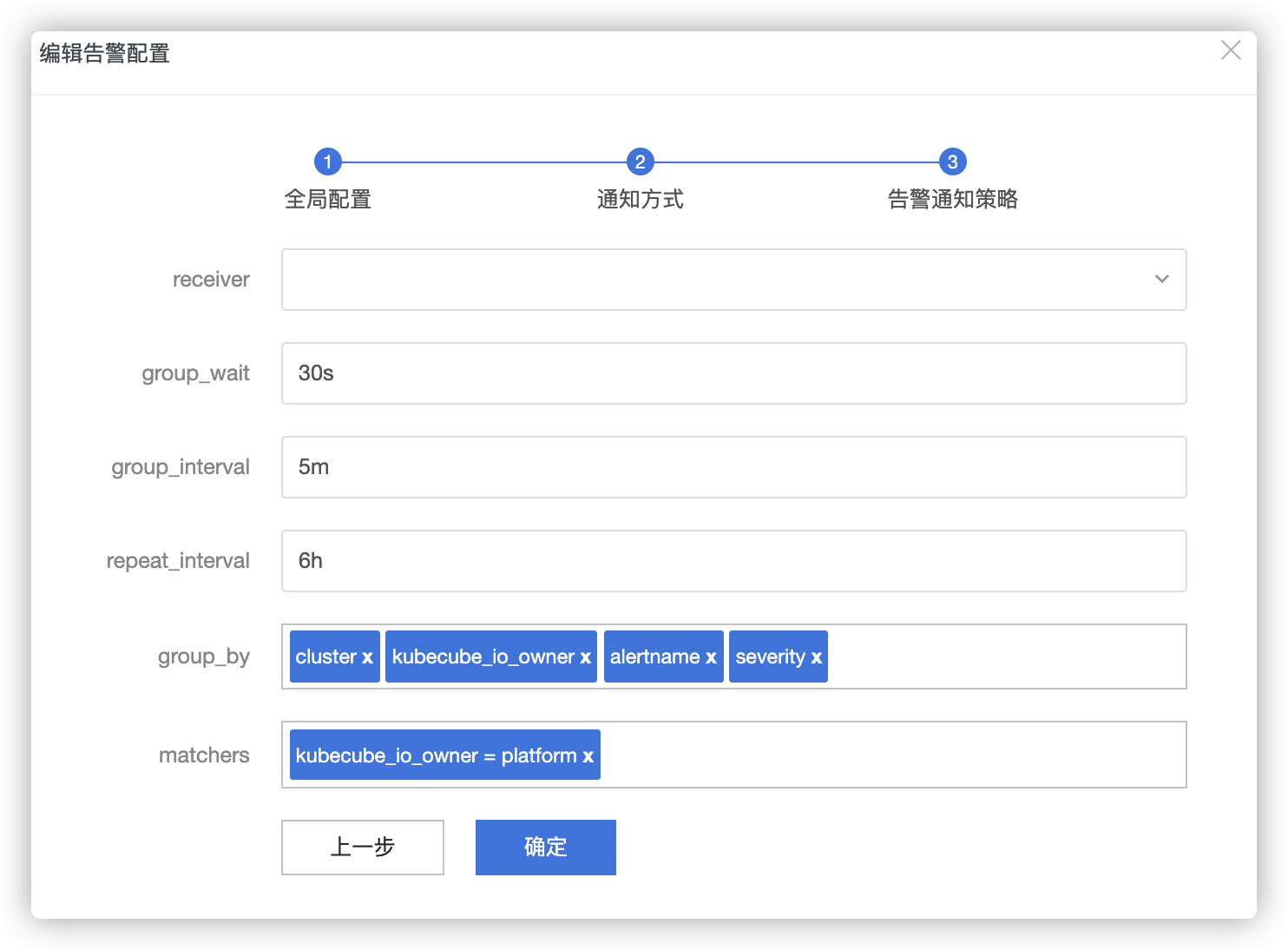

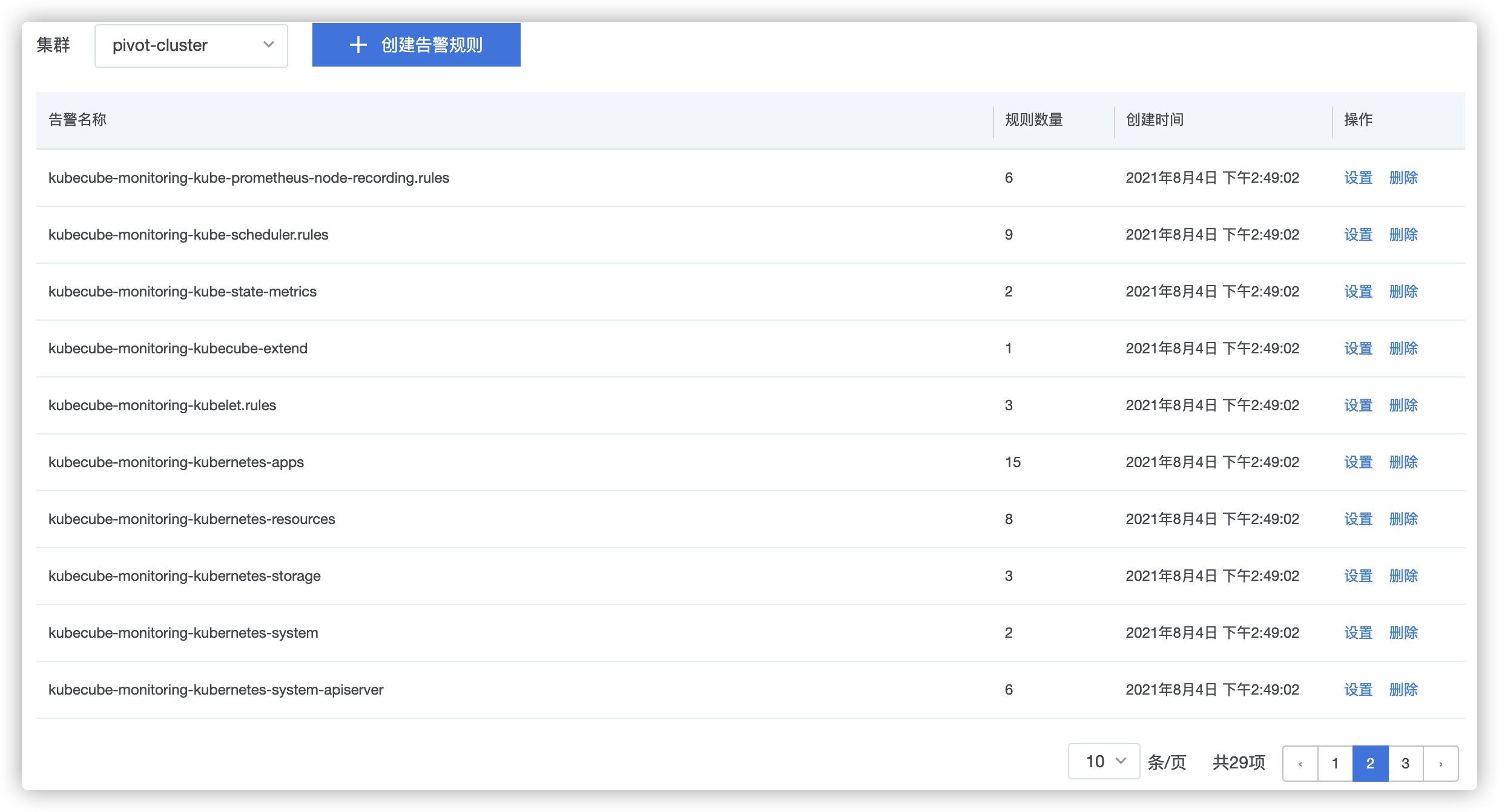

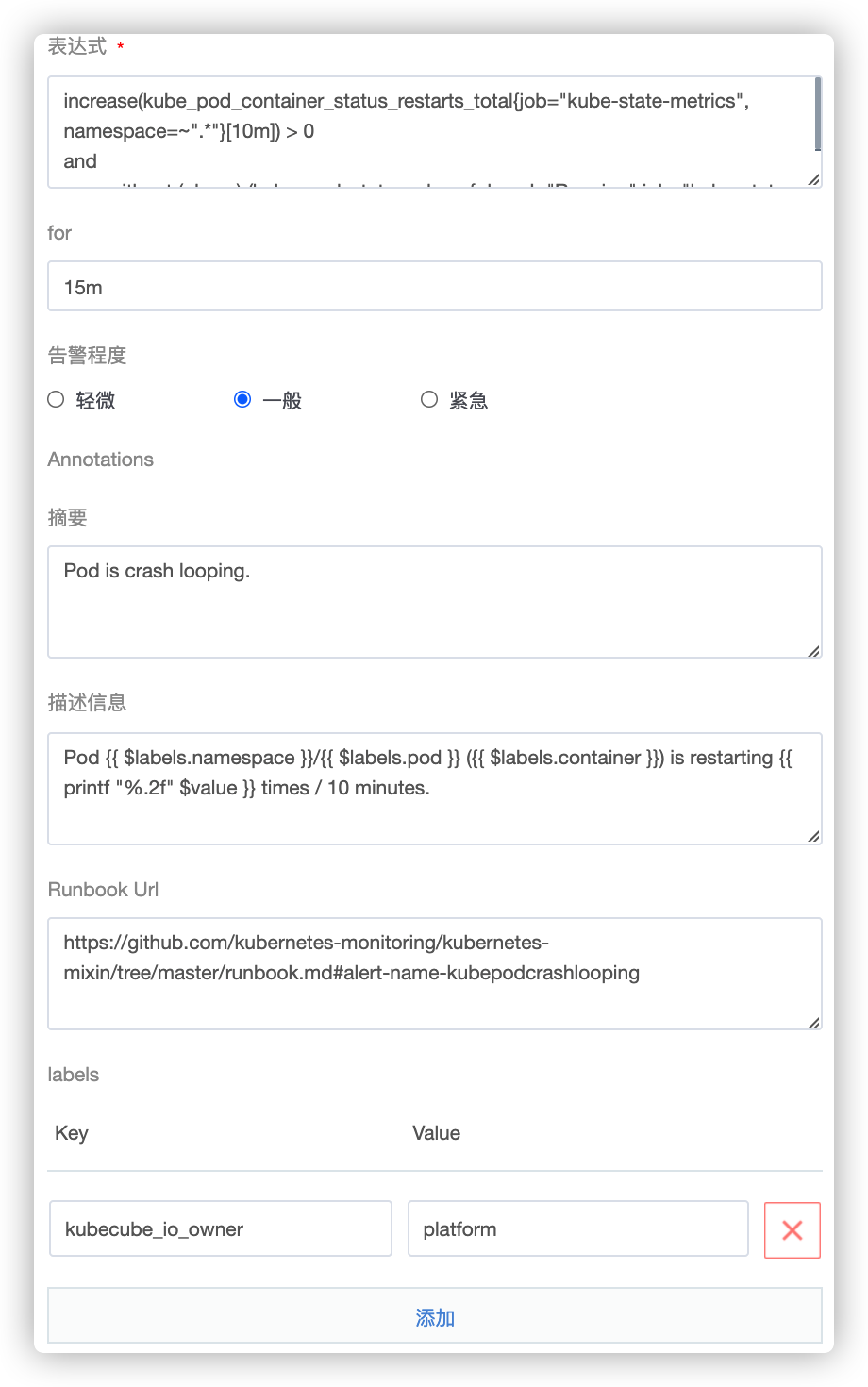

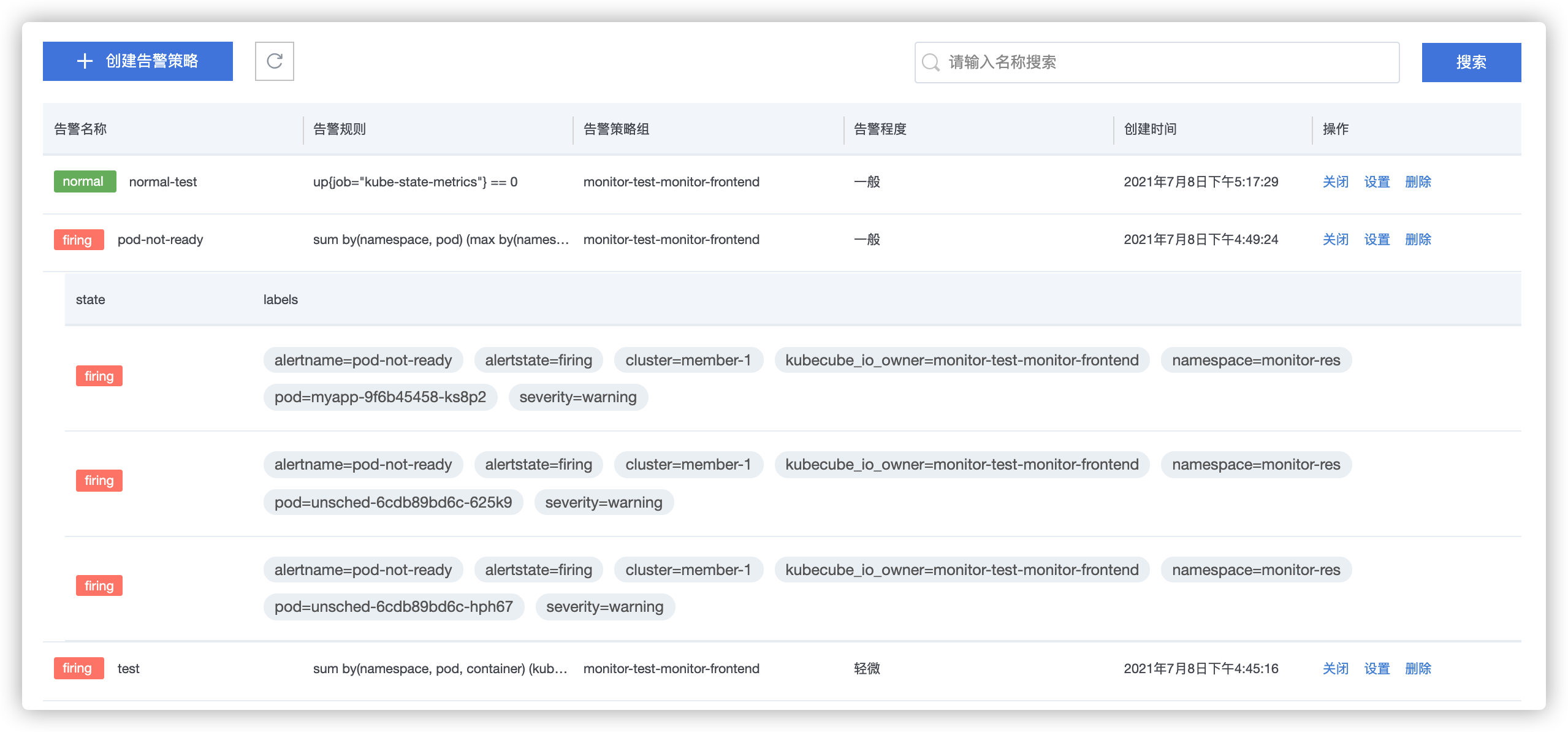

- 4.4: 告警管理

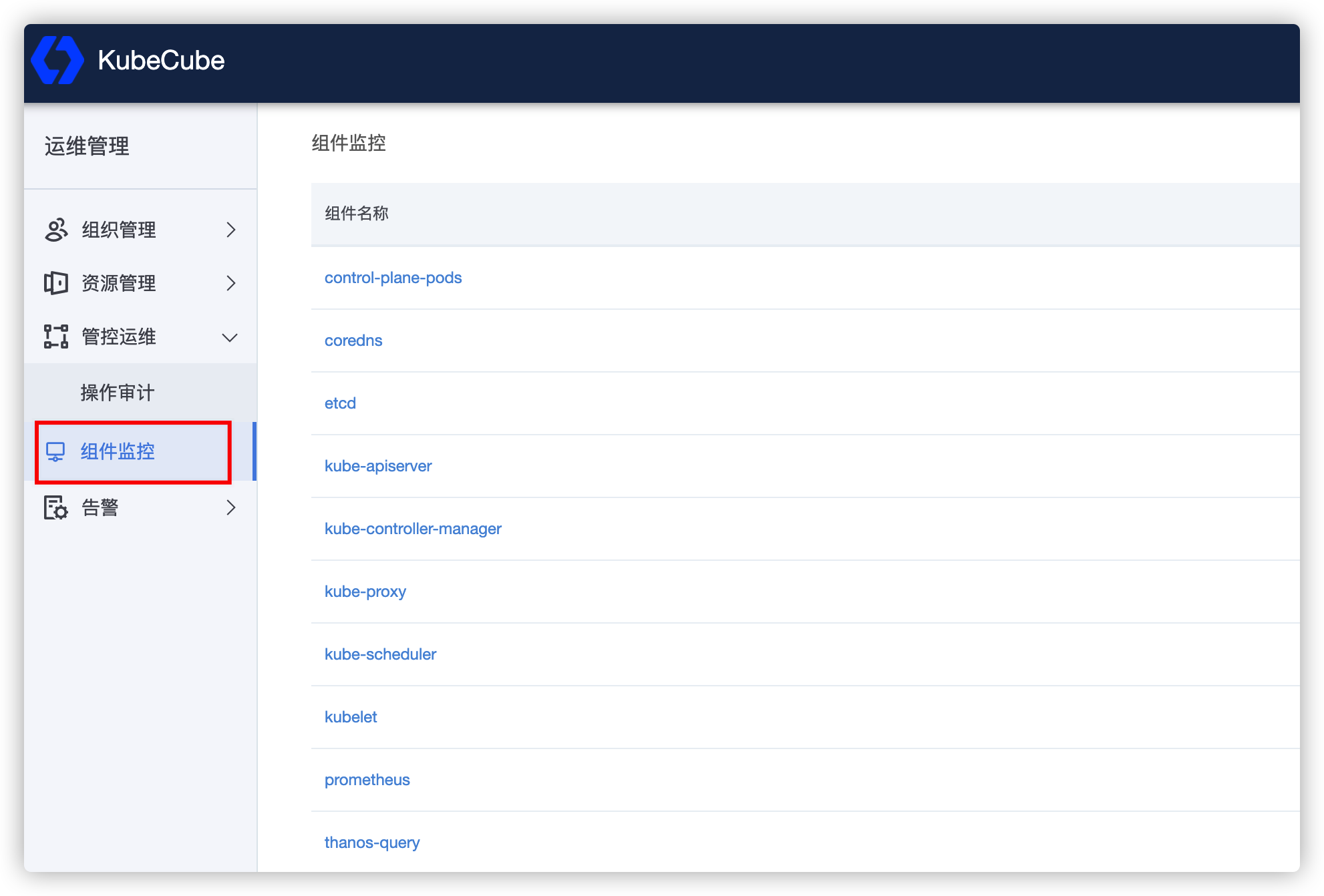

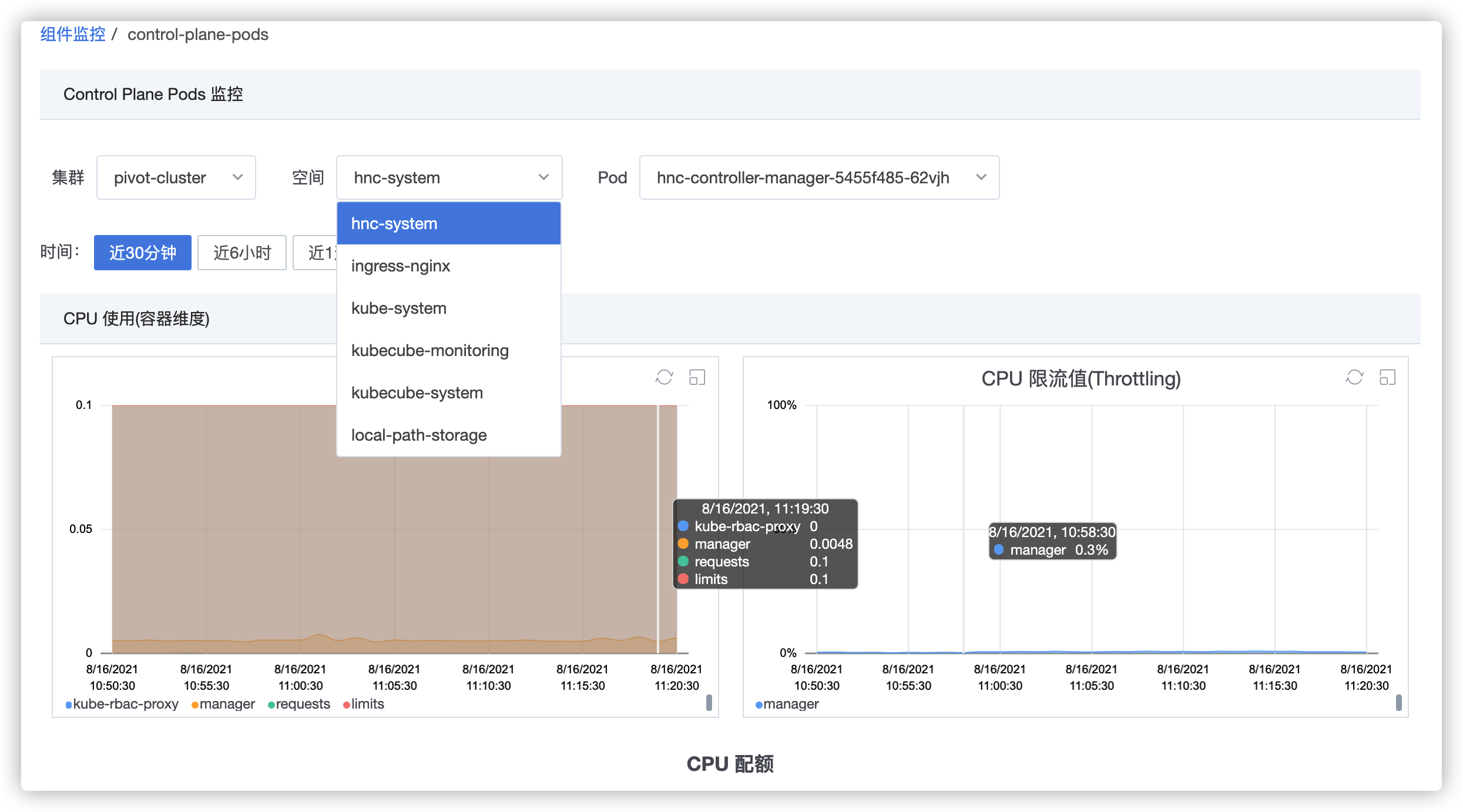

- 4.5: 集群监控

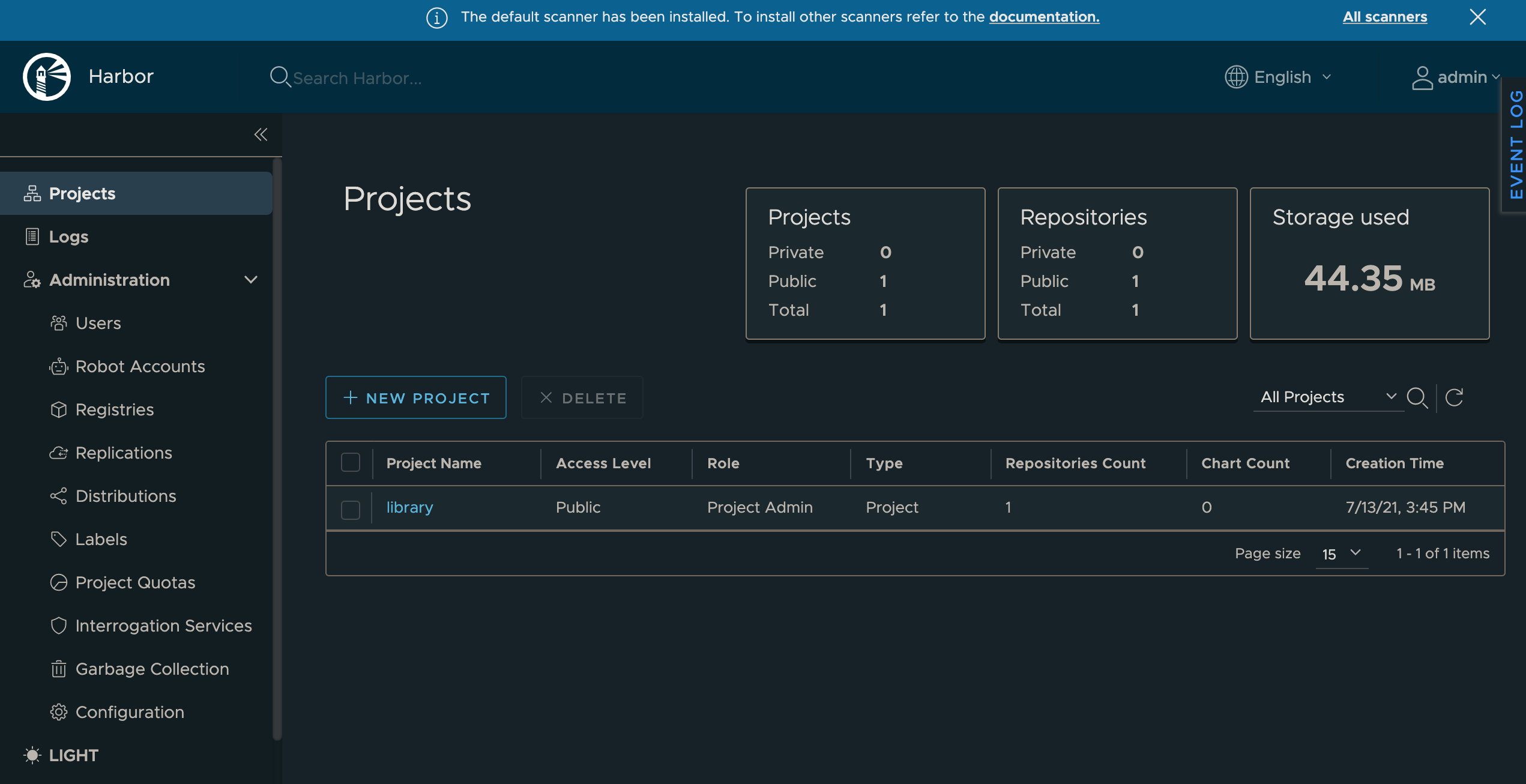

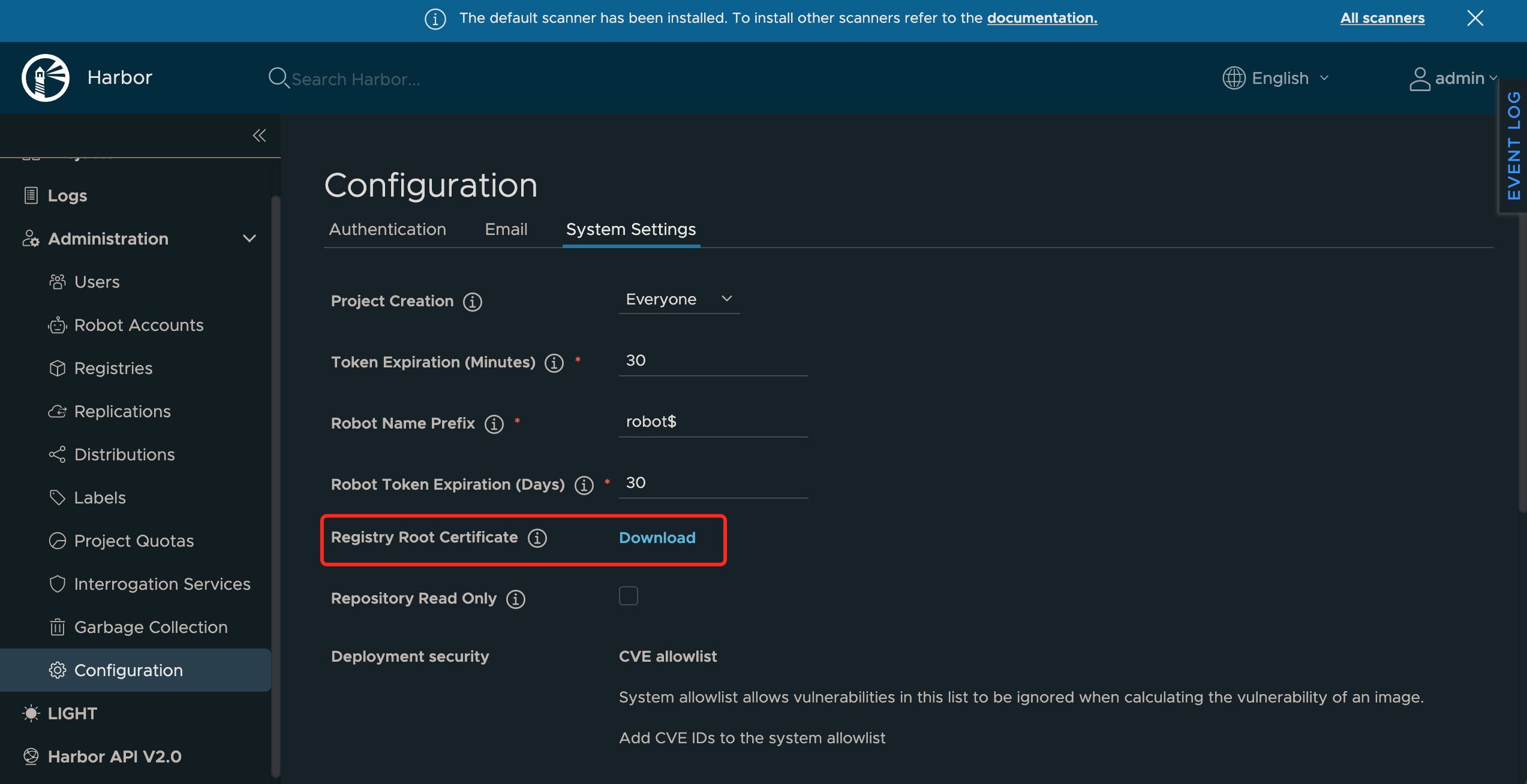

- 4.6: 镜像仓库

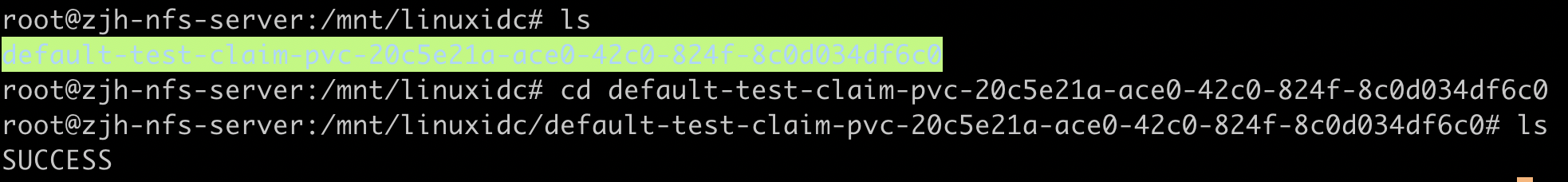

- 4.7: 网络存储

- 4.8: 排障系统

- 5: 开发指南

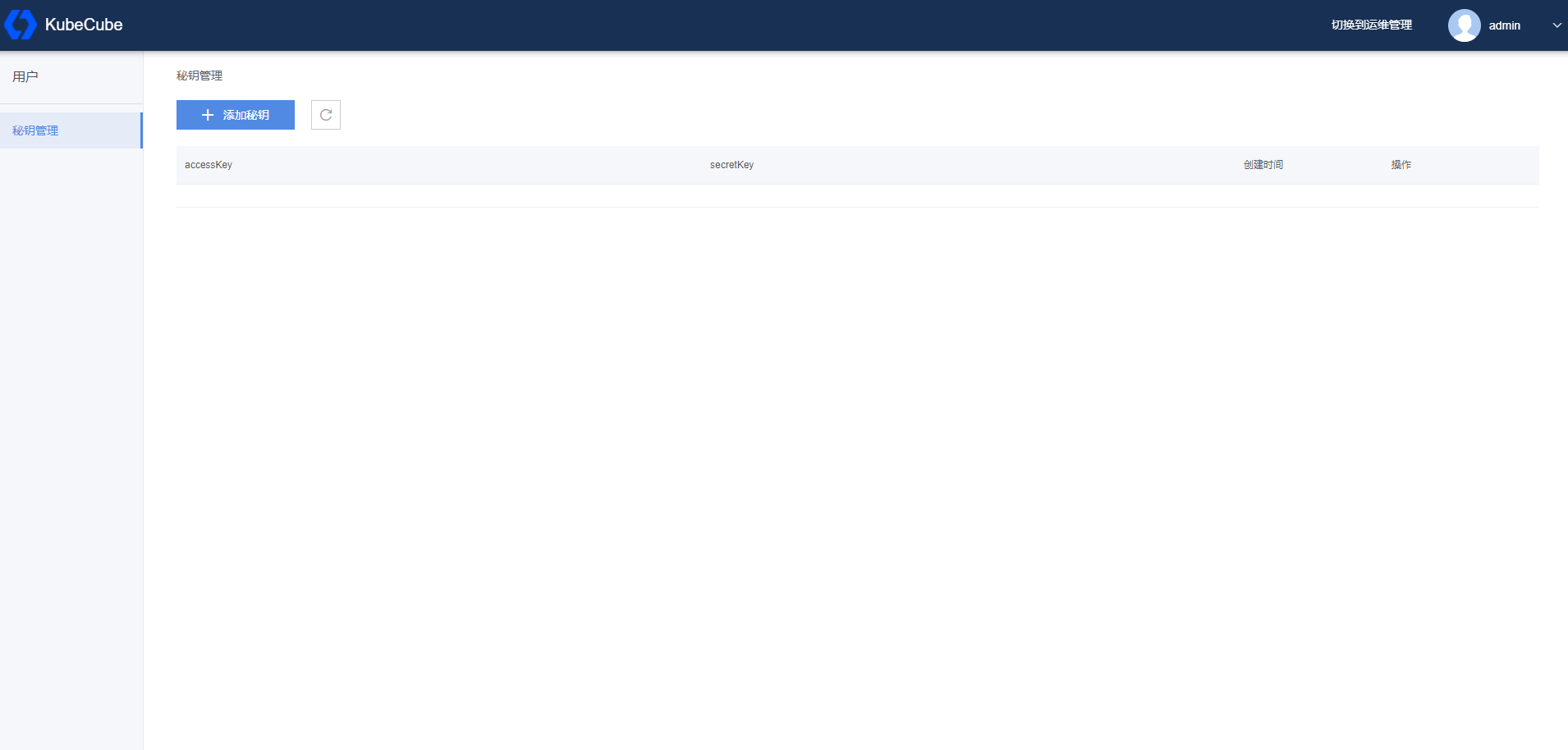

- 5.1: OpenAPI使用指南

- 5.2: 自研接口文档

- 5.3: 参与贡献

- 5.4: 如何调试

- 6: FAQ

1 - 介绍

1.1 - 产品介绍

KubeCube 是一个开源的企业级容器平台,为企业提供 Kubernetes 资源可视化管理以及统一的多集群多租户管理功能。KubeCube 可以简化应用部署、管理应用的生命周期和提供丰富的监控界面和日志审计功能,帮助企业快速构建一个强大和功能丰富的容器云管理平台。

项目特点

- 开箱即用

- 学习曲线平缓,集成统一认证鉴权、多集群管理、监控、日志、告警等功能,释放生产力

- 运维友好,提供 Kubernetes 资源可视化管理和统一运维,具备全面的自监控能力

- 快速部署,提供一键式 All in One 部署模式,提供生产级高可用部署

- 多租户管理

- 提供租户、项目、空间多级模型,以满足企业内资源隔离和软件项目管理需求

- 基于多租户模型,提供权限控制、资源共享/隔离等能力

- 统一的多K8s集群管理

- 提供多K8s集群的中央管理面板,支持集群导入

- 在多K8s集群中提供统一的身份认证和拓展 Kubernetes 原生 RBAC 能力实现访问控制

- 通过 WebConsole、CloudShell 快速管理集群资源

- 集群自治

- 当 KubeCube 管理集群停机维护时,各业务集群可保持自治,保持正常的访问控制,业务 Pod 无感知

- 功能热插拔

- 提供最小化安装,用户可以根据需求随时开关功能

- 可热插拔,无需重启服务

- 多种接入方式

- 支持 Open API:方便对接用户现有系统

- 兼容 Kubernetes 原生 API:无缝兼容现有 Kubernetes 工具链,如 kubectl

- 无供应商锁定

- 可导入任意标准 Kubernetes 集群,更好的支持多云/混合云

- 其他功能

- 操作审计

- 丰富的可观测性功能

解决的问题

- 企业上云:简化学习曲线,帮助企业以较小的成本完成容器云平台搭建,实现应用快速上云需求,辅助企业推动应用上云。

- 资源隔离:多租户管理提供租户、项目和空间三个层级的资源隔离、配额管理和权限控制,完全适配企业级私有云建设的资源和权限管控需求。

- 集群规模限制:统一的容器云管理平台,可以管理多个业务 Kubernetes 集群,数量不设上限。既能通过横向扩容新增 Kubernetes 集群的方式解决单个 Kubernetes 集群规模的限制,又可以满足不同业务条线要求独占集群的需求。

- 丰富的可观测性:支持监控告警和日志采集能力,提供丰富的工作负载监控指标界面,提供集群维度的监控界面,提供灵活的日志查询能力。

1.2 - 产品架构

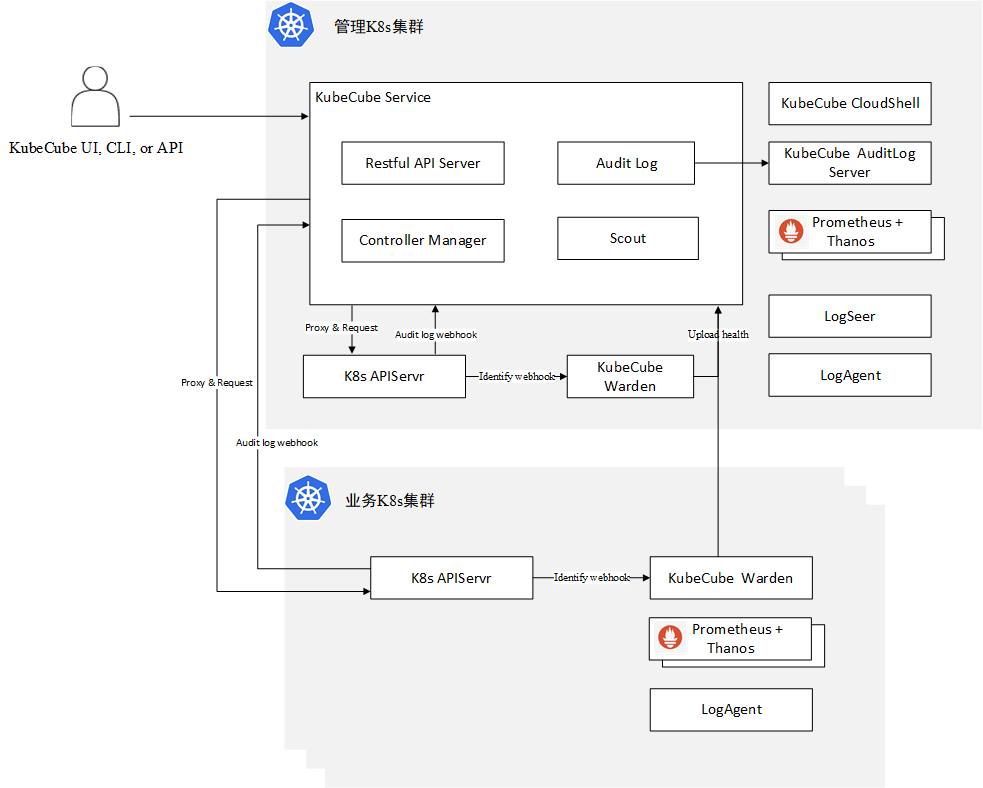

KubeCube 产品由 KubeCube Service、Warden、CloudShell 和 AuditLog Server 等组件组成,除了 Warden 部署在各个 Kubernetes 集群充当认证代理,其余组件均部署在管理集群。

下图描述的 KubeCube 整体产品架构,包括与用户的交互,与 Kubernetes API Server 交互,Prometheus 监控和自研日志采集组件。

- 用户可以通过 KubeCube UI、CLI 指令、Open API 访问 Kubecube 服务和 Kubernetes 资源,其中 CLI 功能主要由 CloudShell 组件提供。

- KubeCube Service 实现统一认证服务,透传代理 Kubernetes 资源请求,和提供更丰富的资源请求扩展接口。KubeCube Servie 包含四个组件:Restful API Server 提供API支持,AuditLog 负责审计日志收集和发送审计日志到处理组件 KubeCube AuditLog Server,Controller Manager 实现资源的 Reconcile 和 Validate Webhook ,Scout 实现各个集群之间资源的同步。

- K8s APIServer 使用 Admission Webhook 的形式向 Warden(哨兵守卫)请求身份认证,并将操作审计日志上传给 KubeCube Service。

- KubeCube Warden(守望者)负责身份认证和集群健康上报,部署在每一个业务集群,即使业务集群与管理集群脱离,依然可以实现认证和集群自治。

- 集成 Prometheus + AlertManager + Thanos 监控告警解决方案和自研的容器日志采集解决方案 Logseer + Logagent。

- 考虑到性能表现和可维护性因素,我们建议使用管理 Kubernetes 集群和业务 Kubernetes 集群,分开部署 Kubecube 服务和 Kubernetes 工作负载,支持对接多个业务 Kubernetes 集群。

2 - 快速入门

2.1 - 快速部署

用户可以通过 All-In-One 的方式,或者在已有 K8s 集群上安装的方式来快速部署 KubeCube

部署环境确认

请根据 部署环境要求 确认快速部署的前置要求

All In One 部署

在 Linux 上部署单节点 K8s 以及 KubeCube

在已有 K8s 集群上部署

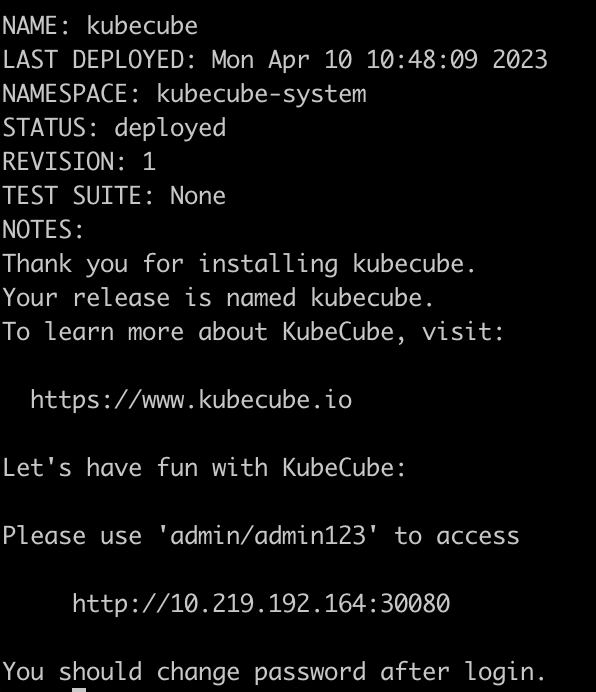

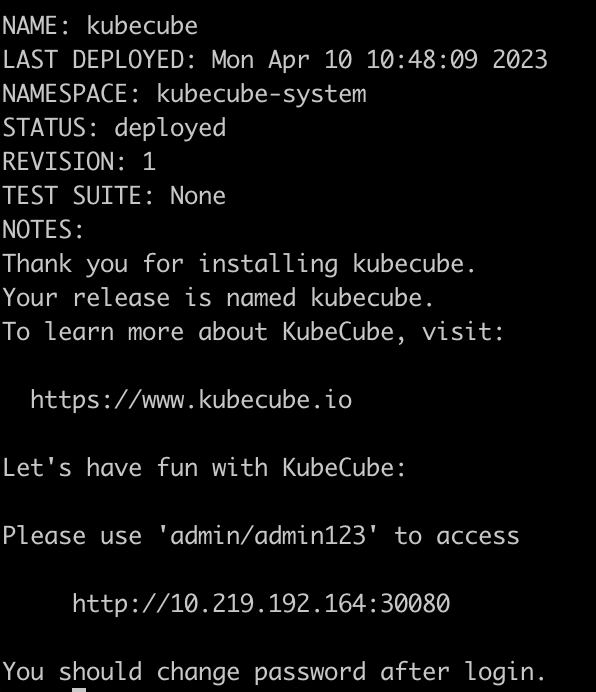

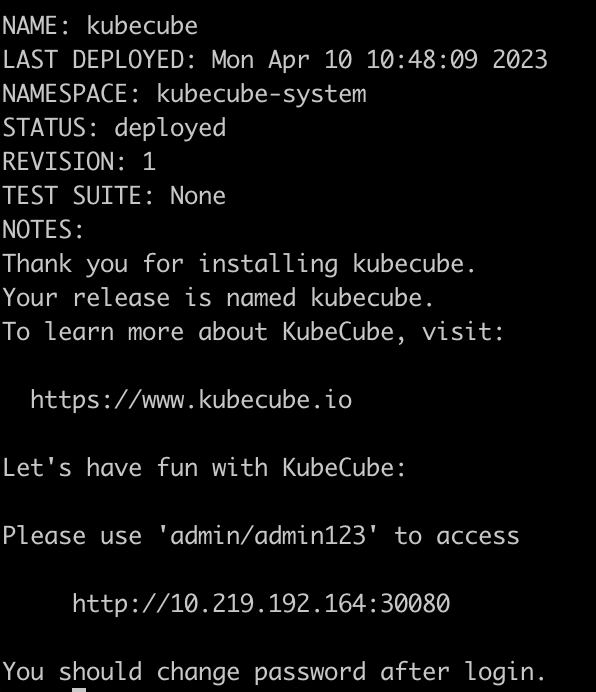

等待部署完成

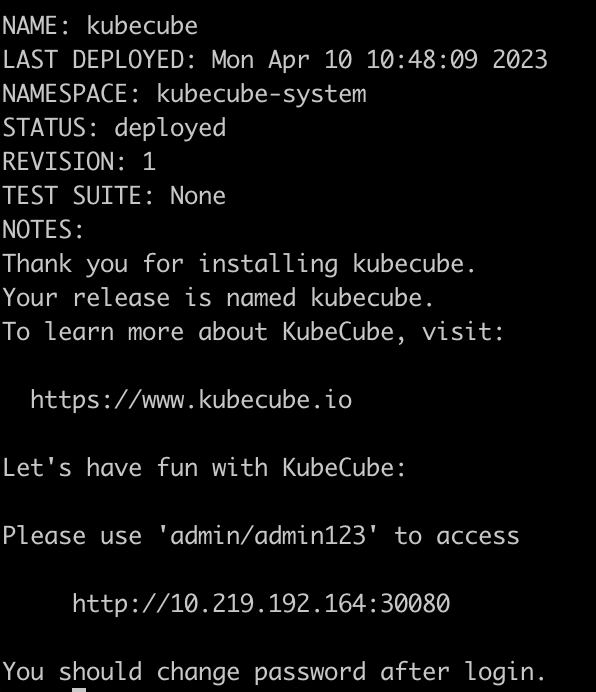

KubeCube 部署完成后,请根据提示信息登陆 console 管理页面

使用 admin 账户登陆 console

⚠️请在登陆后修改 admin 用户的密码

2.2 - 快速体验

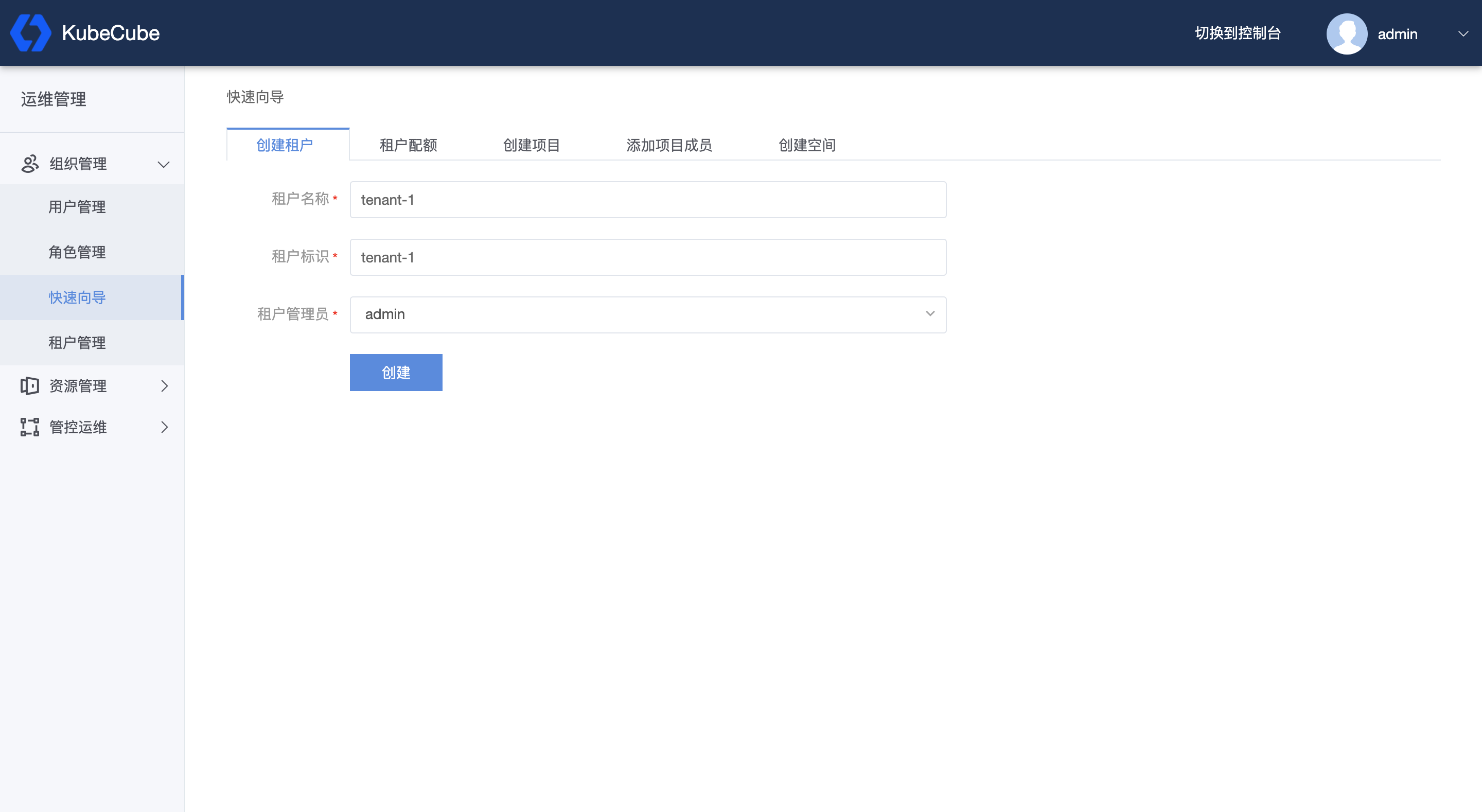

创建租户、项目、空间

使用管理员账号登录后,展开左侧【组织管理】菜单,点击快速向导。

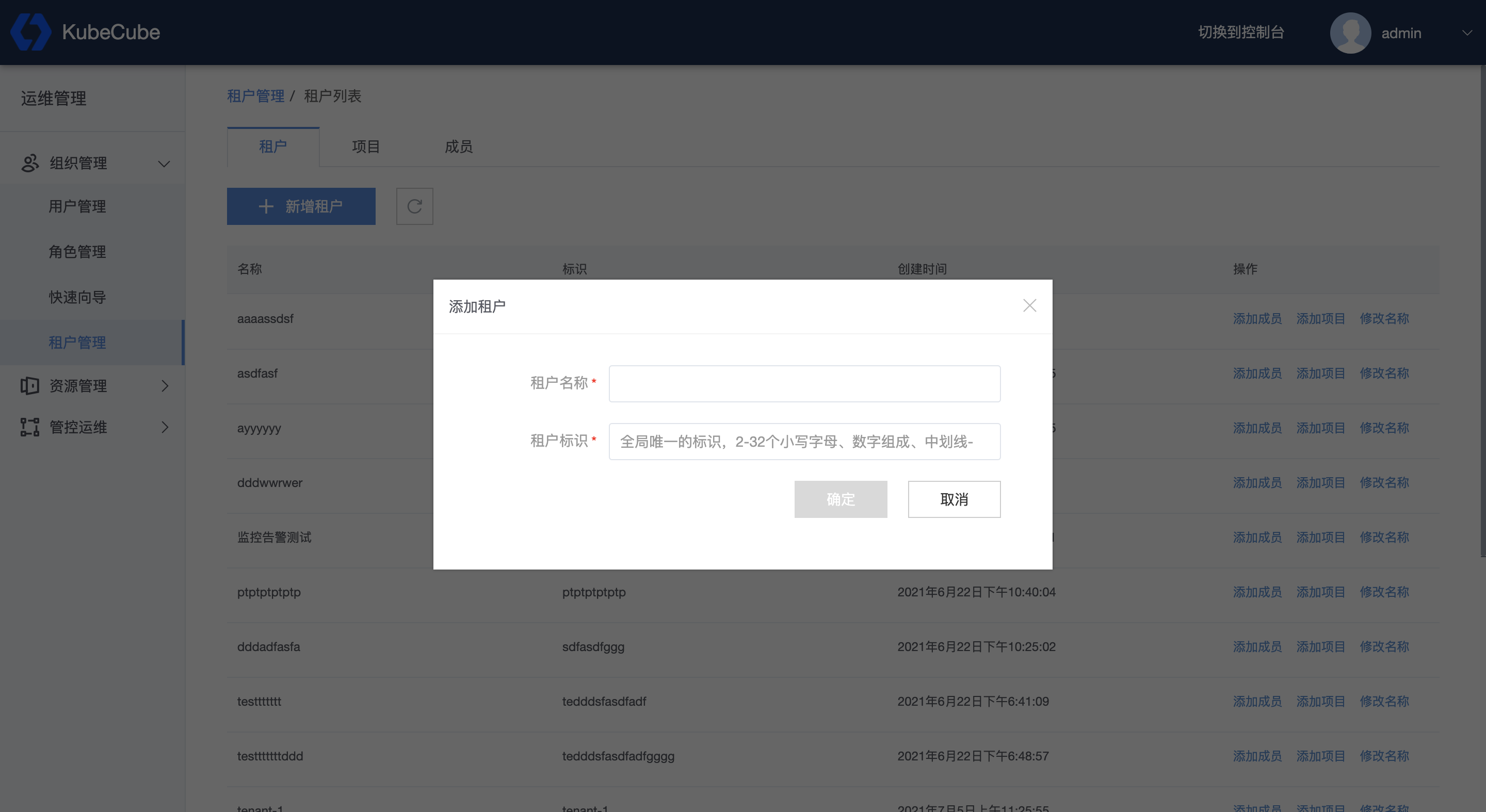

1、创建租户

- 租户名称:平台内展示的租户名。

- 租户标识:

- 长度不得少于2位且不大于32位;

- 只能包含小写字母、数字,以及中划线 ‘-’ ;

- 全局唯一标识,不允许重复,不允许修改。

- 租户管理员:添加用户 admin 到租户中并作为租户管理员。

详细配置说明见 租户管理 。

点击【创建】,如图,即创建了租户:“tenant-1”。

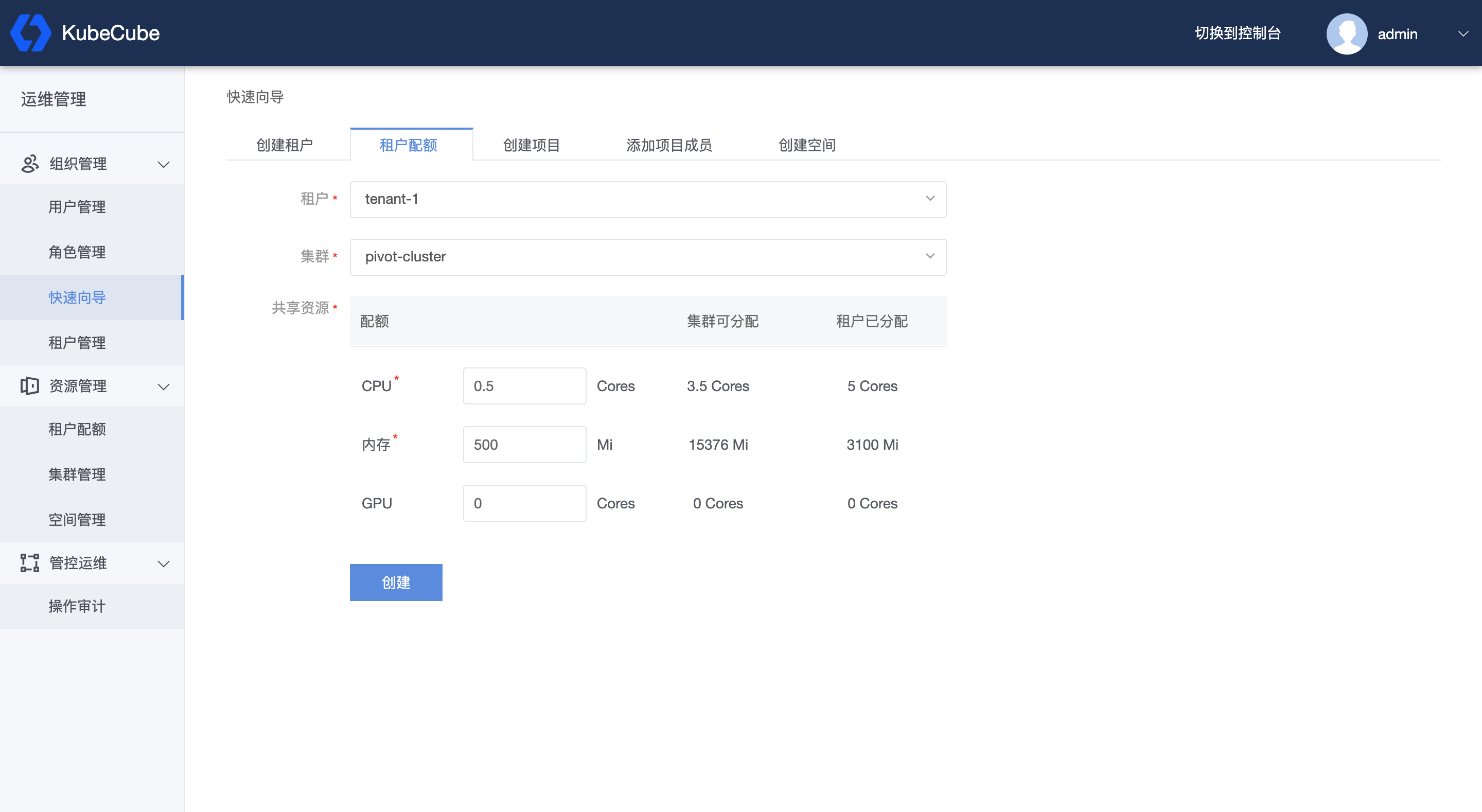

2、租户配额

选择租户,以及集群,填写资源配额:

- 集群可分配:表示该集群剩余可分配资源。

- 租户已分配:表示该租户下所有 namespace 已分配的资源总和。

详细配置说明见 配额管理 。

点击【创建】,即完成该租户的配额设置。

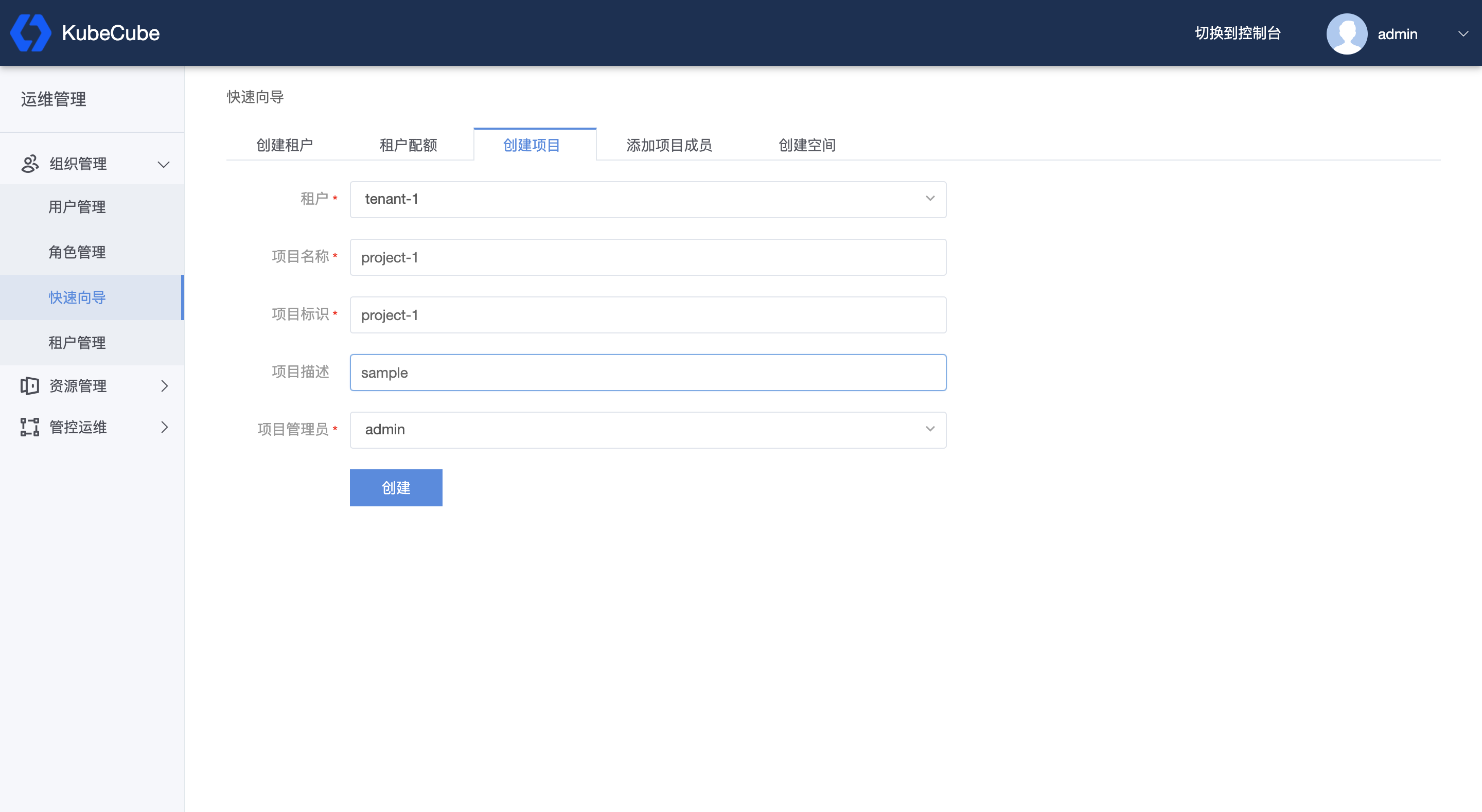

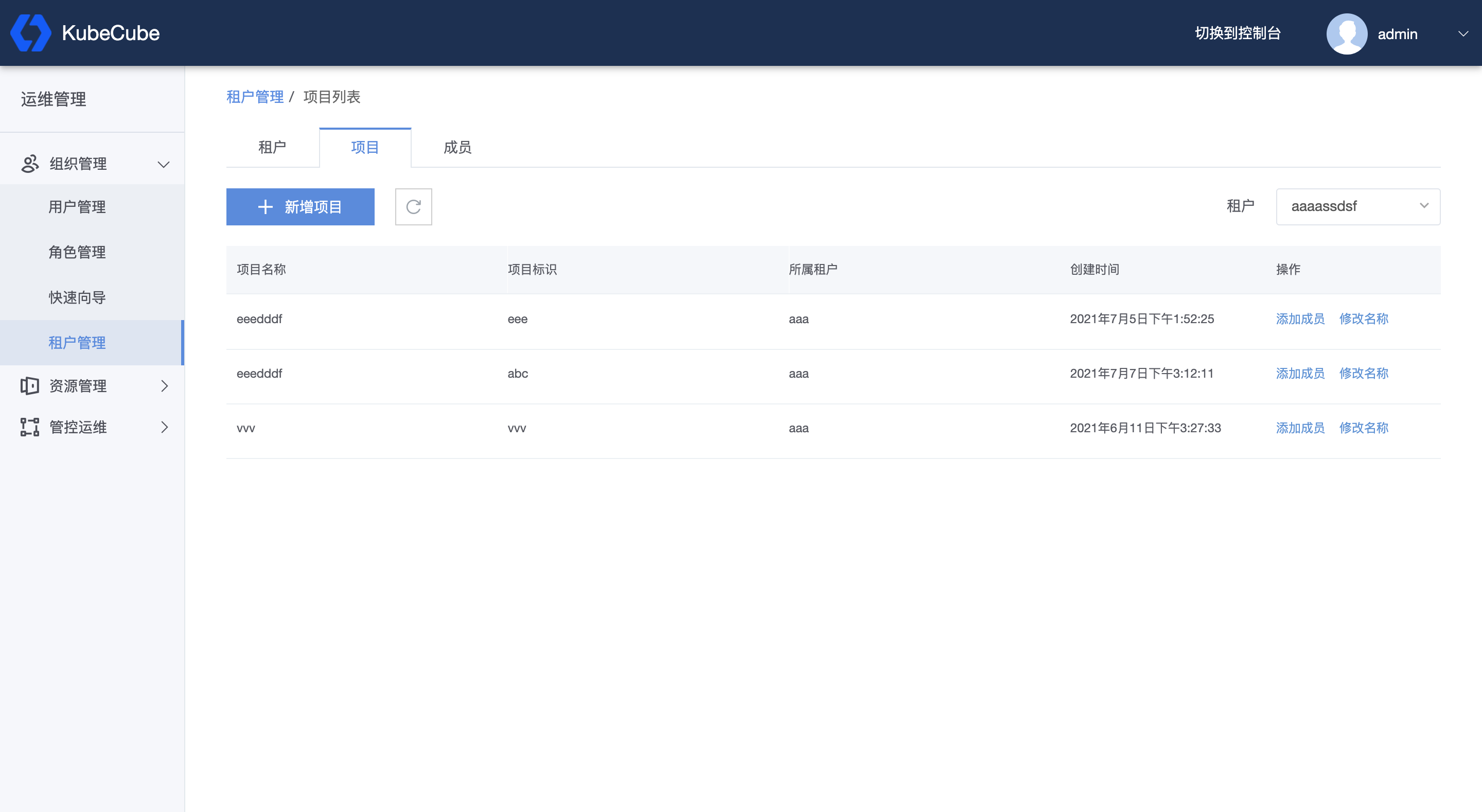

3、创建项目

- 租户:该项目的所属租户;

- 项目名称:项目的展示名称;

- 项目标识:

- 长度不得少于2位且不大于32位;

- 只能包含小写字母、数字,以及中划线 ‘-’ ;

- 全局唯一标识,不允许重复,不允许修改。

- 项目描述:对该项目的描述性语言。

- 项目管理员:选择平台内的用户,作为该项目的管理员。

详细配置说明见 租户管理 -【项目管理】。

点击【创建】,如图,即在租户 “tenant-1” 下创建了项目:“project-1”。

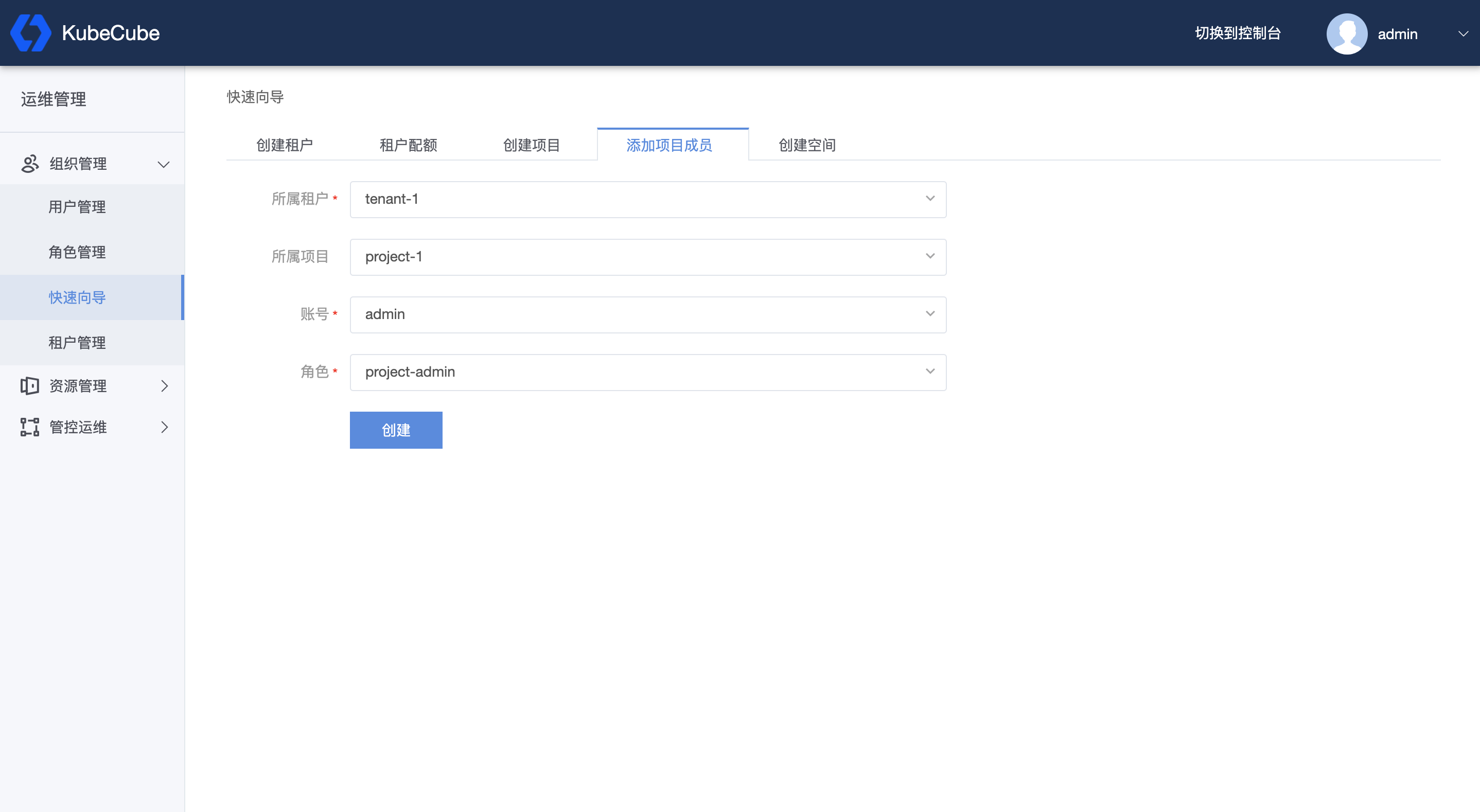

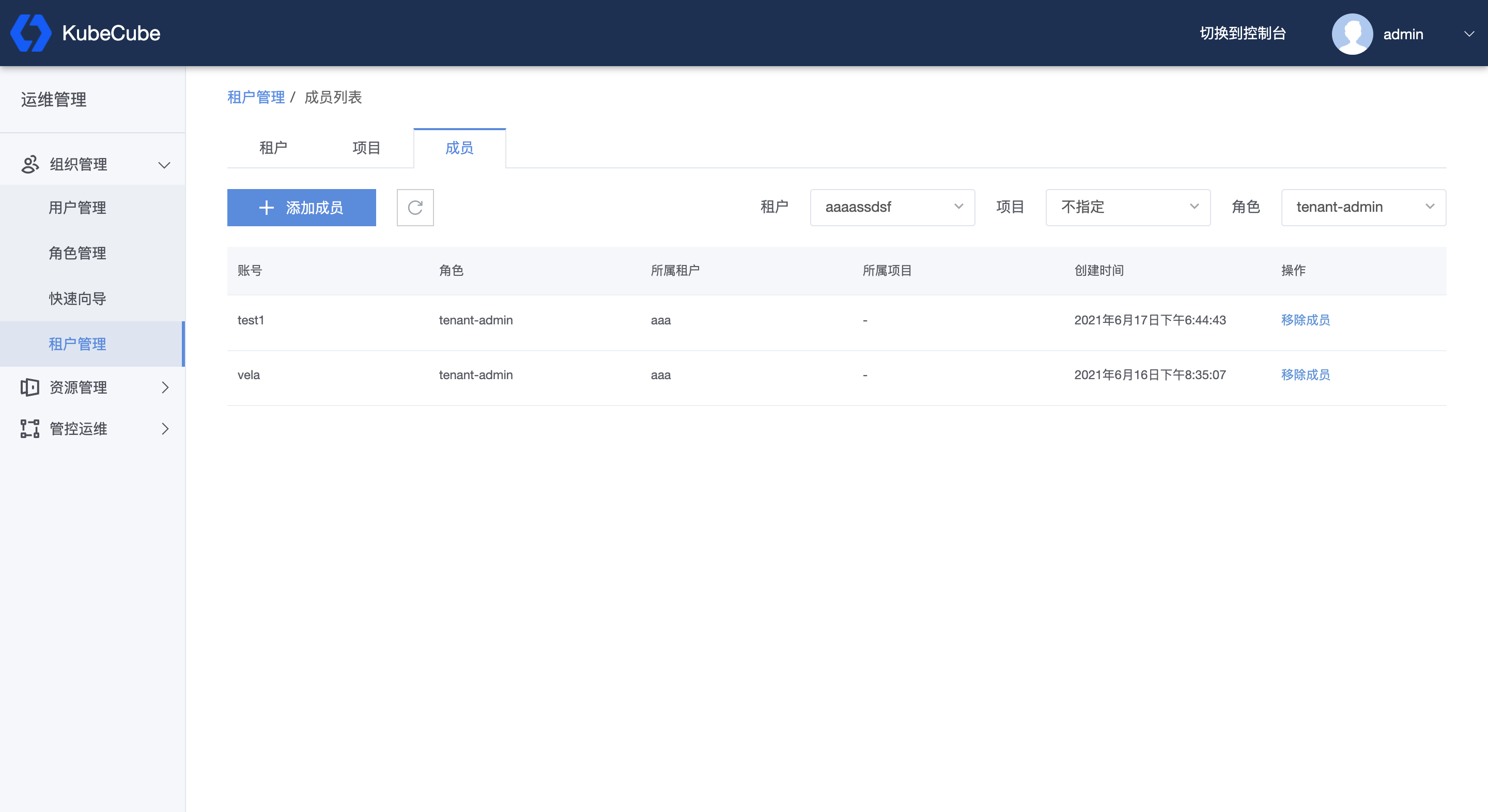

4、添加项目成员

选择租户和项目,将用户添加到租户或项目中,并给其分配角色。

详细配置说明见 租户管理 -【成员管理】。

点击【创建】,如图,即为将用户 admin 添加到项目 “project-1” 中,并作为该项目的项目管理员。

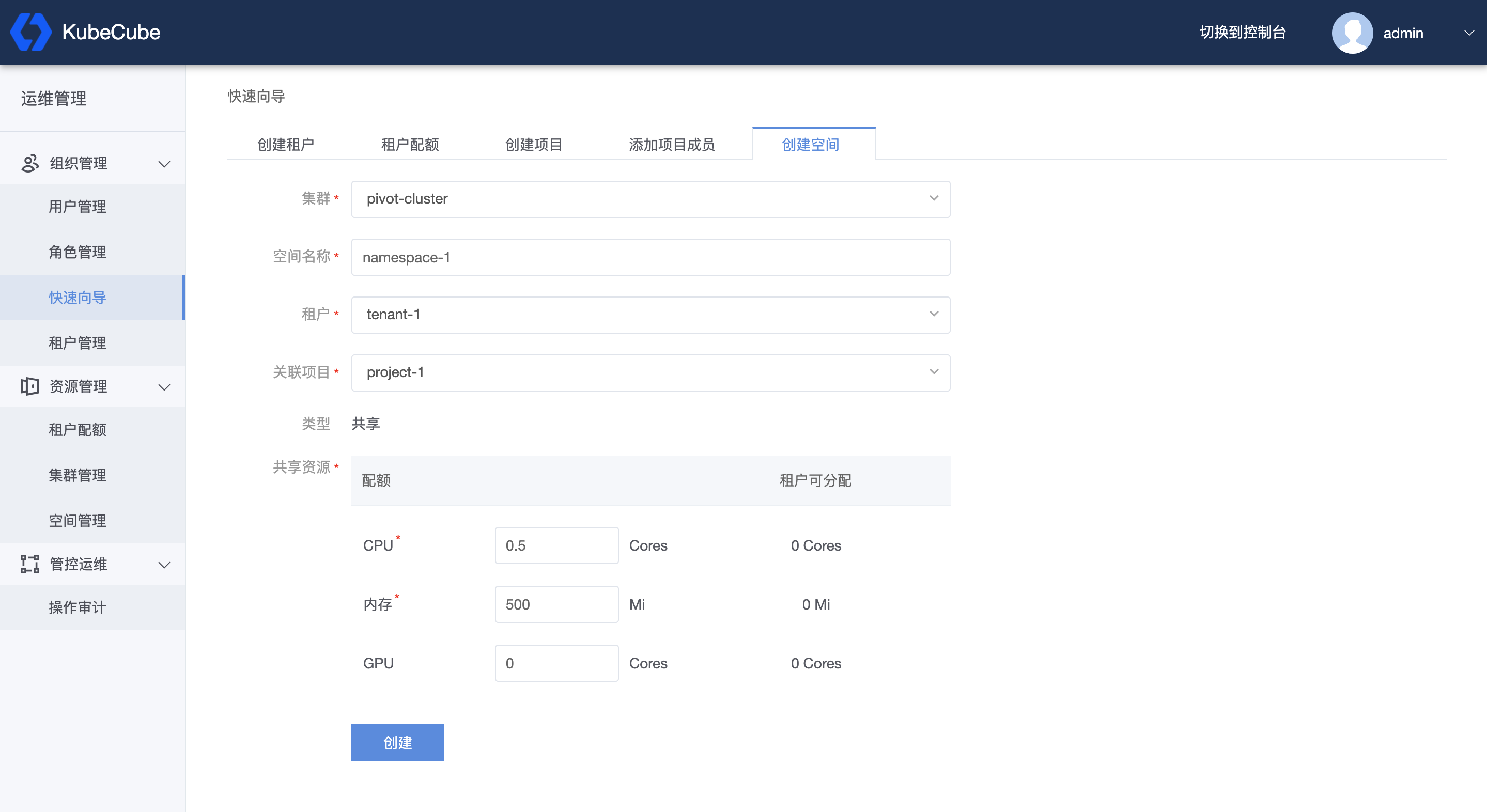

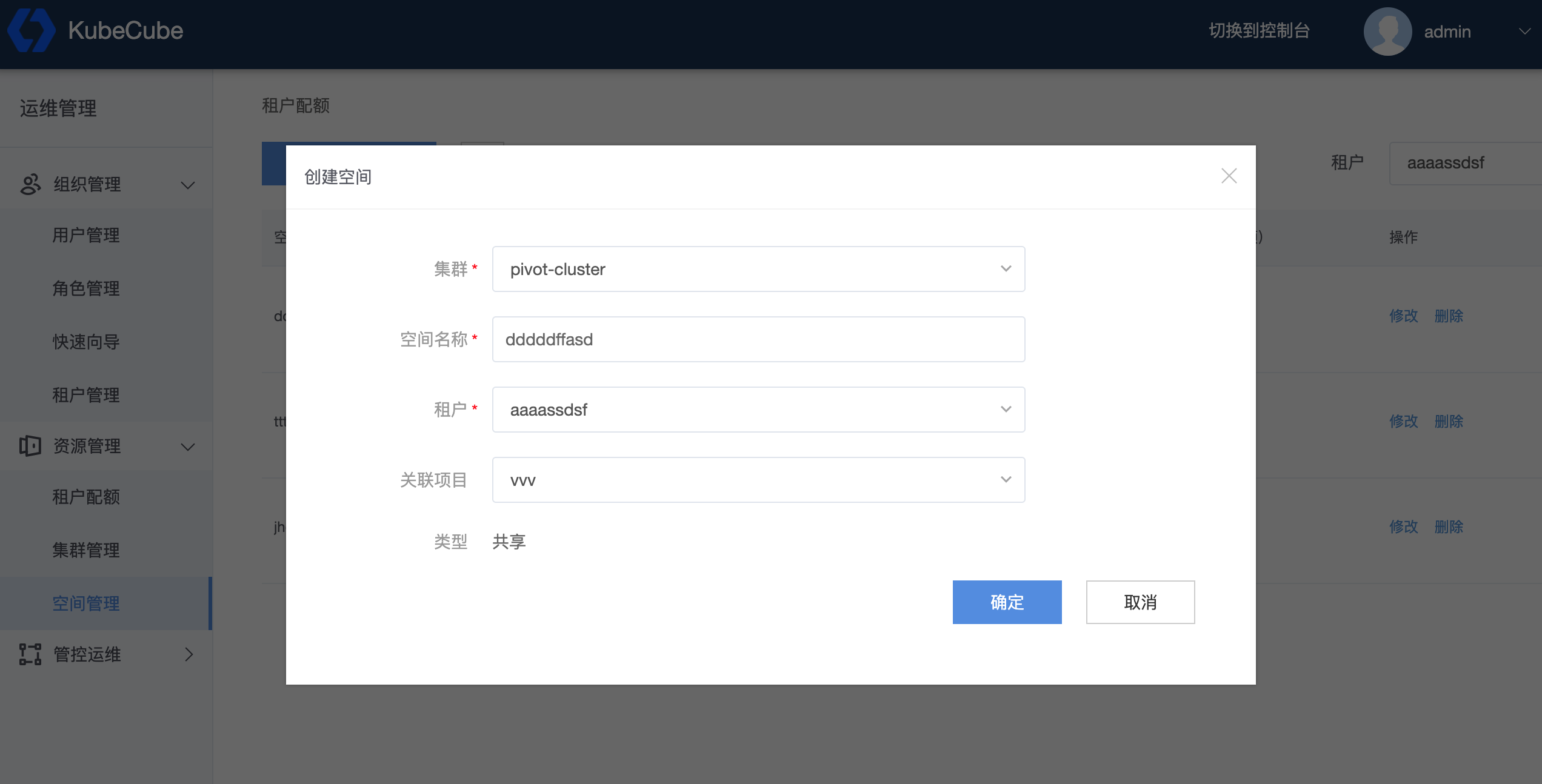

5、创建空间

选择集群、租户和项目,填写空间名称以及资源配额,点击【创建】。

详细配置说明见 配额管理 中的【空间管理】。

点击创建,如图,即为在管控集群的 “project-1” 项目下创建了一个空间 “namespace-1”。

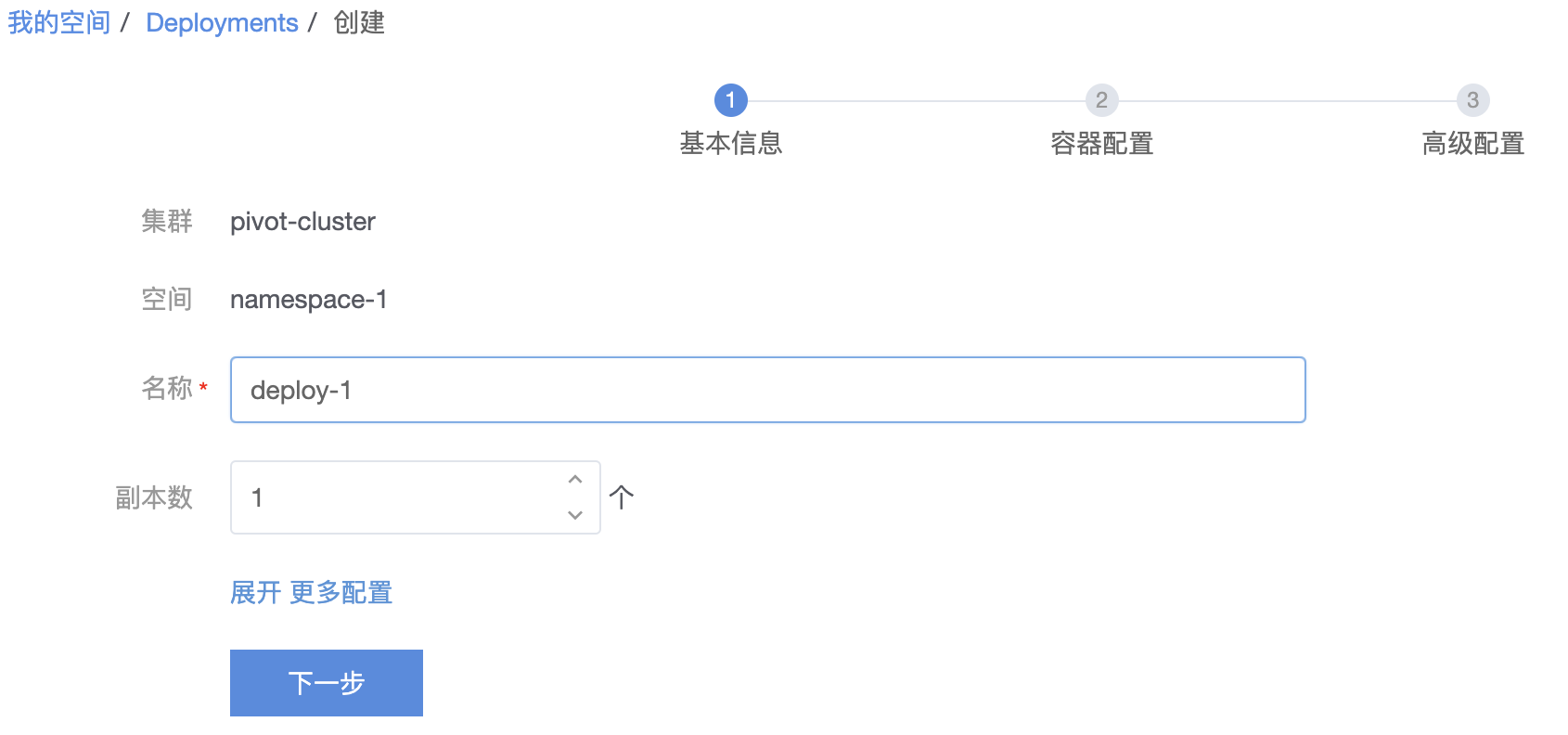

创建工作负载

创建 Deployment

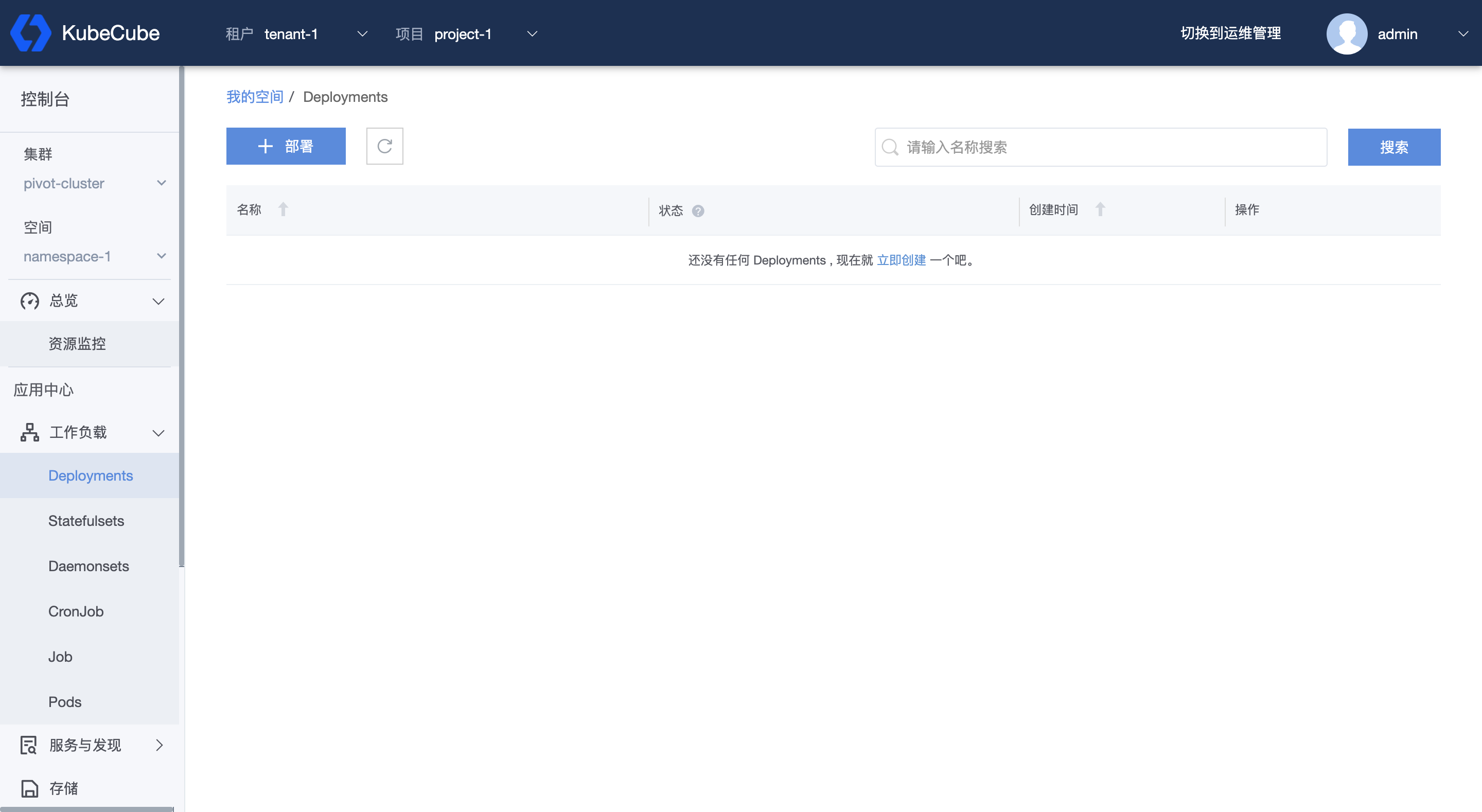

点击右上角【切换到控制台】,进入空间展示的界面。在左上角选择租户和项目,并选择项目下的空间,进入控制台。

展开左侧【工作负载】菜单,点击【Deployments】,进入 Deployment 管理页面。

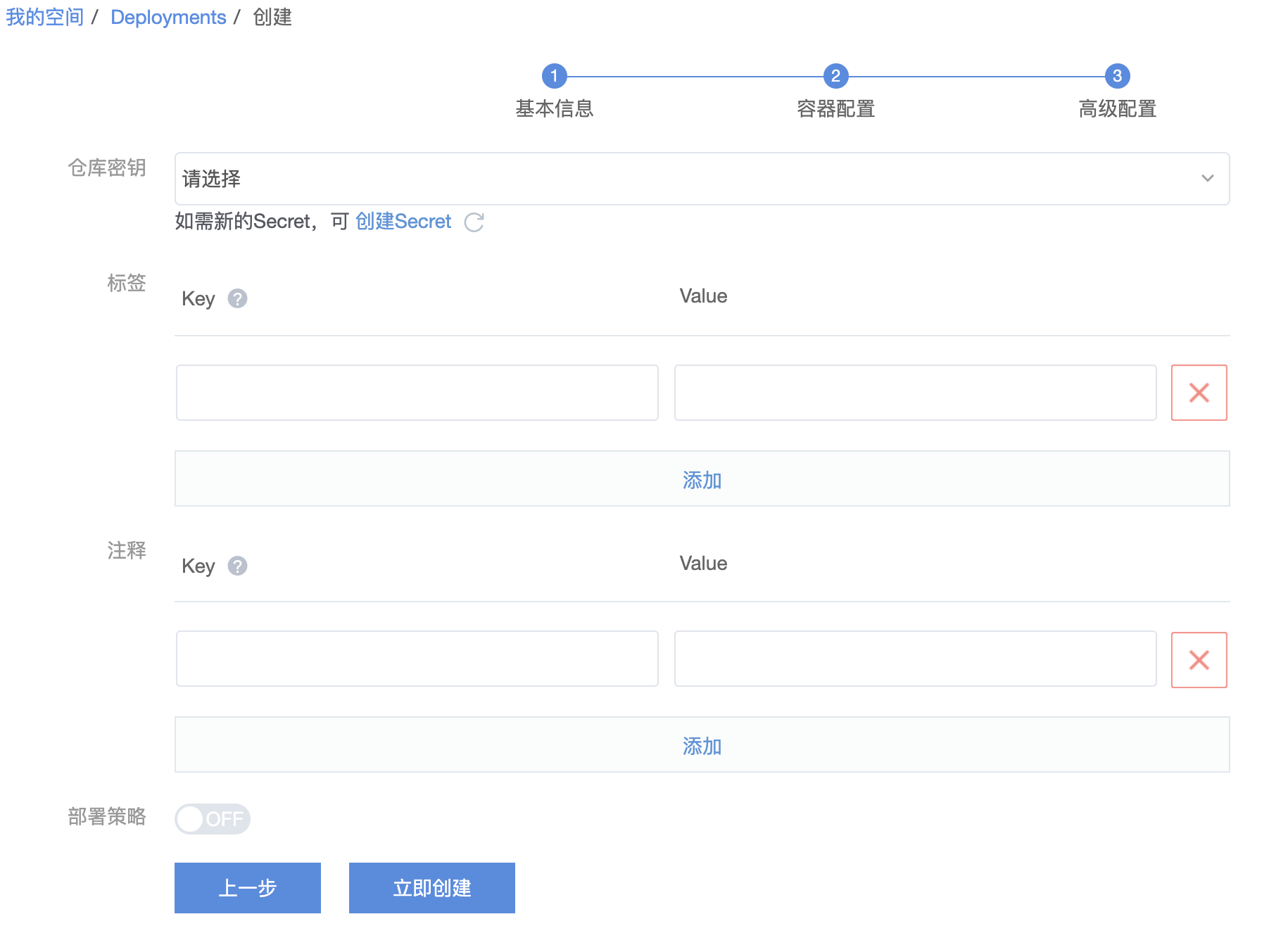

点击【部署】,进入 deployment 的具体设置,如下图所示。

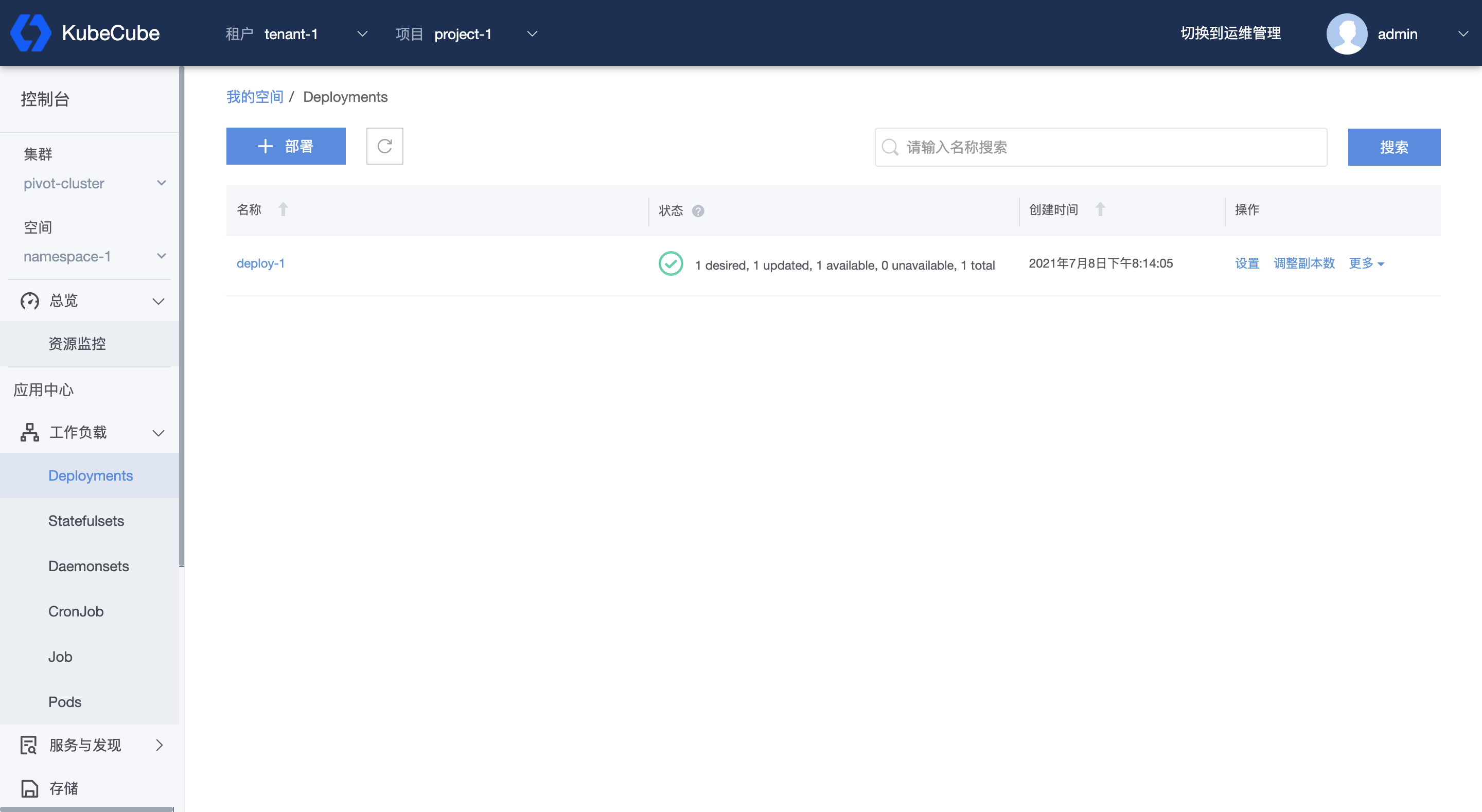

上图展示的示例为,创建一个副本数为1的 Deployment:“deploy-1”, 容器中的镜像为:hub.c.163.com/kubecube/demo:v0。

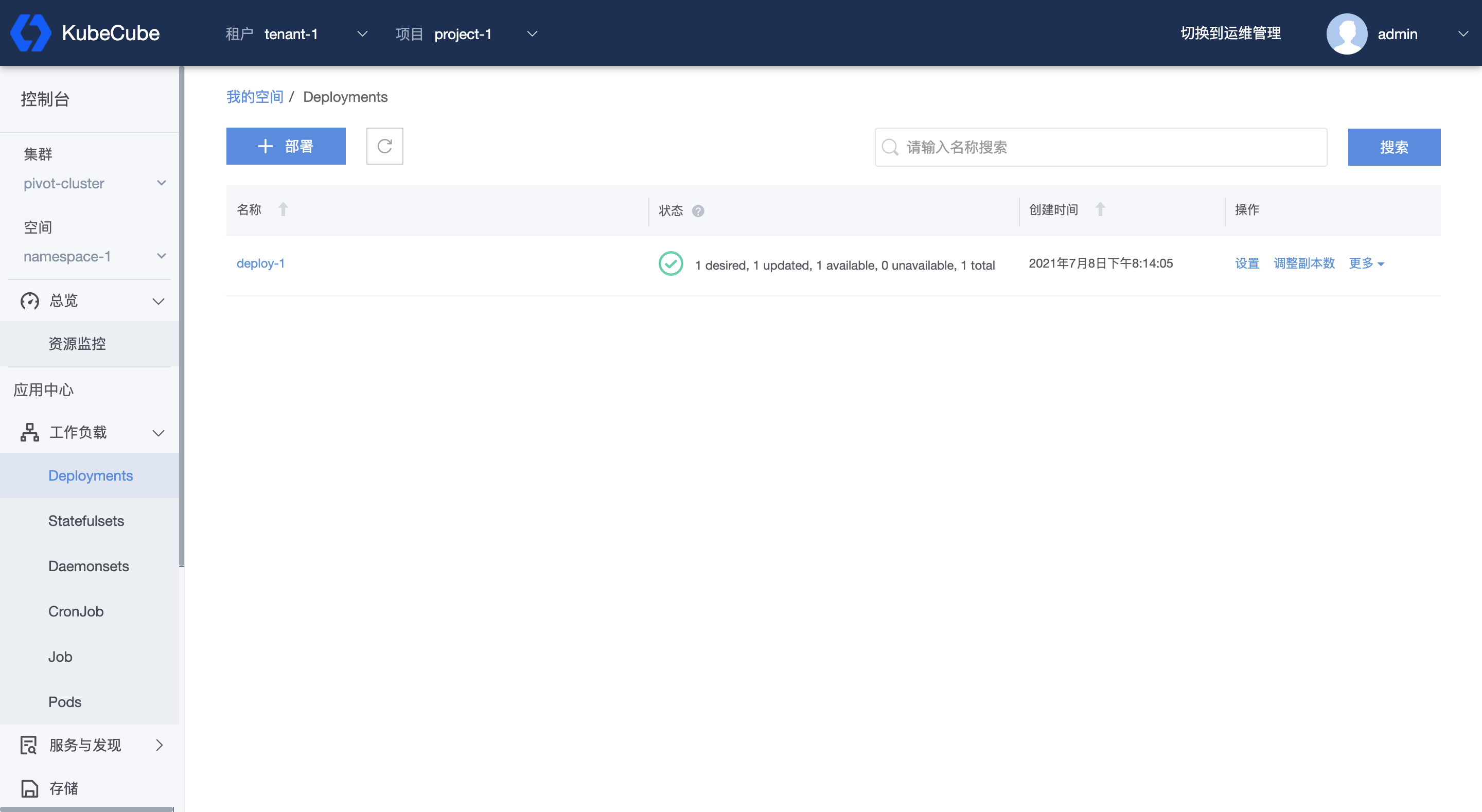

创建成功后结果如下:

详细配置说明见 Deployment管理 。

创建 Service

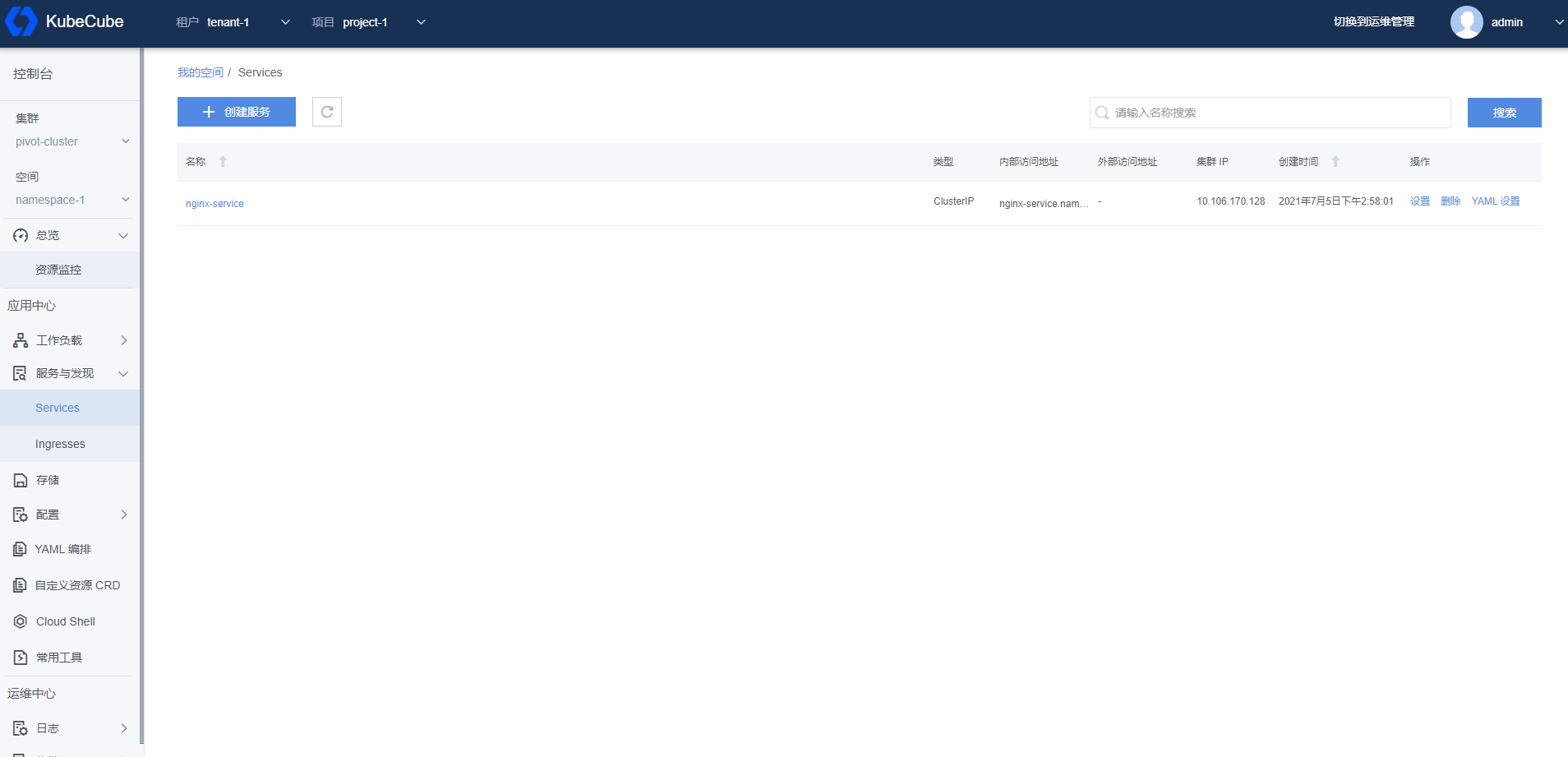

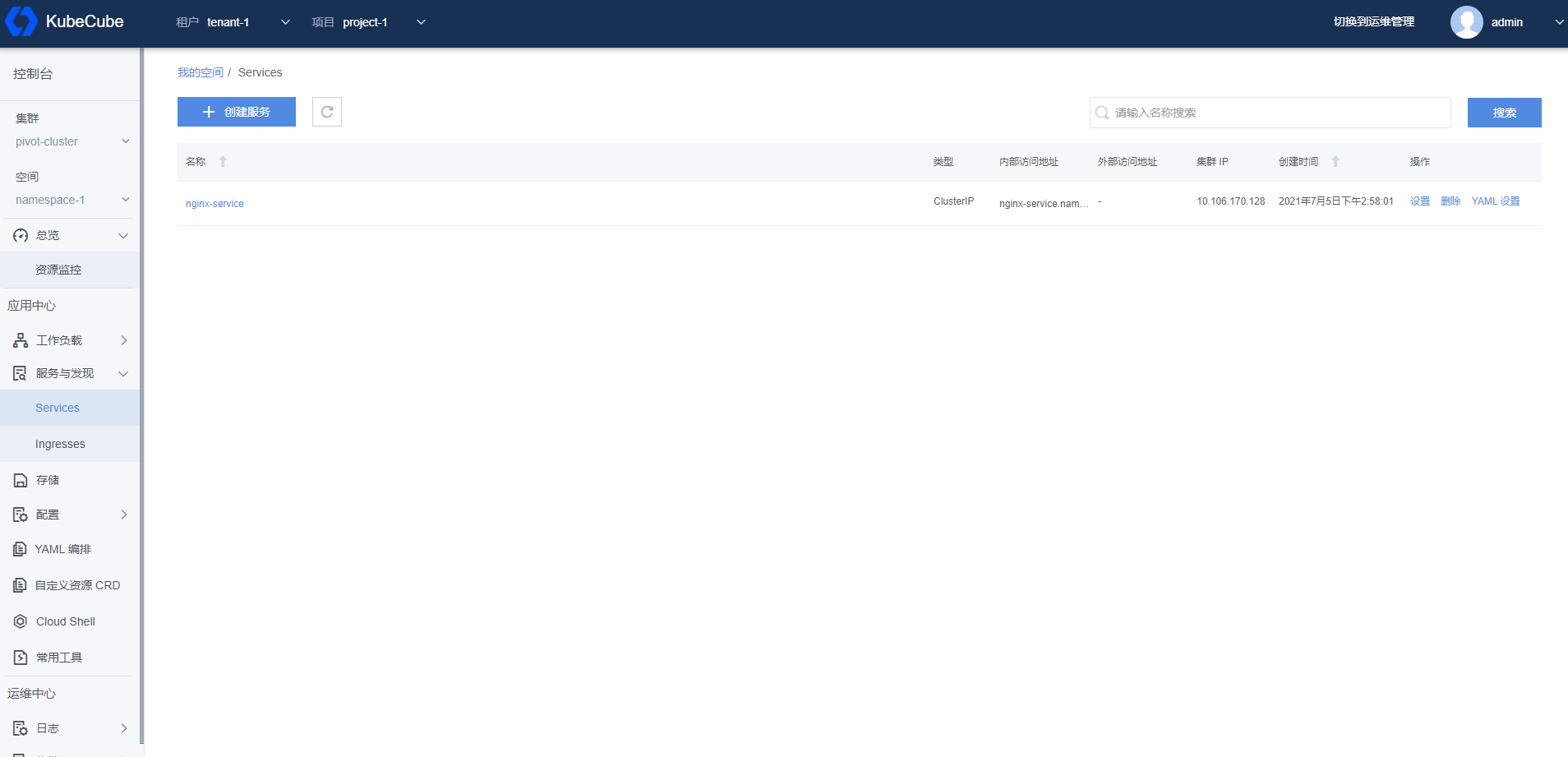

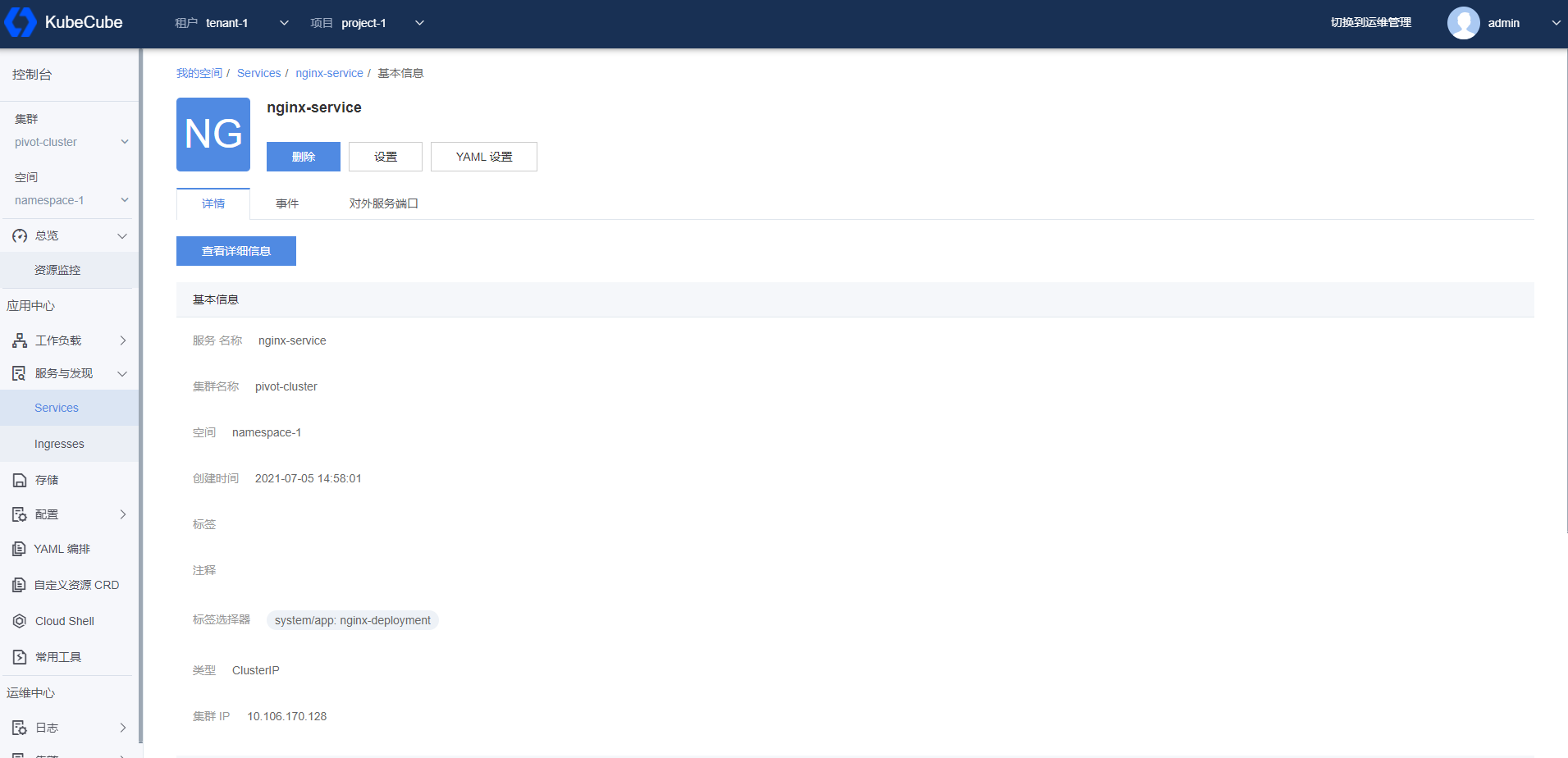

展开左侧【服务与发现】菜单,点击【Services】,进入 Service 管理页面。

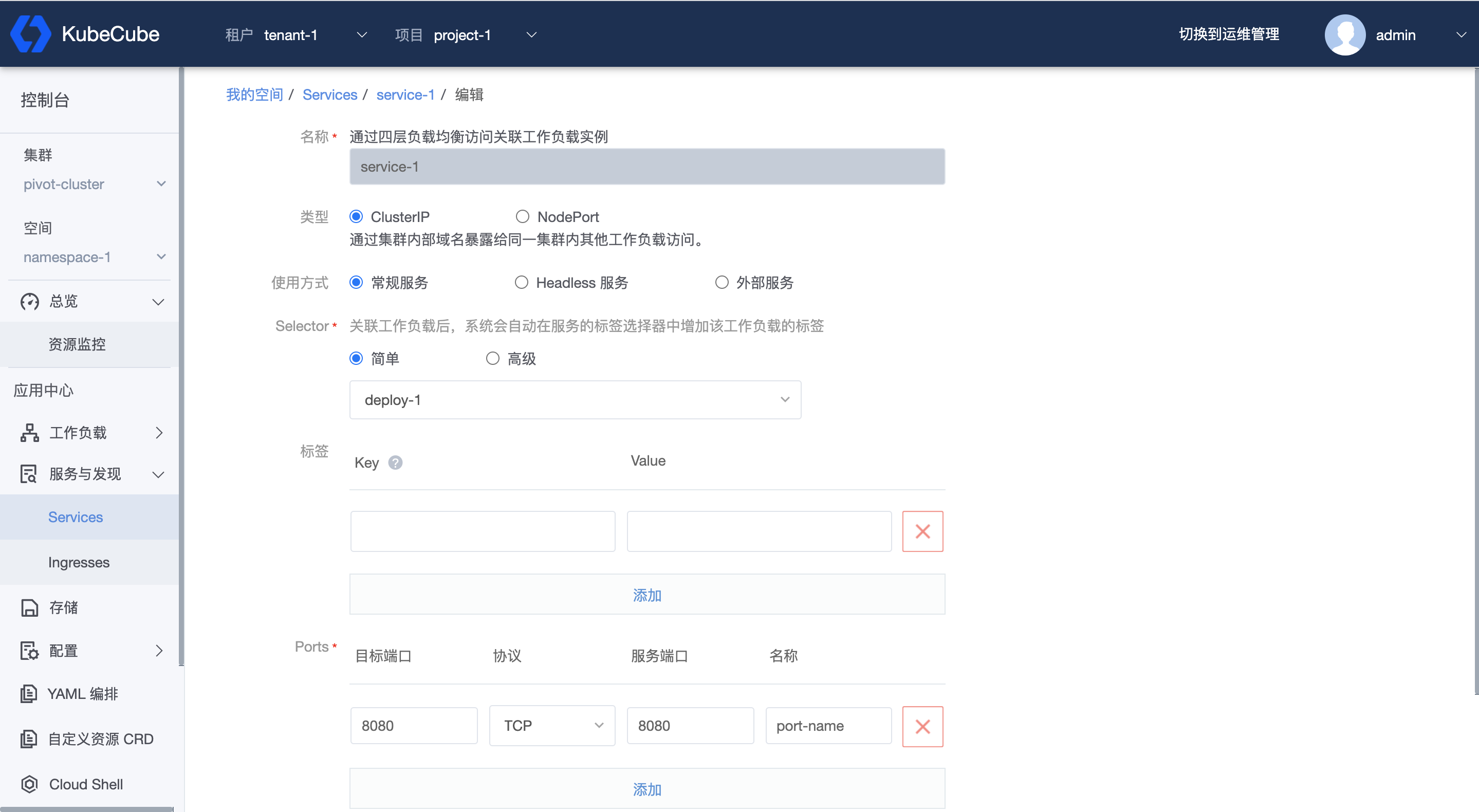

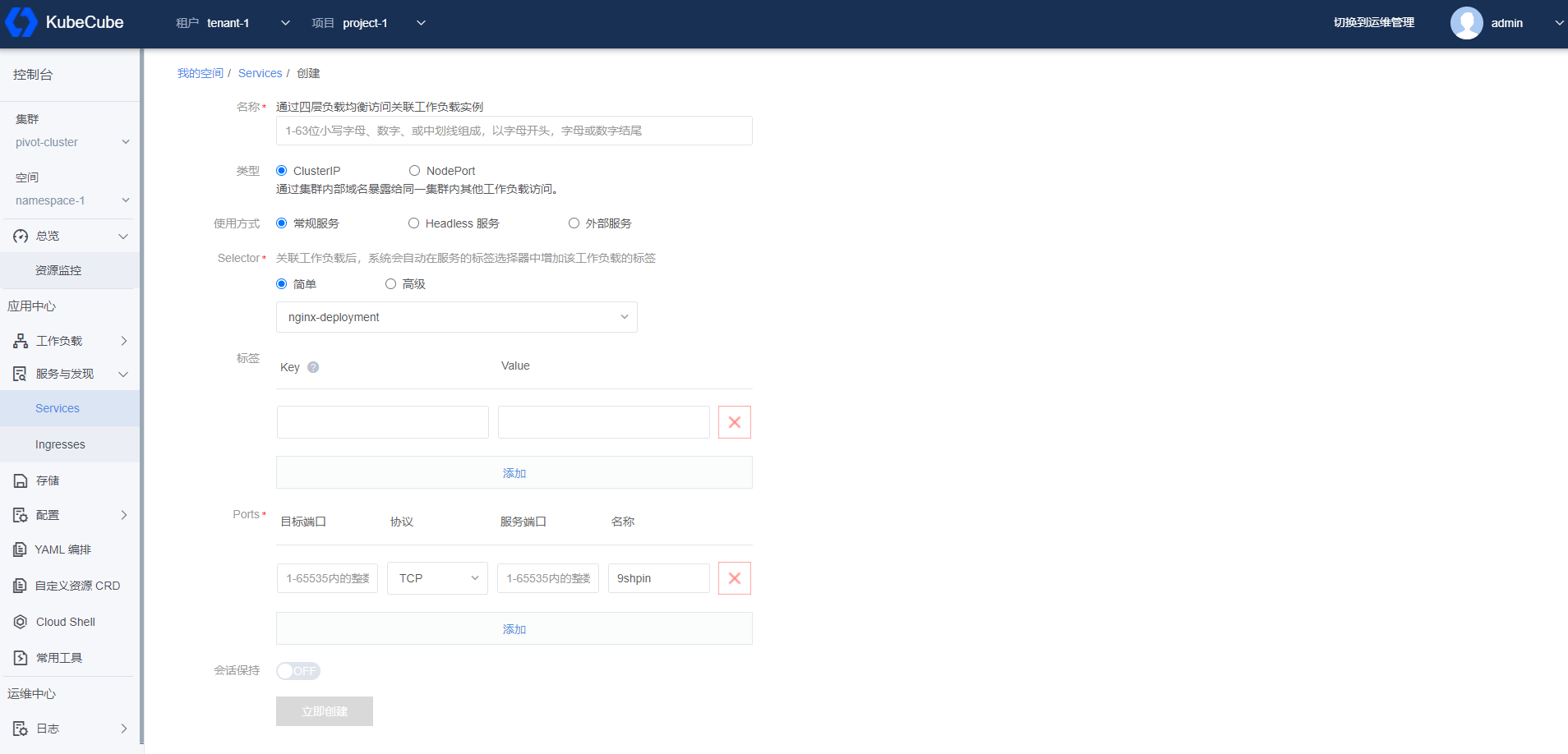

点击【创建服务】,选择已创建的 Deployment,如下图创建 Service。点击【立即创建】。

详细配置说明见 Service管理 。

创建Ingress

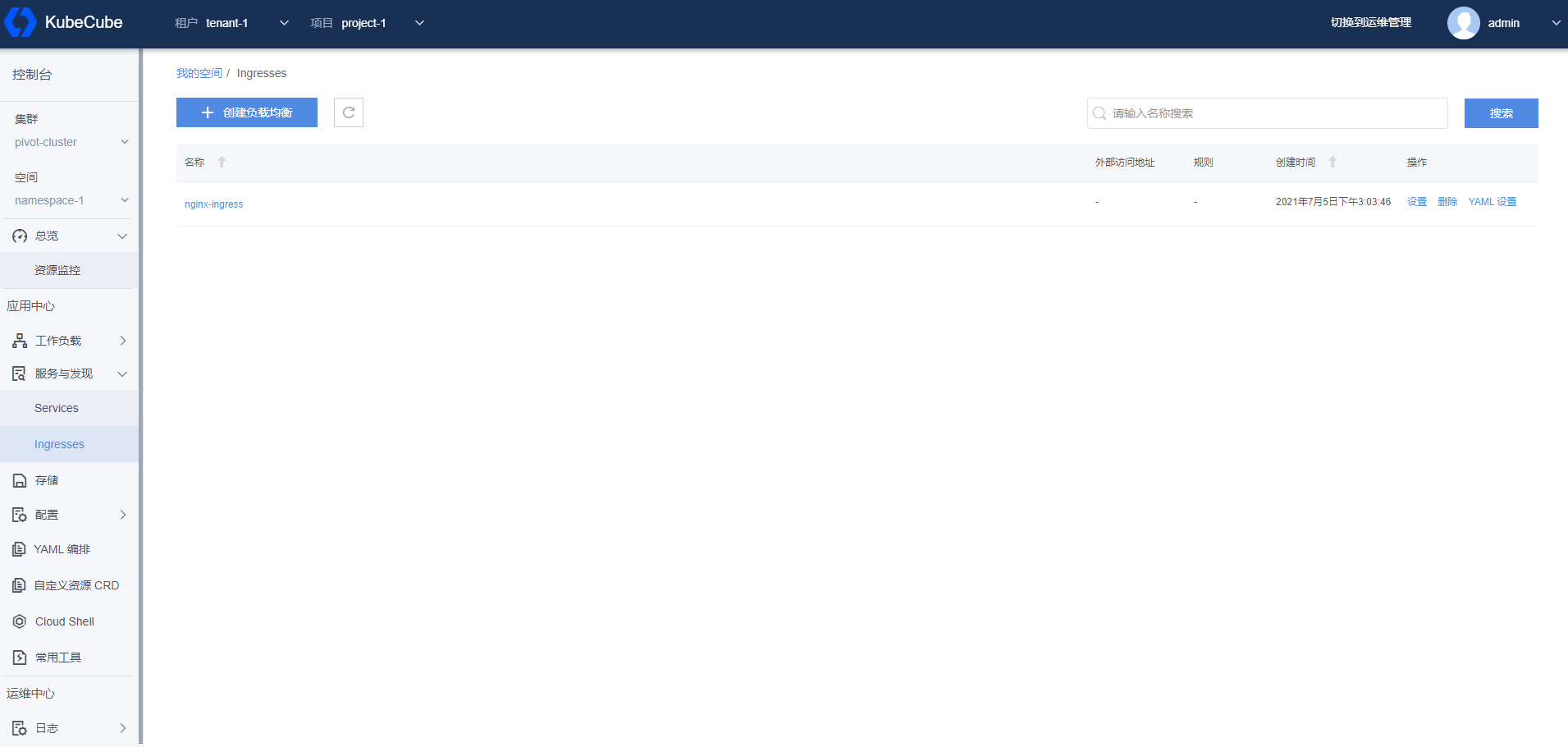

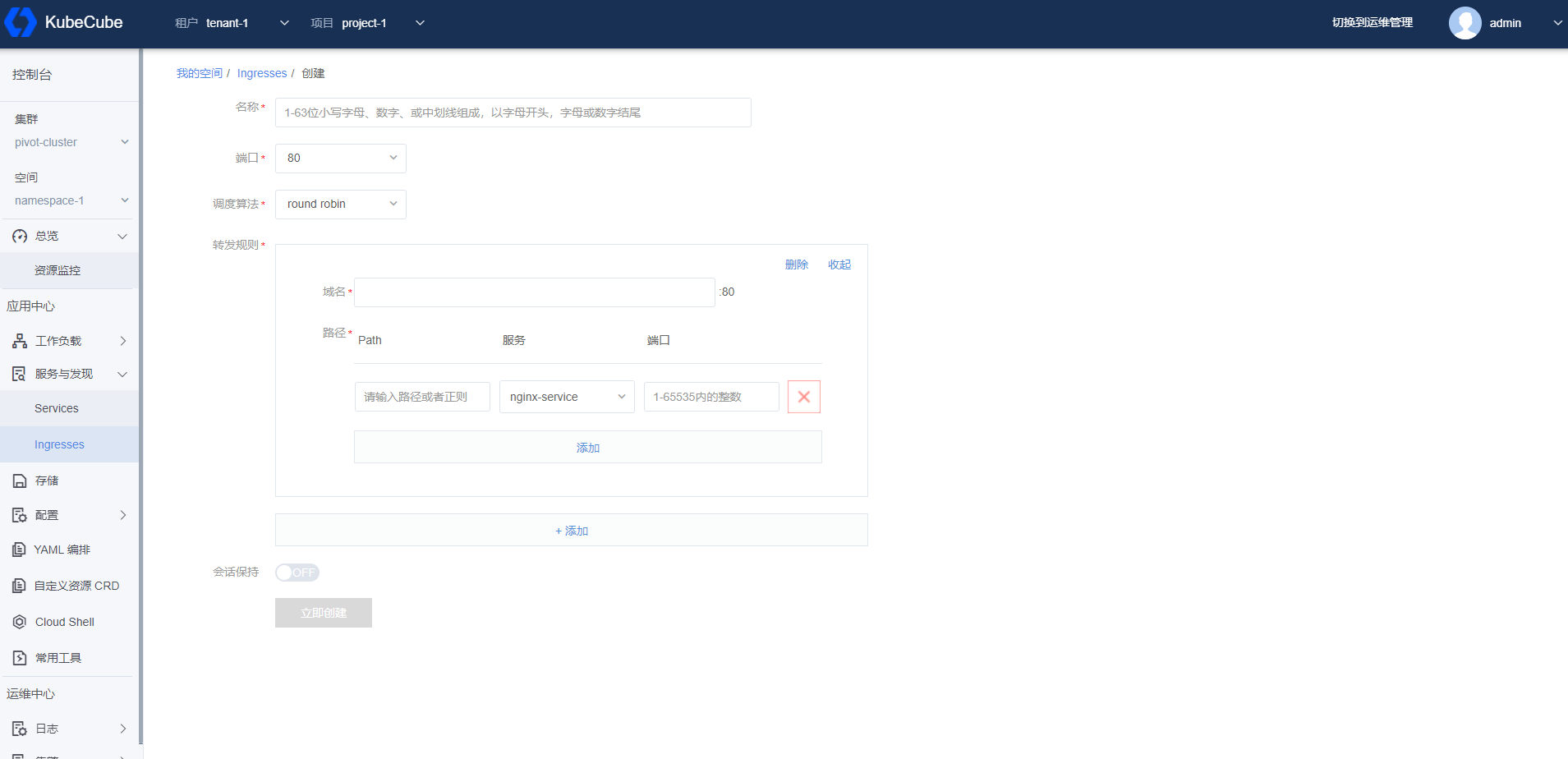

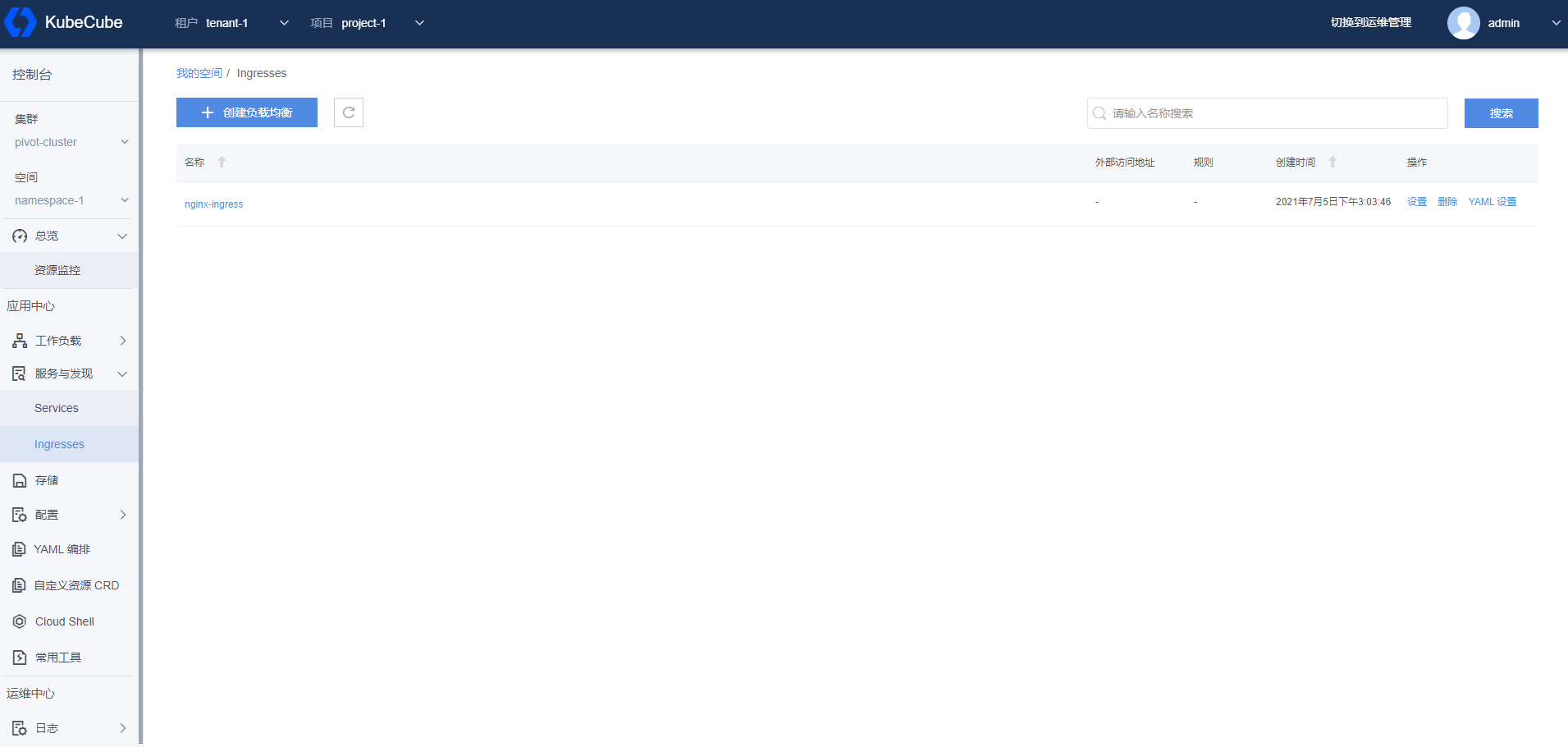

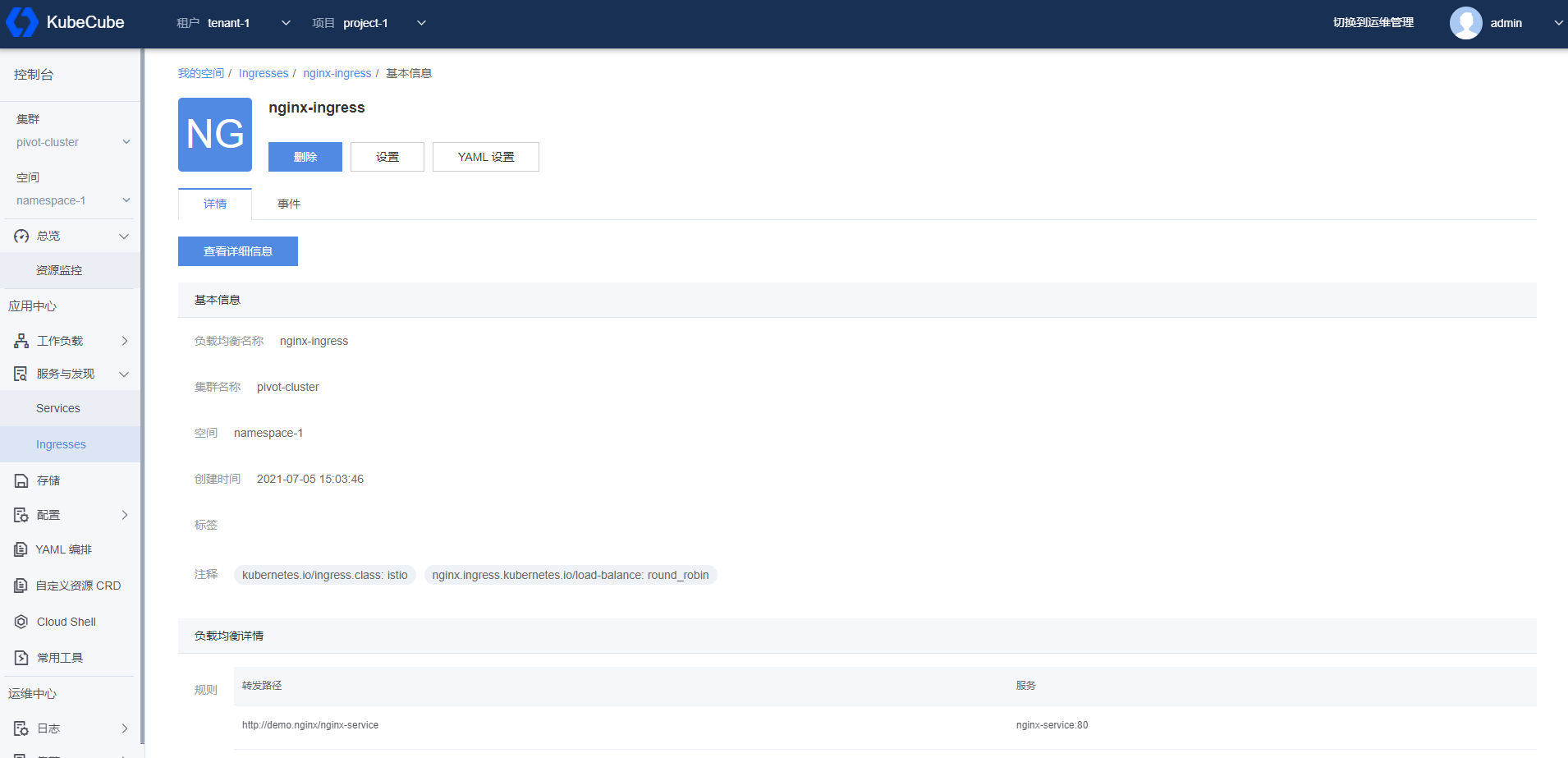

展开左侧【服务与发现】菜单,点击【Ingresses】,进入 Ingress 管理页面。

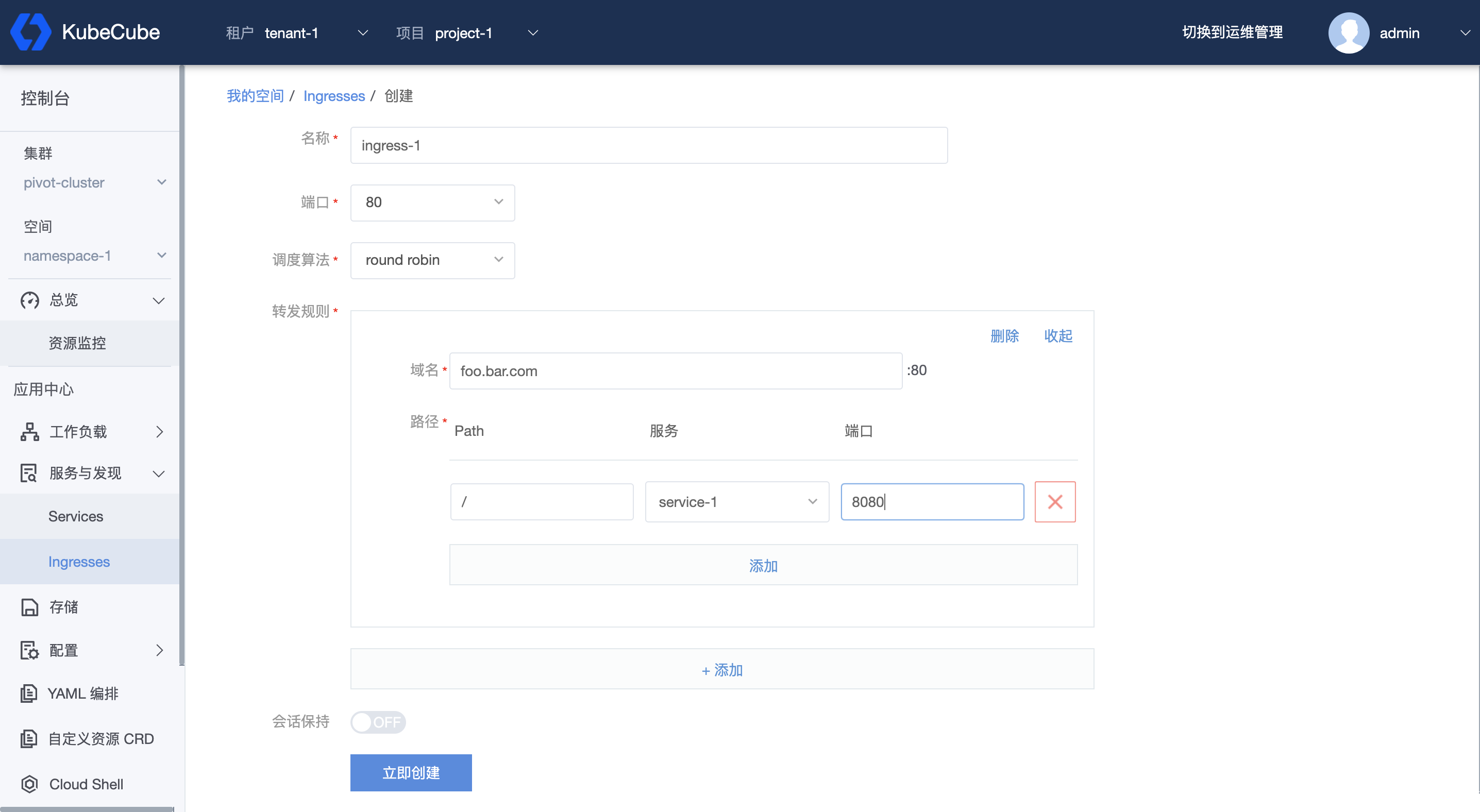

点击【创建负载均衡】,选择已创建的 Service,如下图创建 Ingress。点击【立即创建】。

详细配置说明见 Ingress管理 。

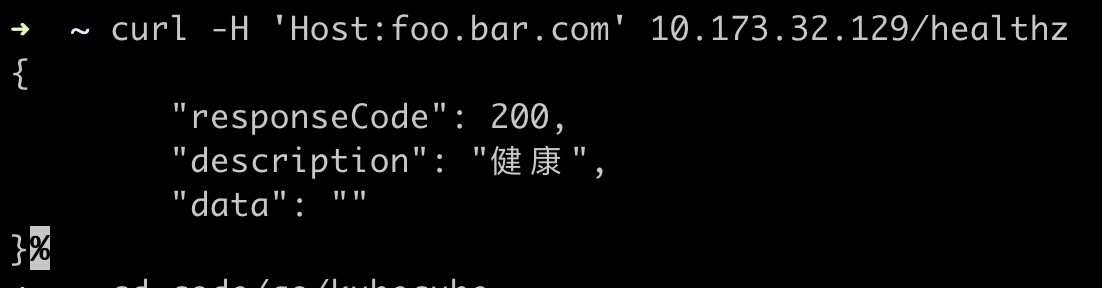

在本地访问镜像中接口:

curl -H 'Host:foo.bar.com' {部署ingress节点IP}/healthz, 则会返回以下结果,说明以上内容部署成功:

3 - 部署指南

3.1 - 部署环境要求

在进行 All In One 或者多节点部署之前,请按照以下内容确认环境要求

系统版本及硬件要求

| 操作系统 | 最低要求 |

|---|---|

| Ubuntu 16.04, 18.04 | CPU:4 核,内存:8 G,磁盘空间:20 G |

| Debian Buster, Stretch | CPU:4 核,内存:8 G,磁盘空间:20 G |

| CentOS 7.x | CPU:4 核,内存:8 G,磁盘空间:20 G |

| Kylin v10 | CPU:4 核,内存:8 G,磁盘空间:20 G |

| OS ARCH | 硬件要求 |

|---|---|

| AMD 64 | Intel 系列,AMD 系列 |

| ARM 64 | Phytium 2000(国产化arm64芯片理论上都支持,但未经过充分测试) |

以上系统配置要求适用于 KubeCube 默认最小化 All In One 模式安装,如需启动更多可插拔组件和拓展功能,建议机器配置为 8 核 CPU 和 16 G 内存

依赖说明

| KubeCube | Kubernetes | Docker | Containerd |

|---|---|---|---|

| v1.0 ~ v1.4 | v1.18 ~ v1.23 | 19.3.12+ | 1.5.x |

容器运行时

KubeCube 支持的 cri 跟随 Kubernetes 标准

KubeCube 部署脚本支持的 cri 如下:

| 支持的容器运行时 | 版本 |

|---|---|

| Docker | 19.3.12+ |

| Containerd | 1.5.x |

节点上若无容器运行时,部署脚本将自动安装 containerd 1.5.5 作为容器运行时

网络插件

KubeCube 支持的 cni 跟随 Kubernetes 标准

KubeCube 部署脚本的 cni 目前支持 calico

Kubernetes 版本

KubeCube 支持的 k8s 版本为 v1.18 ~ v1.26 KubeCube 部署脚本支持的 k8s 版本为 v1.18.20、v1.19.13、v1.20.9、v1.21.2、v1.22.2、v1.23.5、v1.24.7、v1.25.3、v1.26.0

关于 K8s 集群安装

KubeCube 的 All In One 安装脚本提供单节点的 K8s 集群安装。如果需要自定义安装 K8s 集群,可以使用 kubeadm、kubez-ansible 等开源工具,之后 kubez-ansible 中也会集成 KubeCube。

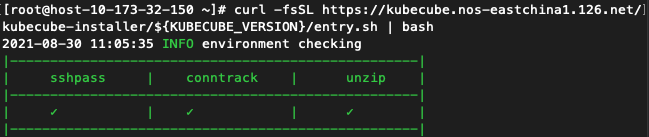

前置准备

在使用 All In One 部署脚本开始 KubeCube 的安装时,脚本会检测环境,并提示需要安装缺失的依赖

监控组件说明

KubeCube 会默认安装 Prometheus 等监控组件,如果选择在已有k8s集群中部署 KubeCube,并且集群中已安装 Mertics Server,安装 KubeCube 后 Prometheus 会和 Mertics Server 产生冲突,导致监控功能不可用。需要在安装 KubeCube 后执行以下步骤:

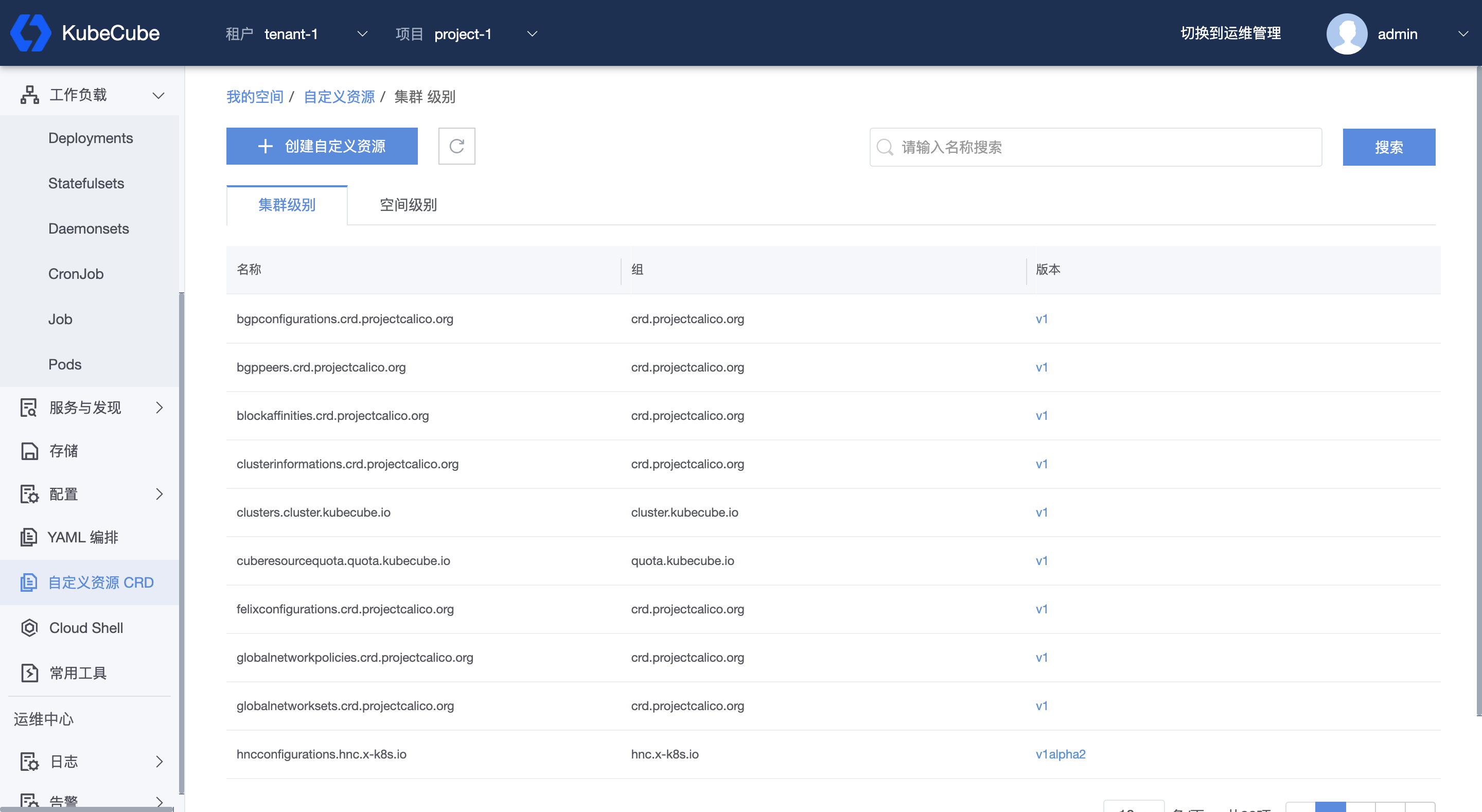

点击页面右上角【切换到控制台】,点击任意空间,进入到控制台页面;

在左侧菜单栏点击【自定义资源CRD】,进入到集群级别 CRD 列表,可以点击右上方输入 “hotplug” 进行搜索,找到 “hotplugs.hotplug.kubecube.io” CRD,点击【v1】版本进入 CRD 详情页;

选择 common 实例,点击【设置YAML】,找到 spec.component. name=kubecube-monitoring,添加环境变量 prometheusAdapter.enabled=false,如:

- env: |

grafana:

enabled: false

prometheus:

prometheusSpec:

externalLabels:

cluster: "{{.cluster}}"

remoteWrite:

- url: http://10.173.32.129:31291/api/v1/receive

prometheusAdapter:

enabled: false

name: kubecube-monitoring

namespace: kubecube-monitoring

pkgName: kubecube-monitoring-15.4.10.tgz

status: enabled

3.2 - All In One 部署与卸载

3.2.1 - All In One 最小化部署

对于想要快速开始、快速体验的用户来说,All In One 是最佳的安装方式。All In One 部署脚本将会在执行该脚本的节点上,安装一个单节点的 K8s 集群,并在该 K8s 集群上部署 KubeCube。

v1.8.x

在 Linux 上部署 KubeCube

开始安装

在 Linux 机器上执行部署脚本

export KUBECUBE_VERSION=v1.8

curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/release/v1.3/entry.sh | bash

等待部署完成

KubeCube 部署完成后,请根据提示信息登陆 console 管理页面

使用 admin 账户登陆 console

⚠️请在登陆后修改 admin 用户的密码

v1.4.x

在 Linux 上部署 KubeCube

开始安装

在 Linux 机器上执行部署脚本

KUBECUBE_VERSION=v1.4

curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

等待部署完成

KubeCube 部署完成后,请根据提示信息登陆 console 管理页面

使用 admin 账户登陆 console

⚠️请在登陆后修改 admin 用户的密码

v1.2.x

在 Linux 上部署 KubeCube

开始安装

在 Linux 机器上执行部署脚本

KUBECUBE_VERSION=v1.2

curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

等待部署完成

KubeCube 部署完成后,请根据提示信息登陆 console 管理页面

使用 admin 账户登陆 console

⚠️请在登陆后修改 admin 用户的密码

v1.1.x

在 Linux 上部署 KubeCube

开始安装

在 Linux 机器上执行部署脚本

KUBECUBE_VERSION=v1.1

curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

等待部署完成

KubeCube 部署完成后,请根据提示信息登陆 console 管理页面

使用 admin 账户登陆 console

⚠️请在登陆后修改 admin 用户的密码

v1.0.x

在 Linux 上部署 KubeCube

开始安装

在 Linux 机器上执行部署脚本

KUBECUBE_VERSION=v1.0

curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

等待部署完成

KubeCube 部署完成后,请根据提示信息登陆 console 管理页面

使用 admin 账户登陆 console

⚠️请在登陆后修改 admin 用户的密码

3.2.2 - KubeCube 卸载

KubeCube 提供一键卸载脚本

⚠️ 注意,卸载脚本仅用于使用 All In One 部署脚本安装的环境,不应该用于任何正式环境

下载卸载脚本

curl -o cleanup.sh https://kubecube.nos-eastchina1.126.net/hack/cleanup.sh

一键卸载

一键卸载按顺序卸载 kubecube, kubernetes 和 docker

/bin/bash cleanup.sh all

指定卸载

卸载脚本可以指定卸载对象,但需注意卸载依赖

卸载 KubeCube

删除 kubecube chart release,并清理 kubecube 在本机上的相关文件

/bin/bash cleanup.sh kubecube

卸载 Kubernetes

卸载 kubernetes 集群,并清理 kubernetes 在本机上的相关文件

/bin/bash cleanup.sh k8s

卸载 Docker

卸载 docker,并清理 docker 在本机上的相关文件

⚠️注意:需在卸载 kubernetes 后才能卸载 docker,不然会造成 kubernetes 集群异常

/bin/bash cleanup.sh docker

3.3 - 在已有K8s上安装KubeCube

3.3.1 - 通过helm安装KubeCube

通过 helm 的方式在管控集群中部署 KubeCube

v1.8.x

要求

- 已有 K8s 集群环境

- helm v3 客户端

下载 KubeCube helm chart 包

KUBECUBE_VERSION=v1.8

curl -s https://kubecube.nos-eastchina1.126.net/kubecube-chart/${KUBECUBE_VERSION}/kubecube-chart.tar.gz | tar -xz

通过 helm 在管控集群上安装 KubeCube

创建 pivot-value.yaml 文件并填写必要的 value 值

# pivot-value.yaml

global:

# 管控集群的 Node IP,用来暴露 KubeCube 的 NodePort service

nodeIP: x.x.x.x

dependencesEnable:

ingressController: "false" # 如果集群中没有部署 ingress controller,请将此设置为 "true"

localPathStorage: "false" # 如果集群中没有部署 local path storage,请将此设置为 "true"

metricServer: "false" # # 如果集群中没有部署 metric server,请将此设置为 "true"

# 如果要启动日志功能,请假以下值设置为 "enabled"

hotPlugEnable:

pivot:

logseer: "disabled"

logagent: "disabled"

elasticsearch: "disabled"

localKubeConfig: xx # 管控集群的 kubeconfig 的 base64

pivotKubeConfig: xx # 管控集群的 kubeconfig 的 base64

warden:

containers:

warden:

args:

cluster: "pivot-cluster" # 管控集群名

部署 KubeCube

helm install kubecube -n kubecube-system --create-namespace ./kubecube-chart -f ./pivot-value.yaml

卸载管控集群中的 KubeCube

注意:not found 错误可以被忽略

- 手动清理 webhook

kubectl delete validatingwebhookconfigurations kubecube-validating-webhook-configuration warden-validating-webhook-configuration kubecube-monitoring-admission

- 卸载 KubeCube chart

helm uninstall kubecube -n kubecube-system

- 清理残留资源

kubectl delete sa/kubecube-pre-job -n kubecube-system

kubectl delete clusterRole/kubecube-pre-job

kubectl delete clusterRoleBinding/kubecube-pre-job

kubectl delete ns kubecube-system hnc-system kubecube-monitoring

3.3.2 - 通过helm纳管计算集群

使用 helm 的方式在计算集群中安装 Warden(KubeCube 的计算集群 agent),安装完成后,Warden 将主动向管控集群的 KubeCube 注册计算集群信息,完成计算集群的纳管。

v1.8.x

要求

- 已有 K8s 集群环境

- helm v3 客户端

下载 KubeCube helm chart 包

KUBECUBE_VERSION=v1.8

curl -s https://kubecube.nos-eastchina1.126.net/kubecube-chart/${KUBECUBE_VERSION}/kubecube-chart.tar.gz | tar -xz

通过 helm 在计算集群上安装 Warden

创建 member-value.yaml 文件并填写必要的 value 值

# member-value.yaml

global:

# 管控集群的 Node IP,用来暴露 KubeCube 的 NodePort service

nodeIP: x.x.x.x

dependencesEnable:

ingressController: "false" # 如果集群中没有部署 ingress controller,请将此设置为 true

localPathStorage: "false" # 如果集群中没有部署 local path storage,请将此设置为 true

metricServer: "false" # # 如果集群中没有部署 metric server,请将此设置为 true

# 以下为计算集群指定安装组件,请不要修改

componentsEnable:

kubecube: "false"

warden: "true"

audit: "false"

webconsole: "false"

cloudshell: "false"

frontend: "false"

# 如果要启动日志功能,请假以下值设置为 "enabled"

hotPlugEnable:

common:

logagent: "disabled"

localKubeConfig: xx # 当前集群的 kubeconfig 的 base64

pivotKubeConfig: xx # 管控集群的 kubeconfig 的 base64

warden:

containers:

warden:

args:

inMemberCluster: true

cluster: "member-cluster" # 集群集群名

部署 Warden

helm install warden -n kubecube-system --create-namespace ./kubecube-chart -f ./pivot-value.yaml

卸载计算集群中的 warden

注意:not found 错误可以被忽略

- 在管控面删除 cluster cr

kubectl delete cluster {计算集群名}

- 在计算集群手动清理 webhook

kubectl delete validatingwebhookconfigurations kubecube-validating-webhook-configuration warden-validating-webhook-configuration kubecube-monitoring-admission

- 在计算集群卸载 warden chart

helm uninstall warden -n kubecube-system

- 再计算集群清理残留资源

kubectl delete sa/kubecube-pre-job -n kubecube-system

kubectl delete clusterRole/kubecube-pre-job

kubectl delete clusterRoleBinding/kubecube-pre-job

kubectl delete ns kubecube-system hnc-system kubecube-monitoring

3.4 - 使用 hotplug 进行拓展

3.4.1 - 热插拔 hotplug 介绍

热插拔是通过修改配置文件实现不停机更新监控、日志、审计等组件的启停和配置。

热插拔

热插拔的实现是基于 helm ,因此集群需要预先安装好 helm3 版本。

登录管控 k8s 集群,执行命令可以查看热插拔配置

# kubectl get hotplug

NAME PHASE AGE

common running 23h

pivot-cluster running 16d

其中:

common表示公共的热插拔配置,pivot-cluster表示 pivot-cluster 这个 k8s 集群的热插拔配置。允许自定义各个集群的热插拔配置覆盖 common 热插拔配置实现个性化配置 k8s 集群组件热插拔。

热插拔配置的

.metadata.name要求与k8s集群名称一致,所有 k8s 集群信息查看命令为kubectl get cluster。

Common配置说明

目前,默认的 common 配置包括以下几个组件:

logseer:日志管理组件,仅在管控集群安装

logagent:日志采集代理组件

kubecube-monitoring:监控 prometheuse 组件

kubecube-thanos:监控 thanos 组件,仅在管控集群安装

示例如下:

apiVersion: hotplug.kubecube.io/v1

kind: Hotplug

metadata:

annotations:

kubecube.io/sync: "true" ## 同步信号,kubecube会将这个配置同步到各个集群

name: common ## 公共配置为cmmon,其余集群特殊配置为集群名字

spec:

component:

- name: audit ## 审计日志

status: disabled

- name: logseer ## 日志管理组件

namespace: logseer

pkgName: logseer-v1.0.0.tgz

status: disabled ## 启停标识:这里disabled为禁用

- name: logagent ## 日志采集代理组件

namespace: logagent

pkgName: logagent-v1.0.0.tgz

status: enabled ## 启停标识:这里enabled为启用

env: | ## 环境变量

clustername: "{{.cluster}}" ## {{.cluster}} 程序会自动注入集群名字替换

- name: kubecube-monitoring ## 监控组件

namespace: kubecube-monitoring

pkgName: kubecube-monitoring-15.4.7.tgz

status: enabled

env: |

grafana:

enabled: false

prometheus:

prometheusSpec:

externalLabels:

cluster: "{{.cluster}}"

remoteWrite:

- url: http://10.173.32.42:31291/api/v1/receive

- name: kubecube-thanos ## 监控thanos组件

namespace: kubecube-monitoring

pkgName: thanos-3.18.0.tgz

status: disabled

status: ## message显示各个组件运行状态,phase显示总体运行状态

message: '{"kubecube-monitoring":"release is running","kubecube-thanos":"release

is running","logagent":"release is running","logseer":"release is running"}'

phase: running

每一个组件基本包含5个要素,在 spec.component 下:

name:组件名称

namespace:指定组件部署的命名空间,若指定的命名空间不存在,会自动以该字段值去创建一个命名空间。

pkgName:安装包名称,安装包默认存放路径为 warden 容器里的 /root/helmchartpkg,以 emptydir 形式存在。

status:组件是否启用

env:环境变量配置

每一个要素都可以使用集群独特配置进行覆盖,未覆盖的要素则依然使用 common 里的配置。

管控集群配置说明

Pivot-cluster 配置是管控集群配置,即 KubeCube 所在的集群。集群独特的配置会与 common 的配置结合,用于个性化配置集群组件,结合时遇到相同字段pivot-cluster 优先。

apiVersion: hotplug.kubecube.io/v1

kind: Hotplug

metadata:

annotations:

kubecube.io/sync: "true" ## 同步信号,kubecube会将这个配置同步到其他集群

name: pivot-cluster ## 与集群名字一致,指明这是pivot-cluster这个集群的热插拔配置

spec:

component:

- name: logseer ## 日志管理组件

status: enabled ## 结合common设置为disabled,这里设置为enabled,标识其余集群不启用,pivot-cluster集群启用

- name: kubecube-monitoring

env: |

grafana:

enabled: true

prometheus:

prometheusSpec:

externalLabels:

cluster: "{{.cluster}}"

remoteWrite:

- url: http://thanos-receive:19291/api/v1/receive

- name: kubecube-thanos

status: enabled

env: |

receive:

replicaCount: 1

replicationFactor: 1

status:

message: '{"kubecube-monitoring":"release is running","kubecube-thanos":"release

is running","logagent":"release is running","logseer":"release is running"}'

phase: running

3.4.2 - 通过 hotplug 启用 loggie

KubeCube 使用 hotplug 热插拔方式集成 Loggie,用户可以通过打开 hotplug 中关于日志部分的开关来开启 Loggie。我们有两个时间点可以用来开启 Loggie。

在使用 Helm 安装 KubeCube 时

在使用 Helm 安装 KubeCube 时,我们可以设置以下 values 来开启 Loggie。

安装管控集群时的参数如下:

# pivot-value.yaml

...

global:

# set "enabled" if wanna open log application.

hotPlugEnable:

pivot:

logseer: "enabled"

logagent: "enabled"

elasticsearch: "enabled"

...

安装计算集群时的参数如下:

# member-value.yaml

...

global:

# set "enabled" if wanna open log application.

hotPlugEnable:

common:

logagent: "enabled"

...

在使用过程中

在使用过程中,我们也可以通过直接修改 hotplug 的方式来开启 Loggie。

修改管控集群的 hotplug 如下:

kubectl edit hotplug pivot-cluster

# pivot-cluster

apiVersion: hotplug.kubecube.io/v1

kind: Hotplug

metadata:

name: pivot-cluster

spec:

component:

- name: elasticsearch

namespace: elasticsearch

pkgName: elasticsearch-7.8.1.tgz

status: enabled # 将该值设为 enabled 来开启日志

...

- name: logseer

status: enabled # 将该值设为 enabled 来开启日志

- name: logagent

status: enabled # 将该值设为 enabled 来开启日志

修改计算集群的 hotplug 如下:

kubectl edit hotplug common

# common

apiVersion: hotplug.kubecube.io/v1

kind: Hotplug

metadata:

name: common

spec:

component:

...

- env: |

clustername: "{{.cluster}}"

elasticsearch:

address: x.x.x.x:32200 # 填写管控集群的 es 的 nodeport svc 访问地址,一般为 {nodeIP}:32200

name: logagent

namespace: logagent

pkgName: logagent-1.3.0.tgz

status: enabled # 将该值设为 enabled 来开启日志

3.5 - 使用脚本安装 K8s 和 KubeCube(已废弃)

3.5.1 - 在已有k8s集群中部署KubeCube

v1.4.x

在 Kubernetes 集群中部署 KubeCube

开始安装

在 Linux 机器上执行部署脚本

KUBECUBE_VERSION=v1.4

export CUSTOMIZE="true";curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

设置安装脚本参数

该安装模式下,需要修改以下参数:

# if install kubecube on pivot cluster

INSTALL_KUBECUBE_PIVOT="true"

# if install k8s

INSTALL_KUBERNETES="false"

# k8s cni, support now is calico only

CNI="calico"

# there are four node mode below:

# "master" : node will be installed as a master of cluster

# "node-join-master" : node will be install as a worker of cluster to join master

# "control-plane-master" : node will be installed as a master to control plane of cluster

# "node-join-control-plane" : node will be installed as a master to join control plane

NODE_MODE="master"

# zone has two choice

# 1. "cn" : in mainland

# 2. "others" : out of mainland

ZONE="cn"

# k8s version you want to install

# support now is: 1.19.13, 1.20.9, 1.21.2, 1.22.2, 1.23.5

KUBERNETES_VERSION="1.23.5"

# +optional

# must be set when NODE_MODE="control-plane-master"

# or "node-join-control-plane"

CONTROL_PLANE_ENDPOINT="" #{ip}:{port} , dns

# +optional

# KUBERNETES_BIND_ADDRESS generally is node_ip

# can be set when NODE_MODE="master" ot "control-plane-master"

# default value is $(hostname -I |awk '{print $1}')

KUBERNETES_BIND_ADDRESS="" #{node_ip}

#######################################################################

# member cluster config

# used when INSTALL_KUBECUBE_MEMBER="true"

#######################################################################

# if install kubecube on member cluster

INSTALL_KUBECUBE_MEMBER="false"

# +optional

# KUBECUBE_HOST must be set when as a member cluster to

# join pivot cluster, the value is pivot node ip

KUBECUBE_HOST=""

# +optional

# must be set when INSTALL_KUBECUBE_MEMBER="true"

# this value is the name of member cluster you

# want to take over

MEMBER_CLUSTER_NAME=""

#######################################################################

# ssh config

# used when NODE_MODE="node-join-master" or node-join-control-plane

#######################################################################

# +optional

# master ip means master node ip of cluster

MASTER_IP=""

# +optional

# the user who can access master node, it can be empty

SSH_USER="root"

# +optional

# the port specified to access master node, it can be empty

SSH_PORT=22

# +optional

# must be empty when ACCESS_PRIVATE_KEY_PATH set

# password for master user to access master node

ACCESS_PASSWORD=""

# +optional

# must be empty when ACCESS_PASSWORD set

# ACCESS_PRIVATE_KEY for master user to access master node

ACCESS_PRIVATE_KEY_PATH="/root/.ssh/id_rsa"

#######################################################################

# offline config

# used when offline install choose, must lift offline pkg first

#######################################################################

OFFLINE_INSTALL="false"

OFFLINE_PKG_PATH=""

#######################################################################

# container runtime config

# if value is docker, then use docker as container runtime

# else if value is containerd, then use containerd as container runtime

#######################################################################

CONTAINER_RUNTIME="docker"

等待部署完成

KubeCube 部署完成后,请根据提示信息登陆 console 管理页面

使用 admin 账户登陆 console

⚠️请在登陆后修改 admin 用户的密码

v1.2.x

在 Kubernetes 集群中部署 KubeCube

开始安装

在 Linux 机器上执行部署脚本

KUBECUBE_VERSION=v1.2

export CUSTOMIZE="true";curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

设置安装脚本参数

该安装模式下,需要修改以下参数:

# if install kubecube on pivot cluster

INSTALL_KUBECUBE_PIVOT="true"

# if install k8s

INSTALL_KUBERNETES="false"

# k8s cni, support now is calico only

CNI="calico"

# there are four node mode below:

# "master" : node will be installed as a master of cluster

# "node-join-master" : node will be install as a worker of cluster to join master

# "control-plane-master" : node will be installed as a master to control plane of cluster

# "node-join-control-plane" : node will be installed as a master to join control plane

NODE_MODE="master"

# zone has two choice

# 1. "cn" : in mainland

# 2. "others" : out of mainland

ZONE="cn"

# k8s version you want to install

# support now is: 1.19.13, 1.20.9, 1.21.2, 1.22.2, 1.23.5

KUBERNETES_VERSION="1.23.5"

# +optional

# must be set when NODE_MODE="control-plane-master"

# or "node-join-control-plane"

CONTROL_PLANE_ENDPOINT="" #{ip}:{port} , dns

# +optional

# KUBERNETES_BIND_ADDRESS generally is node_ip

# can be set when NODE_MODE="master" ot "control-plane-master"

# default value is $(hostname -I |awk '{print $1}')

KUBERNETES_BIND_ADDRESS="" #{node_ip}

#######################################################################

# member cluster config

# used when INSTALL_KUBECUBE_MEMBER="true"

#######################################################################

# if install kubecube on member cluster

INSTALL_KUBECUBE_MEMBER="false"

# +optional

# KUBECUBE_HOST must be set when as a member cluster to

# join pivot cluster, the value is pivot node ip

KUBECUBE_HOST=""

# +optional

# must be set when INSTALL_KUBECUBE_MEMBER="true"

# this value is the name of member cluster you

# want to take over

MEMBER_CLUSTER_NAME=""

#######################################################################

# ssh config

# used when NODE_MODE="node-join-master" or node-join-control-plane

#######################################################################

# +optional

# master ip means master node ip of cluster

MASTER_IP=""

# +optional

# the user who can access master node, it can be empty

SSH_USER="root"

# +optional

# the port specified to access master node, it can be empty

SSH_PORT=22

# +optional

# must be empty when ACCESS_PRIVATE_KEY_PATH set

# password for master user to access master node

ACCESS_PASSWORD=""

# +optional

# must be empty when ACCESS_PASSWORD set

# ACCESS_PRIVATE_KEY for master user to access master node

ACCESS_PRIVATE_KEY_PATH="/root/.ssh/id_rsa"

#######################################################################

# offline config

# used when offline install choose, must lift offline pkg first

#######################################################################

OFFLINE_INSTALL="false"

OFFLINE_PKG_PATH=""

#######################################################################

# container runtime config

# if value is docker, then use docker as container runtime

# else if value is containerd, then use containerd as container runtime

#######################################################################

CONTAINER_RUNTIME="containerd"

等待部署完成

KubeCube 部署完成后,请根据提示信息登陆 console 管理页面

使用 admin 账户登陆 console

⚠️请在登陆后修改 admin 用户的密码

v1.1.x

在 Kubernetes 集群中部署 KubeCube

开始安装

在 Linux 机器上执行部署脚本

KUBECUBE_VERSION=v1.1

export CUSTOMIZE="true";curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

设置安装脚本参数

该安装模式下,需要修改以下参数:

INSTALL_KUBECUBE_MEMBER=“false”

MASTER_IP="${node ip}"

${node ip} 表示你运行脚本所在 node 机器的 ip,该 node 需要可操作 kubectl

# if install kubecube on pivot cluster

INSTALL_KUBECUBE_PIVOT="true"

# if install k8s

INSTALL_KUBERNETES="false"

# there are four node mode below:

# "master" : node will be installed as a master of cluster

# "node-join-master" : node will be install as a worker of cluster to join master

# "control-plane-master" : node will be installed as a master to control plane of cluster

# "node-join-control-plane" : node will be installed as a master to join control plane

NODE_MODE="master"

# zone has two choice

# 1. "cn" : in mainland

# 2. "others" : out of mainland

ZONE="cn"

# k8s version you want to install

# support now is: 1.20.9, 1.19.13, 1.18.20, 1.21.2

KUBERNETES_VERSION="1.20.9"

# +optional

# must be set when NODE_MODE="control-plane-master"

# or "node-join-control-plane"

CONTROL_PLANE_ENDPOINT="" #{ip}:{port} , dns

#######################################################################

# member cluster config

# used when INSTALL_KUBECUBE_MEMBER="true"

#######################################################################

# if install kubecube on member cluster

INSTALL_KUBECUBE_MEMBER="false"

# +optional

# KUBECUBE_HOST must be set when as a member cluster to

# join pivot cluster, the value is pivot node ip

KUBECUBE_HOST=""

# +optional

# must be set when INSTALL_KUBECUBE_MEMBER="true"

# this value is the name of member cluster you

# want to take over

MEMBER_CLUSTER_NAME=""

#######################################################################

# ssh config

# used when NODE_MODE="node-join-master" or node-join-control-plane

#######################################################################

# +optional

# master ip means master node ip of cluster

MASTER_IP=""

# +optional

# the user who can access master node, it can be empty

SSH_USER="root"

# +optional

# the port specified to access master node, it can be empty

SSH_PORT=22

# +optional

# must be empty when ACCESS_PRIVATE_KEY_PATH set

# password for master user to access master node

ACCESS_PASSWORD=""

# +optional

# must be empty when ACCESS_PASSWORD set

# ACCESS_PRIVATE_KEY for master user to access master node

ACCESS_PRIVATE_KEY_PATH="/root/.ssh/id_rsa"

#######################################################################

# offline config

# used when offline install choose, must lift offline pkg first

#######################################################################

OFFLINE_INSTALL="false"

OFFLINE_PKG_PATH=""

等待部署完成

KubeCube 部署完成后,请根据提示信息登陆 console 管理页面

使用 admin 账户登陆 console

⚠️请在登陆后修改 admin 用户的密码

v1.0.x

在 Kubernetes 集群中部署 KubeCube

⚠️修改 Kubernetes API-Server 配置

必要性

KubeCube 对多集群提供统一的认证和鉴权服务,需要使用 k8s api-server 的 auth-webhook 能力来做拓展。

KubeCube 提供对 k8s-apiserver 日志进行审计的能力,这需要为 k8s api-server 指定审计服务后端。

修改操作

如果您的 k8s api-server 服务是以 deployment 形式运行的,请直接修改 deployment ;如果您的 k8s api-server 服务是以 static pod 形式运行的,您需要修改对应的 manifest 文件,它的文件路径通常为 /etc/kubernetes/manifests/kube-apiserver.yaml ,修改内容如下:

apiVersion: v1

kind: Pod

metadata:

name: kube-apiserver

namespace: kube-system

spec:

containers:

- command:

- kube-apiserver

- --audit-log-format=json

- --audit-log-maxage=10

- --audit-log-maxbackup=10

- --audit-log-maxsize=100

- --audit-log-path=/var/log/audit

- --audit-policy-file=/etc/cube/audit/audit-policy.yaml

- --audit-webhook-config-file=/etc/cube/audit/audit-webhook.config

- --authentication-token-webhook-config-file=/etc/cube/warden/webhook.config

name: kube-apiserver

volumeMounts:

- mountPath: /var/log/audit

name: audit-log

- mountPath: /etc/cube

name: cube

readOnly: true

volumes:

- hostPath:

path: /var/log/audit

type: DirectoryOrCreate

name: audit-log

- hostPath:

path: /etc/cube

type: DirectoryOrCreate

name: cube

开始安装

在 Linux 机器上执行部署脚本

KUBECUBE_VERSION=v1.0

export CUSTOMIZE="true";curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

设置安装脚本参数

该安装模式下,需要修改以下参数:

INSTALL_KUBECUBE_MEMBER=“false”

MASTER_IP="${node ip}"

${node ip} 表示你运行脚本所在 node 机器的 ip,该 node 需要可操作 kubectl

# if install kubecube on pivot cluster

INSTALL_KUBECUBE_PIVOT="true"

# if install kubecube on member cluster

INSTALL_KUBECUBE_MEMBER="false"

# if install k8s

INSTALL_KUBERNETES="false"

# there are four node mode below:

# "master" : node will be installed as a master of cluster

# "node-join-master" : node will be install as a worker of cluster to join master

# "control-plane-master" : node will be installed as a master to control plane of cluster

# "node-join-control-plane" : node will be installed as a master to join control plane

NODE_MODE="master"

# +optional

# must be set when INSTALL_KUBECUBE_MEMBER="true"

# this value is the name of member cluster you

# want to take over

MEMBER_CLUSTER_NAME=""

# +optional

# must be set when NODE_MODE="control-plane-master"

# or "node-join-control-plane"

CONTROL_PLANE_ENDPOINT="" #{ip}:{port} , dns

# master ip means master node ip of cluster

MASTER_IP="x.x.x.x"

# +optional

# KUBECUBE_HOST must be set when as a member cluster to

# join pivot cluster, the value is pivot node ip

KUBECUBE_HOST=""

# zone has two choice

# 1. "cn" : in mainland

# 2. "others" : out of mainland

ZONE="cn"

# k8s version you want to install

KUBERNETES_VERSION="1.20.9"

# +optional

# the user who can access master node, it can be empty

# when NODE_MODE="master" or "control-plane-master"

SSH_USER="root"

# +optional

# the port specified to access master node, it can be empty

# when NODE_MODE="master" or "control-plane-master"

SSH_PORT=22

# +optional

# must be empty when ACCESS_PRIVATE_KEY_PATH set

# password for master user to access master node

ACCESS_PASSWORD=""

# +optional

# must be empty when ACCESS_PASSWORD set

# ACCESS_PRIVATE_KEY for master user to access master node

ACCESS_PRIVATE_KEY_PATH="/root/.ssh/id_rsa"

等待部署完成

KubeCube 部署完成后,请根据提示信息登陆 console 管理页面

使用 admin 账户登陆 console

⚠️请在登陆后修改 admin 用户的密码

3.5.2 - 添加计算集群

KubeCube 可以添加其它集群作为计算集群,前提是,计算集群能够访问管控集群的 k8s api-server 和 KubeCube,默认情况下 KubeCube 使用 NodePort 对外暴露服务,用户可自行使用 ingress 进行暴露

v1.4.x

方式一:部署新集群并添加

在 linux 机器上,需要构建 Kubernetes 集群并安装 KubeCube 依赖项

开始安装

KUBECUBE_VERSION=v1.4

export CUSTOMIZE="true";curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

设置安装脚本参数

该安装模式下,需要修改以下参数:

INSTALL_KUBECUBE_PIVOT=“false”

INSTALL_KUBECUBE_MEMBER=“true”

INSTALL_KUBERNETES=“true”

MEMBER_CLUSTER_NAME=“member-1”

MASTER_IP="${node ip}"

KUBECUBE_HOST="${pivot node ip}"

MEMBER_CLUSTER_NAME 表示计算集群的名字,注意,不能与已有的计算集群名称同名, ${node ip} 表示你运行脚本所在 node 机器的 ip,该 node 需要可操作 kubectl, ${pivot node ip} 表示管控集群 node 机器的 ip,用于向 KubeCube 注册集群

# if install kubecube on pivot cluster

INSTALL_KUBECUBE_PIVOT="false"

# if install k8s

INSTALL_KUBERNETES="true"

# k8s cni, support now is calico only

CNI="calico"

# there are four node mode below:

# "master" : node will be installed as a master of cluster

# "node-join-master" : node will be install as a worker of cluster to join master

# "control-plane-master" : node will be installed as a master to control plane of cluster

# "node-join-control-plane" : node will be installed as a master to join control plane

NODE_MODE="master"

# zone has two choice

# 1. "cn" : in mainland

# 2. "others" : out of mainland

ZONE="cn"

# k8s version you want to install

# support now is: 1.19.13, 1.20.9, 1.21.2, 1.22.2, 1.23.5

KUBERNETES_VERSION="1.23.5"

# +optional

# must be set when NODE_MODE="control-plane-master"

# or "node-join-control-plane"

CONTROL_PLANE_ENDPOINT="" #{ip}:{port} , dns

# +optional

# KUBERNETES_BIND_ADDRESS generally is node_ip

# can be set when NODE_MODE="master" ot "control-plane-master"

# default value is $(hostname -I |awk '{print $1}')

KUBERNETES_BIND_ADDRESS="" #{node_ip}

#######################################################################

# member cluster config

# used when INSTALL_KUBECUBE_MEMBER="true"

#######################################################################

# if install kubecube on member cluster

INSTALL_KUBECUBE_MEMBER="true"

# +optional

# KUBECUBE_HOST must be set when as a member cluster to

# join pivot cluster, the value is pivot node ip

KUBECUBE_HOST="y.y.y.y"

# +optional

# must be set when INSTALL_KUBECUBE_MEMBER="true"

# this value is the name of member cluster you

# want to take over

MEMBER_CLUSTER_NAME="member-1"

#######################################################################

# ssh config

# used when NODE_MODE="node-join-master" or node-join-control-plane

#######################################################################

# +optional

# master ip means master node ip of cluster

MASTER_IP=""

# +optional

# the user who can access master node, it can be empty

SSH_USER="root"

# +optional

# the port specified to access master node, it can be empty

SSH_PORT=22

# +optional

# must be empty when ACCESS_PRIVATE_KEY_PATH set

# password for master user to access master node

ACCESS_PASSWORD=""

# +optional

# must be empty when ACCESS_PASSWORD set

# ACCESS_PRIVATE_KEY for master user to access master node

ACCESS_PRIVATE_KEY_PATH="/root/.ssh/id_rsa"

#######################################################################

# offline config

# used when offline install choose, must lift offline pkg first

#######################################################################

OFFLINE_INSTALL="false"

OFFLINE_PKG_PATH=""

#######################################################################

# container runtime config

# if value is docker, then use docker as container runtime

# else if value is containerd, then use containerd as container runtime

#######################################################################

CONTAINER_RUNTIME="docker"

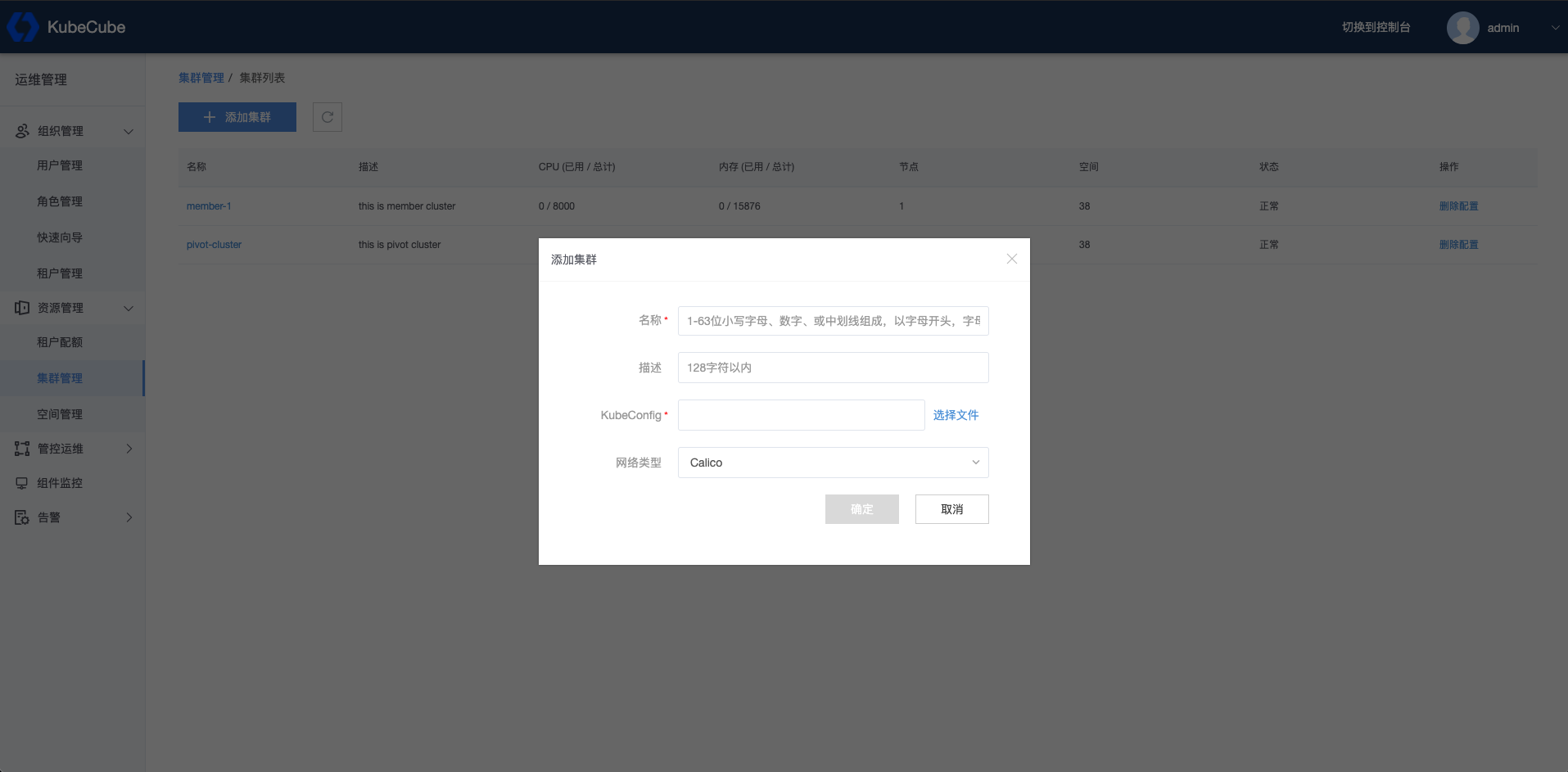

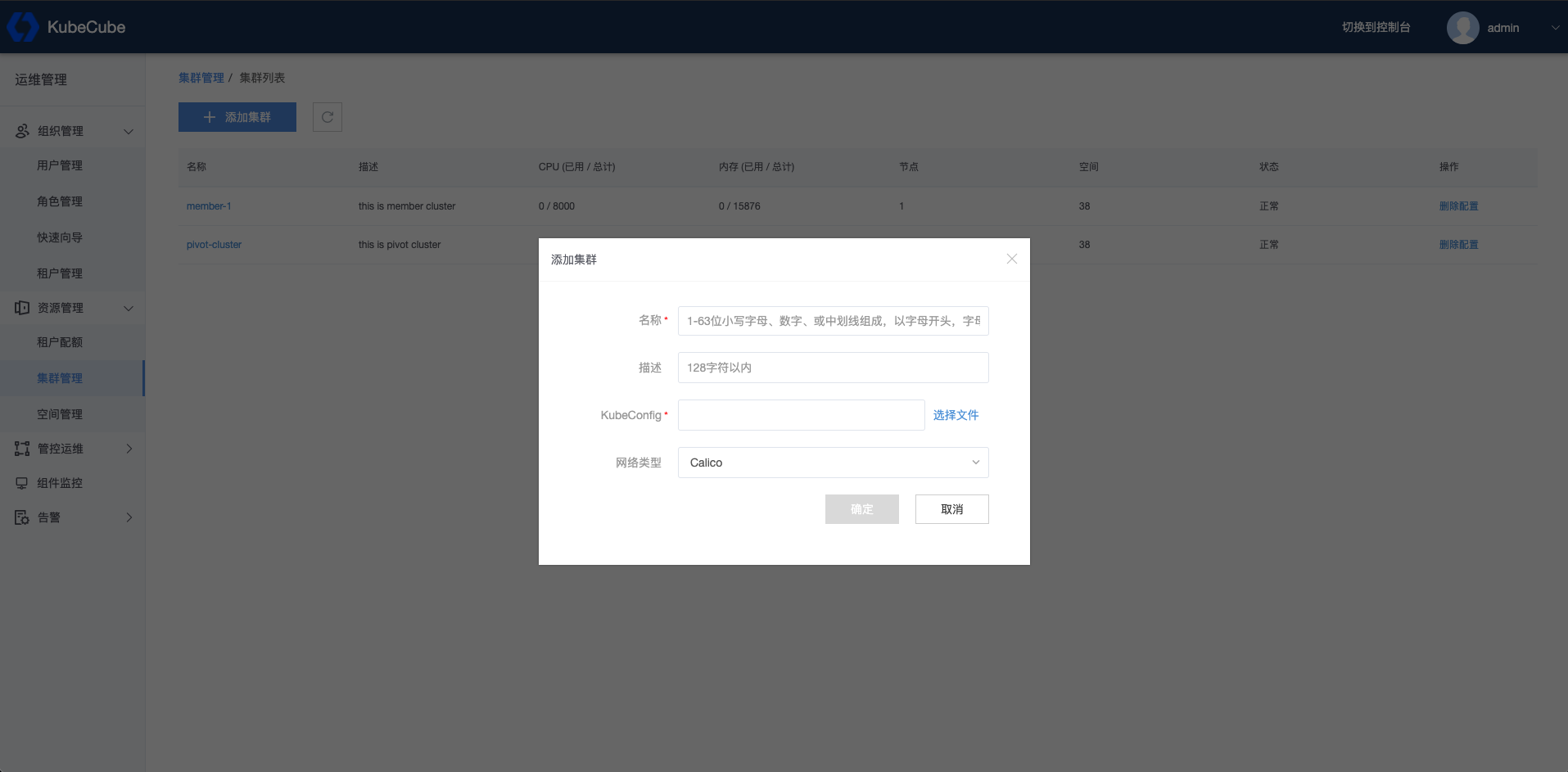

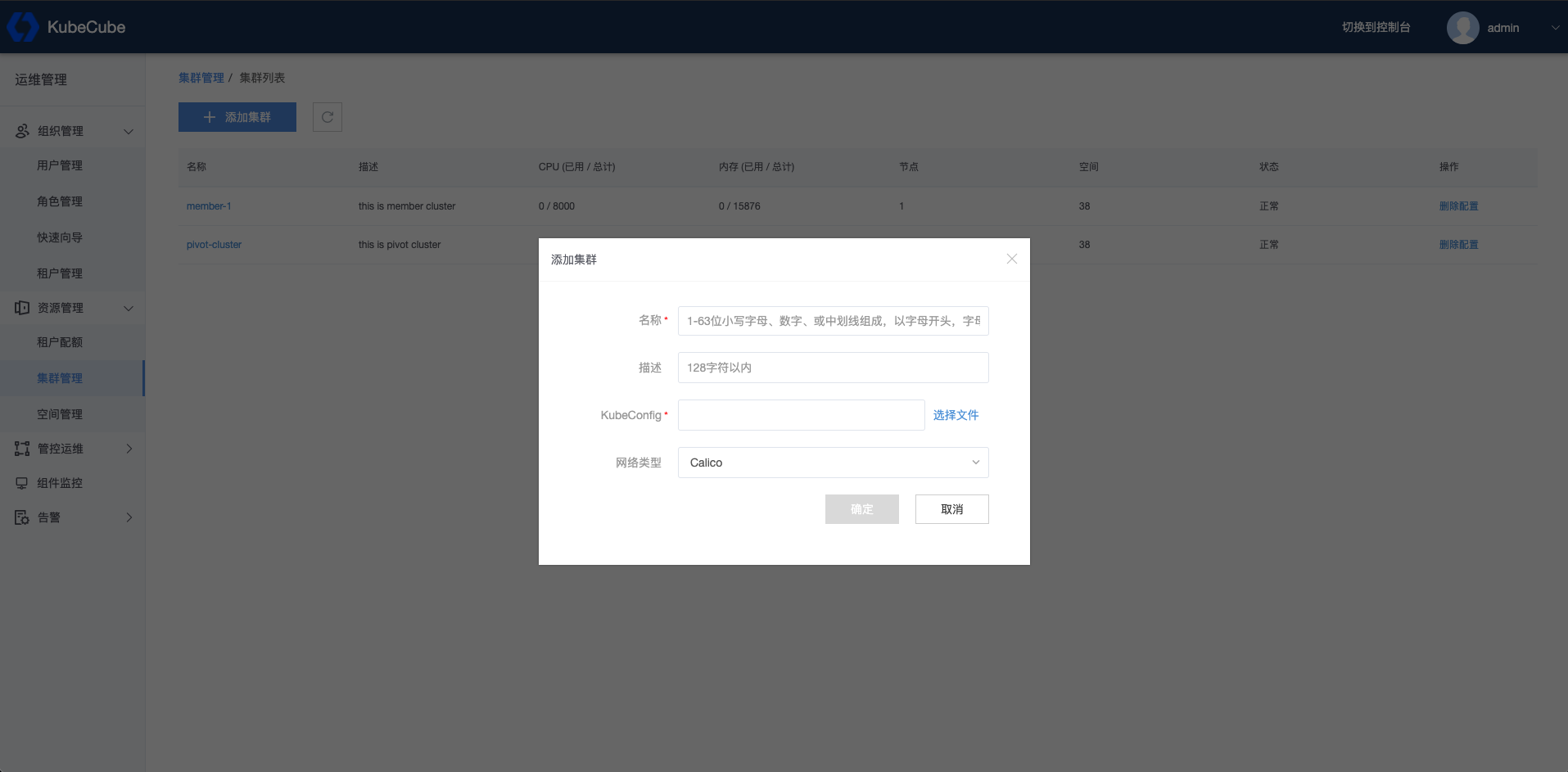

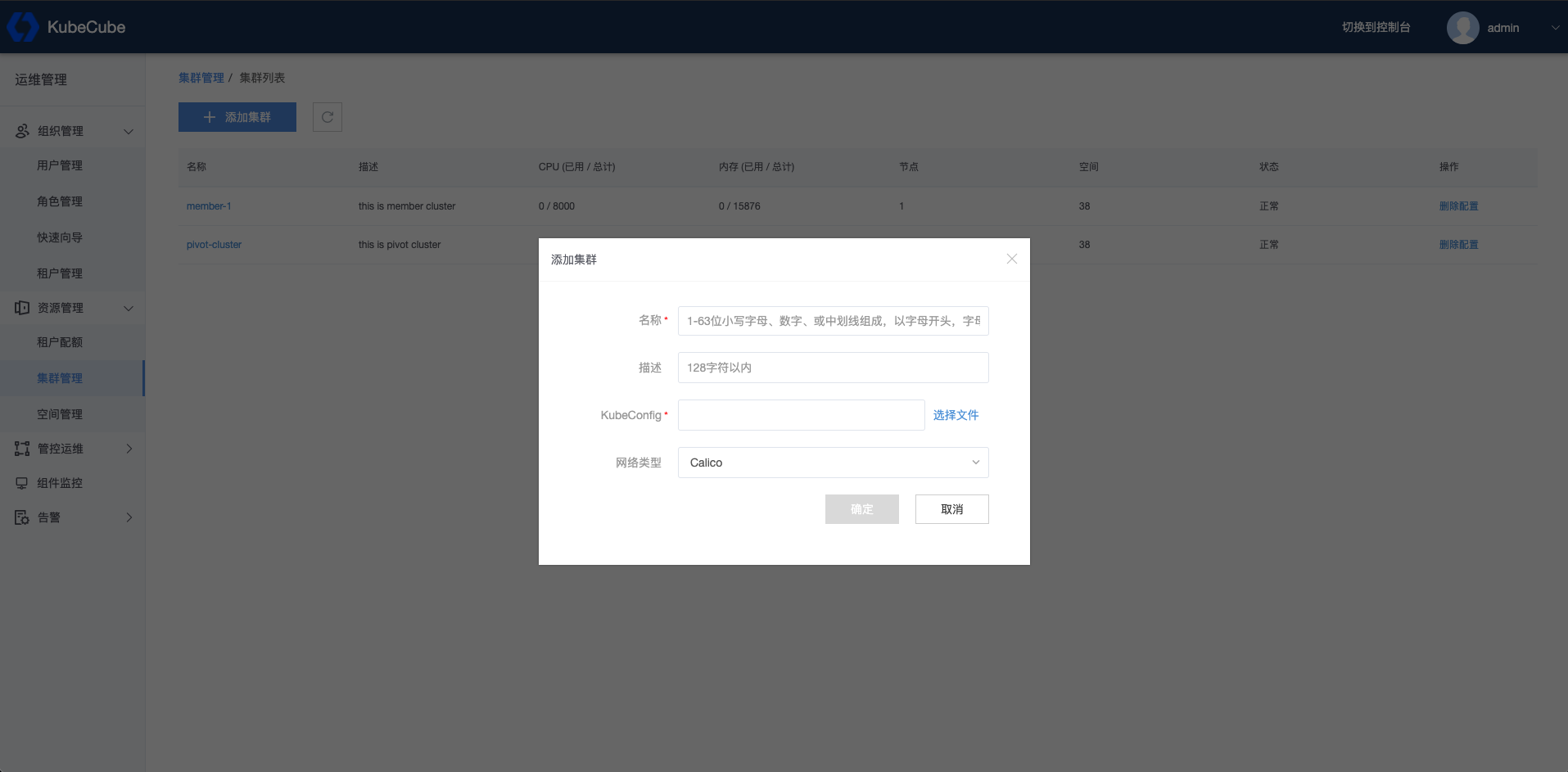

方式二:纳管已有集群

添加已有集群只需从 console 页面导入集群信息即可

在 console 页面中导入集群信息

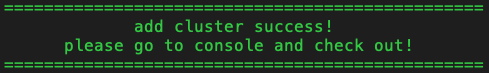

在 console 中确认新集群

v1.2.x

方式一:部署新集群并添加

在 linux 机器上,需要构建 Kubernetes 集群并安装 KubeCube 依赖项

开始安装

KUBECUBE_VERSION=v1.2

export CUSTOMIZE="true";curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

设置安装脚本参数

该安装模式下,需要修改以下参数:

INSTALL_KUBECUBE_PIVOT=“false”

INSTALL_KUBECUBE_MEMBER=“true”

INSTALL_KUBERNETES=“true”

MEMBER_CLUSTER_NAME=“member-1”

MASTER_IP="${node ip}"

KUBECUBE_HOST="${pivot node ip}"

MEMBER_CLUSTER_NAME 表示计算集群的名字,注意,不能与已有的计算集群名称同名, ${node ip} 表示你运行脚本所在 node 机器的 ip,该 node 需要可操作 kubectl, ${pivot node ip} 表示管控集群 node 机器的 ip,用于向 KubeCube 注册集群

# if install kubecube on pivot cluster

INSTALL_KUBECUBE_PIVOT="false"

# if install k8s

INSTALL_KUBERNETES="true"

# k8s cni, support now is calico only

CNI="calico"

# there are four node mode below:

# "master" : node will be installed as a master of cluster

# "node-join-master" : node will be install as a worker of cluster to join master

# "control-plane-master" : node will be installed as a master to control plane of cluster

# "node-join-control-plane" : node will be installed as a master to join control plane

NODE_MODE="master"

# zone has two choice

# 1. "cn" : in mainland

# 2. "others" : out of mainland

ZONE="cn"

# k8s version you want to install

# support now is: 1.19.13, 1.20.9, 1.21.2, 1.22.2, 1.23.5

KUBERNETES_VERSION="1.23.5"

# +optional

# must be set when NODE_MODE="control-plane-master"

# or "node-join-control-plane"

CONTROL_PLANE_ENDPOINT="" #{ip}:{port} , dns

# +optional

# KUBERNETES_BIND_ADDRESS generally is node_ip

# can be set when NODE_MODE="master" ot "control-plane-master"

# default value is $(hostname -I |awk '{print $1}')

KUBERNETES_BIND_ADDRESS="" #{node_ip}

#######################################################################

# member cluster config

# used when INSTALL_KUBECUBE_MEMBER="true"

#######################################################################

# if install kubecube on member cluster

INSTALL_KUBECUBE_MEMBER="true"

# +optional

# KUBECUBE_HOST must be set when as a member cluster to

# join pivot cluster, the value is pivot node ip

KUBECUBE_HOST="y.y.y.y"

# +optional

# must be set when INSTALL_KUBECUBE_MEMBER="true"

# this value is the name of member cluster you

# want to take over

MEMBER_CLUSTER_NAME="member-1"

#######################################################################

# ssh config

# used when NODE_MODE="node-join-master" or node-join-control-plane

#######################################################################

# +optional

# master ip means master node ip of cluster

MASTER_IP=""

# +optional

# the user who can access master node, it can be empty

SSH_USER="root"

# +optional

# the port specified to access master node, it can be empty

SSH_PORT=22

# +optional

# must be empty when ACCESS_PRIVATE_KEY_PATH set

# password for master user to access master node

ACCESS_PASSWORD=""

# +optional

# must be empty when ACCESS_PASSWORD set

# ACCESS_PRIVATE_KEY for master user to access master node

ACCESS_PRIVATE_KEY_PATH="/root/.ssh/id_rsa"

#######################################################################

# offline config

# used when offline install choose, must lift offline pkg first

#######################################################################

OFFLINE_INSTALL="false"

OFFLINE_PKG_PATH=""

#######################################################################

# container runtime config

# if value is docker, then use docker as container runtime

# else if value is containerd, then use containerd as container runtime

#######################################################################

CONTAINER_RUNTIME="containerd"

方式二:纳管已有集群

添加已有集群只需从 console 页面导入集群信息即可

在 console 页面中导入集群信息

在 console 中确认新集群

v1.1.x

方式一:部署新集群并添加

在 linux 机器上,需要构建 Kubernetes 集群并安装 KubeCube 依赖项

开始安装

KUBECUBE_VERSION=v1.1

export CUSTOMIZE="true";curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

设置安装脚本参数

该安装模式下,需要修改以下参数:

INSTALL_KUBECUBE_PIVOT=“false”

INSTALL_KUBECUBE_MEMBER=“true”

INSTALL_KUBERNETES=“true”

MEMBER_CLUSTER_NAME=“member-1”

MASTER_IP="${node ip}"

KUBECUBE_HOST="${pivot node ip}"

MEMBER_CLUSTER_NAME 表示计算集群的名字,注意,不能与已有的计算集群名称同名, ${node ip} 表示你运行脚本所在 node 机器的 ip,该 node 需要可操作 kubectl, ${pivot node ip} 表示管控集群 node 机器的 ip,用于向 KubeCube 注册集群

# if install kubecube on pivot cluster

INSTALL_KUBECUBE_PIVOT="false"

# if install k8s

INSTALL_KUBERNETES="true"

# there are four node mode below:

# "master" : node will be installed as a master of cluster

# "node-join-master" : node will be install as a worker of cluster to join master

# "control-plane-master" : node will be installed as a master to control plane of cluster

# "node-join-control-plane" : node will be installed as a master to join control plane

NODE_MODE="master"

# zone has two choice

# 1. "cn" : in mainland

# 2. "others" : out of mainland

ZONE="cn"

# k8s version you want to install

# support now is: 1.20.9, 1.19.13, 1.18.20, 1.21.2

KUBERNETES_VERSION="1.20.9"

# +optional

# must be set when NODE_MODE="control-plane-master"

# or "node-join-control-plane"

CONTROL_PLANE_ENDPOINT="" #{ip}:{port} , dns

#######################################################################

# member cluster config

# used when INSTALL_KUBECUBE_MEMBER="true"

#######################################################################

# if install kubecube on member cluster

INSTALL_KUBECUBE_MEMBER="true"

# +optional

# KUBECUBE_HOST must be set when as a member cluster to

# join pivot cluster, the value is pivot node ip

KUBECUBE_HOST="y.y.y.y"

# +optional

# must be set when INSTALL_KUBECUBE_MEMBER="true"

# this value is the name of member cluster you

# want to take over

MEMBER_CLUSTER_NAME="member-1"

#######################################################################

# ssh config

# used when NODE_MODE="node-join-master" or node-join-control-plane

#######################################################################

# +optional

# master ip means master node ip of cluster

MASTER_IP=""

# +optional

# the user who can access master node, it can be empty

SSH_USER="root"

# +optional

# the port specified to access master node, it can be empty

SSH_PORT=22

# +optional

# must be empty when ACCESS_PRIVATE_KEY_PATH set

# password for master user to access master node

ACCESS_PASSWORD=""

# +optional

# must be empty when ACCESS_PASSWORD set

# ACCESS_PRIVATE_KEY for master user to access master node

ACCESS_PRIVATE_KEY_PATH="/root/.ssh/id_rsa"

#######################################################################

# offline config

# used when offline install choose, must lift offline pkg first

#######################################################################

OFFLINE_INSTALL="false"

OFFLINE_PKG_PATH=""

方式二:纳管已有集群

添加已有集群只需从 console 页面导入集群信息即可

在 console 页面中导入集群信息

在 console 中确认新集群

v1.0.x

方式一:部署新集群并添加

在 linux 机器上,需要构建 Kubernetes 集群并安装 KubeCube 依赖项

开始安装

KUBECUBE_VERSION=v1.0

export CUSTOMIZE="true";curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

设置安装脚本参数

该安装模式下,需要修改以下参数:

INSTALL_KUBECUBE_PIVOT=“false”

INSTALL_KUBECUBE_MEMBER=“true”

INSTALL_KUBERNETES=“true”

MEMBER_CLUSTER_NAME=“member-1”

MASTER_IP="${node ip}"

KUBECUBE_HOST="${pivot node ip}"

MEMBER_CLUSTER_NAME 表示计算集群的名字,注意,不能与已有的计算集群名称同名 ${node ip} 表示你运行脚本所在 node 机器的 ip,该 node 需要可操作 kubectl ${pivot node ip} 表示管控集群 node 机器的 ip,用于向 KubeCube 注册集群

# if install kubecube on pivot cluster

INSTALL_KUBECUBE_PIVOT="false"

# if install kubecube on member cluster

INSTALL_KUBECUBE_MEMBER="true"

# if install k8s

INSTALL_KUBERNETES="true"

# there are four node mode below:

# "master" : node will be installed as a master of cluster

# "node-join-master" : node will be install as a worker of cluster to join master

# "control-plane-master" : node will be installed as a master to control plane of cluster

# "node-join-control-plane" : node will be installed as a master to join control plane

NODE_MODE="master"

# +optional

# must be set when INSTALL_KUBECUBE_MEMBER="true"

# this value is the name of member cluster you

# want to take over

MEMBER_CLUSTER_NAME="member-1"

# +optional

# must be set when NODE_MODE="control-plane-master"

# or "node-join-control-plane"

CONTROL_PLANE_ENDPOINT="" #{ip}:{port} , dns

# master ip means master node ip of cluster

MASTER_IP="x.x.x.x"

# +optional

# KUBECUBE_HOST must be set when as a member cluster to

# join pivot cluster, the value is pivot node ip

KUBECUBE_HOST="y.y.y.y"

# zone has two choice

# 1. "cn" : in mainland

# 2. "others" : out of mainland

ZONE="cn"

# k8s version you want to install

KUBERNETES_VERSION="1.20.9"

# +optional

# the user who can access master node, it can be empty

# when NODE_MODE="master" or "control-plane-master"

SSH_USER="root"

# +optional

# the port specified to access master node, it can be empty

# when NODE_MODE="master" or "control-plane-master"

SSH_PORT=22

# +optional

# must be empty when ACCESS_PRIVATE_KEY_PATH set

# password for master user to access master node

ACCESS_PASSWORD=""

# +optional

# must be empty when ACCESS_PASSWORD set

# ACCESS_PRIVATE_KEY for master user to access master node

ACCESS_PRIVATE_KEY_PATH="/root/.ssh/id_rsa"

方式二:纳管已有集群

添加已有集群需要从 console 页面获取添加集群的定制脚本

在 console 页面中获取添加集群的脚本

使用脚本添加集群

在集群的 node 机器上,使用从 console 中下载的脚本,该机器需要能够执行 kubectl

/bin/bash add_cluster.sh

等待集群添加完成

在 console 中确认新集群

3.5.3 - 添加节点

KubeCube 提供为已有集群添加节点的能力,同时也支持使用 kubeadm 的原生方式添加节点

⚠️ 注意通过 KubeCube 的脚本添加节点时,node 机器需要能够通过 ssh 访问 master 机器,支持公钥和密码两种 ssh 方式,执行脚本前可以在 node 上 ssh 到 master 测试连通性

v1.4.x

向集群添加工作节点

在新节点上执行部署脚本

KUBECUBE_VERSION=v1.4

export CUSTOMIZE="true";curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

设置脚本参数,并按照提示继续运行安装脚本并等待新节点加入集群

- MASTER_IP 为 master 节点 ip

# if install kubecube on pivot cluster

INSTALL_KUBECUBE_PIVOT="false"

# if install k8s

INSTALL_KUBERNETES="true"

# k8s cni, support now is calico only

CNI="calico"

# there are four node mode below:

# "master" : node will be installed as a master of cluster

# "node-join-master" : node will be install as a worker of cluster to join master

# "control-plane-master" : node will be installed as a master to control plane of cluster

# "node-join-control-plane" : node will be installed as a master to join control plane

NODE_MODE="node-join-master"

# zone has two choice

# 1. "cn" : in mainland

# 2. "others" : out of mainland

ZONE="cn"

# k8s version you want to install

# support now is: 1.19.13, 1.20.9, 1.21.2, 1.22.2, 1.23.5

KUBERNETES_VERSION="1.23.5"

# +optional

# must be set when NODE_MODE="control-plane-master"

# or "node-join-control-plane"

CONTROL_PLANE_ENDPOINT="" #{ip}:{port} , dns

# +optional

# KUBERNETES_BIND_ADDRESS generally is node_ip

# can be set when NODE_MODE="master" ot "control-plane-master"

# default value is $(hostname -I |awk '{print $1}')

KUBERNETES_BIND_ADDRESS="" #{node_ip}

#######################################################################

# member cluster config

# used when INSTALL_KUBECUBE_MEMBER="true"

#######################################################################

# if install kubecube on member cluster

INSTALL_KUBECUBE_MEMBER="false"

# +optional

# KUBECUBE_HOST must be set when as a member cluster to

# join pivot cluster, the value is pivot node ip

KUBECUBE_HOST=""

# +optional

# must be set when INSTALL_KUBECUBE_MEMBER="true"

# this value is the name of member cluster you

# want to take over

MEMBER_CLUSTER_NAME=""

#######################################################################

# ssh config

# used when NODE_MODE="node-join-master" or node-join-control-plane

#######################################################################

# +optional

# master ip means master node ip of cluster

MASTER_IP=""

# +optional

# the user who can access master node, it can be empty

SSH_USER="root"

# +optional

# the port specified to access master node, it can be empty

SSH_PORT=22

# +optional

# must be empty when ACCESS_PRIVATE_KEY_PATH set

# password for master user to access master node

ACCESS_PASSWORD=""

# +optional

# must be empty when ACCESS_PASSWORD set

# ACCESS_PRIVATE_KEY for master user to access master node

ACCESS_PRIVATE_KEY_PATH="/root/.ssh/id_rsa"

#######################################################################

# offline config

# used when offline install choose, must lift offline pkg first

#######################################################################

OFFLINE_INSTALL="false"

OFFLINE_PKG_PATH=""

#######################################################################

# container runtime config

# if value is docker, then use docker as container runtime

# else if value is containerd, then use containerd as container runtime

#######################################################################

CONTAINER_RUNTIME="docker"

向集群的 control-plane 添加 master 节点

在新节点上执行部署脚本

KUBECUBE_VERSION=v1.4

export CUSTOMIZE="true";curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

设置脚本参数,并按照提示继续运行安装脚本并等待新节点加入 control-plane

- MASTER_IP 需要填已有的 master 节点 ip

- NODE_MODE 当该模式为 node-join-control-plane 时,需要指定 master 节点们的 CONTROL_PLANE_ENDPOINT(vip)

- CONTROL_PLANE_ENDPOINT 为高可用 vip

- 可以根据需要选择适合自己的 ssh 方式

# if install kubecube on pivot cluster

INSTALL_KUBECUBE_PIVOT="false"

# if install k8s

INSTALL_KUBERNETES="true"

# there are four node mode below:

# "master" : node will be installed as a master of cluster

# "node-join-master" : node will be install as a worker of cluster to join master

# "control-plane-master" : node will be installed as a master to control plane of cluster

# "node-join-control-plane" : node will be installed as a master to join control plane

NODE_MODE="node-join-master"

# zone has two choice

# 1. "cn" : in mainland

# 2. "others" : out of mainland

ZONE="cn"

# k8s version you want to install

# support now is: 1.20.9, 1.19.13, 1.18.20, 1.21.2

KUBERNETES_VERSION="1.20.9"

# +optional

# must be set when NODE_MODE="control-plane-master"

# or "node-join-control-plane"

CONTROL_PLANE_ENDPOINT="" #{ip}:{port} , dns

#######################################################################

# member cluster config

# used when INSTALL_KUBECUBE_MEMBER="true"

#######################################################################

# if install kubecube on member cluster

INSTALL_KUBECUBE_MEMBER="false"

# +optional

# KUBECUBE_HOST must be set when as a member cluster to

# join pivot cluster, the value is pivot node ip

KUBECUBE_HOST=""

# +optional

# must be set when INSTALL_KUBECUBE_MEMBER="true"

# this value is the name of member cluster you

# want to take over

MEMBER_CLUSTER_NAME=""

#######################################################################

# ssh config

# used when NODE_MODE="node-join-master" or node-join-control-plane

#######################################################################

# +optional

# master ip means master node ip of cluster

MASTER_IP="y.y.y.y"

# +optional

# the user who can access master node, it can be empty

SSH_USER="root"

# +optional

# the port specified to access master node, it can be empty

SSH_PORT=22

# +optional

# must be empty when ACCESS_PRIVATE_KEY_PATH set

# password for master user to access master node

ACCESS_PASSWORD=""

# +optional

# must be empty when ACCESS_PASSWORD set

# ACCESS_PRIVATE_KEY for master user to access master node

ACCESS_PRIVATE_KEY_PATH="/root/.ssh/id_rsa"

#######################################################################

# offline config

# used when offline install choose, must lift offline pkg first

#######################################################################

OFFLINE_INSTALL="false"

OFFLINE_PKG_PATH=""

#######################################################################

# container runtime config

# if value is docker, then use docker as container runtime

# else if value is containerd, then use containerd as container runtime

#######################################################################

CONTAINER_RUNTIME="containerd"

v1.2.x

向集群添加工作节点

在新节点上执行部署脚本

KUBECUBE_VERSION=v1.2

export CUSTOMIZE="true";curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

设置脚本参数,并按照提示继续运行安装脚本并等待新节点加入集群

- MASTER_IP 为 master 节点 ip

# if install kubecube on pivot cluster

INSTALL_KUBECUBE_PIVOT="false"

# if install k8s

INSTALL_KUBERNETES="true"

# k8s cni, support now is calico only

CNI="calico"

# there are four node mode below:

# "master" : node will be installed as a master of cluster

# "node-join-master" : node will be install as a worker of cluster to join master

# "control-plane-master" : node will be installed as a master to control plane of cluster

# "node-join-control-plane" : node will be installed as a master to join control plane

NODE_MODE="node-join-master"

# zone has two choice

# 1. "cn" : in mainland

# 2. "others" : out of mainland

ZONE="cn"

# k8s version you want to install

# support now is: 1.19.13, 1.20.9, 1.21.2, 1.22.2, 1.23.5

KUBERNETES_VERSION="1.23.5"

# +optional

# must be set when NODE_MODE="control-plane-master"

# or "node-join-control-plane"

CONTROL_PLANE_ENDPOINT="" #{ip}:{port} , dns

# +optional

# KUBERNETES_BIND_ADDRESS generally is node_ip

# can be set when NODE_MODE="master" ot "control-plane-master"

# default value is $(hostname -I |awk '{print $1}')

KUBERNETES_BIND_ADDRESS="" #{node_ip}

#######################################################################

# member cluster config

# used when INSTALL_KUBECUBE_MEMBER="true"

#######################################################################

# if install kubecube on member cluster

INSTALL_KUBECUBE_MEMBER="false"

# +optional

# KUBECUBE_HOST must be set when as a member cluster to

# join pivot cluster, the value is pivot node ip

KUBECUBE_HOST=""

# +optional

# must be set when INSTALL_KUBECUBE_MEMBER="true"

# this value is the name of member cluster you

# want to take over

MEMBER_CLUSTER_NAME=""

#######################################################################

# ssh config

# used when NODE_MODE="node-join-master" or node-join-control-plane

#######################################################################

# +optional

# master ip means master node ip of cluster

MASTER_IP=""

# +optional

# the user who can access master node, it can be empty

SSH_USER="root"

# +optional

# the port specified to access master node, it can be empty

SSH_PORT=22

# +optional

# must be empty when ACCESS_PRIVATE_KEY_PATH set

# password for master user to access master node

ACCESS_PASSWORD=""

# +optional

# must be empty when ACCESS_PASSWORD set

# ACCESS_PRIVATE_KEY for master user to access master node

ACCESS_PRIVATE_KEY_PATH="/root/.ssh/id_rsa"

#######################################################################

# offline config

# used when offline install choose, must lift offline pkg first

#######################################################################

OFFLINE_INSTALL="false"

OFFLINE_PKG_PATH=""

#######################################################################

# container runtime config

# if value is docker, then use docker as container runtime

# else if value is containerd, then use containerd as container runtime

#######################################################################

CONTAINER_RUNTIME="containerd"

向集群的 control-plane 添加 master 节点

在新节点上执行部署脚本

KUBECUBE_VERSION=v1.2

export CUSTOMIZE="true";curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

设置脚本参数,并按照提示继续运行安装脚本并等待新节点加入 control-plane

- MASTER_IP 需要填已有的 master 节点 ip

- NODE_MODE 当该模式为 node-join-control-plane 时,需要指定 master 节点们的 CONTROL_PLANE_ENDPOINT(vip)

- CONTROL_PLANE_ENDPOINT 为高可用 vip

- 可以根据需要选择适合自己的 ssh 方式

# if install kubecube on pivot cluster

INSTALL_KUBECUBE_PIVOT="false"

# if install k8s

INSTALL_KUBERNETES="true"

# there are four node mode below:

# "master" : node will be installed as a master of cluster

# "node-join-master" : node will be install as a worker of cluster to join master

# "control-plane-master" : node will be installed as a master to control plane of cluster

# "node-join-control-plane" : node will be installed as a master to join control plane

NODE_MODE="node-join-master"

# zone has two choice

# 1. "cn" : in mainland

# 2. "others" : out of mainland

ZONE="cn"

# k8s version you want to install

# support now is: 1.20.9, 1.19.13, 1.18.20, 1.21.2

KUBERNETES_VERSION="1.20.9"

# +optional

# must be set when NODE_MODE="control-plane-master"

# or "node-join-control-plane"

CONTROL_PLANE_ENDPOINT="" #{ip}:{port} , dns

#######################################################################

# member cluster config

# used when INSTALL_KUBECUBE_MEMBER="true"

#######################################################################

# if install kubecube on member cluster

INSTALL_KUBECUBE_MEMBER="false"

# +optional

# KUBECUBE_HOST must be set when as a member cluster to

# join pivot cluster, the value is pivot node ip

KUBECUBE_HOST=""

# +optional

# must be set when INSTALL_KUBECUBE_MEMBER="true"

# this value is the name of member cluster you

# want to take over

MEMBER_CLUSTER_NAME=""

#######################################################################

# ssh config

# used when NODE_MODE="node-join-master" or node-join-control-plane

#######################################################################

# +optional

# master ip means master node ip of cluster

MASTER_IP="y.y.y.y"

# +optional

# the user who can access master node, it can be empty

SSH_USER="root"

# +optional

# the port specified to access master node, it can be empty

SSH_PORT=22

# +optional

# must be empty when ACCESS_PRIVATE_KEY_PATH set

# password for master user to access master node

ACCESS_PASSWORD=""

# +optional

# must be empty when ACCESS_PASSWORD set

# ACCESS_PRIVATE_KEY for master user to access master node

ACCESS_PRIVATE_KEY_PATH="/root/.ssh/id_rsa"

#######################################################################

# offline config

# used when offline install choose, must lift offline pkg first

#######################################################################

OFFLINE_INSTALL="false"

OFFLINE_PKG_PATH=""

#######################################################################

# container runtime config

# if value is docker, then use docker as container runtime

# else if value is containerd, then use containerd as container runtime

#######################################################################

CONTAINER_RUNTIME="containerd"

v1.1.x

向集群添加工作节点

在新节点上执行部署脚本

KUBECUBE_VERSION=v1.1

export CUSTOMIZE="true";curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

tip: 你可以通过预先下载离线包和镜像来减少部署时间

export PRE_DOWNLOAD="true";curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

设置脚本参数,并按照提示继续运行安装脚本并等待新节点加入集群

- MASTER_IP 为 master 节点 ip

# if install kubecube on pivot cluster

INSTALL_KUBECUBE_PIVOT="false"

# if install k8s

INSTALL_KUBERNETES="true"

# there are four node mode below:

# "master" : node will be installed as a master of cluster

# "node-join-master" : node will be install as a worker of cluster to join master

# "control-plane-master" : node will be installed as a master to control plane of cluster

# "node-join-control-plane" : node will be installed as a master to join control plane

NODE_MODE="node-join-master"

# zone has two choice

# 1. "cn" : in mainland

# 2. "others" : out of mainland

ZONE="cn"

# k8s version you want to install

# support now is: 1.20.9, 1.19.13, 1.18.20, 1.21.2

KUBERNETES_VERSION="1.20.9"

# +optional

# must be set when NODE_MODE="control-plane-master"

# or "node-join-control-plane"

CONTROL_PLANE_ENDPOINT="" #{ip}:{port} , dns

#######################################################################

# member cluster config

# used when INSTALL_KUBECUBE_MEMBER="true"

#######################################################################

# if install kubecube on member cluster

INSTALL_KUBECUBE_MEMBER="false"

# +optional

# KUBECUBE_HOST must be set when as a member cluster to

# join pivot cluster, the value is pivot node ip

KUBECUBE_HOST=""

# +optional

# must be set when INSTALL_KUBECUBE_MEMBER="true"

# this value is the name of member cluster you

# want to take over

MEMBER_CLUSTER_NAME=""

#######################################################################

# ssh config

# used when NODE_MODE="node-join-master" or node-join-control-plane

#######################################################################

# +optional

# master ip means master node ip of cluster

MASTER_IP="y.y.y.y"

# +optional

# the user who can access master node, it can be empty

SSH_USER="root"

# +optional

# the port specified to access master node, it can be empty

SSH_PORT=22

# +optional

# must be empty when ACCESS_PRIVATE_KEY_PATH set

# password for master user to access master node

ACCESS_PASSWORD=""

# +optional

# must be empty when ACCESS_PASSWORD set

# ACCESS_PRIVATE_KEY for master user to access master node

ACCESS_PRIVATE_KEY_PATH="/root/.ssh/id_rsa"

#######################################################################

# offline config

# used when offline install choose, must lift offline pkg first

#######################################################################

OFFLINE_INSTALL="false"

OFFLINE_PKG_PATH=""

向集群的 control-plane 添加 master 节点

在新节点上执行部署脚本

KUBECUBE_VERSION=v1.1

export CUSTOMIZE="true";curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

设置脚本参数,并按照提示继续运行安装脚本并等待新节点加入 control-plane

- MASTER_IP 需要填已有的 master 节点 ip

- NODE_MODE 当该模式为 node-join-control-plane 时,需要指定 master 节点们的 CONTROL_PLANE_ENDPOINT(vip)

- CONTROL_PLANE_ENDPOINT 为高可用 vip

- 可以根据需要选择适合自己的 ssh 方式

# if install kubecube on pivot cluster

INSTALL_KUBECUBE_PIVOT="false"

# if install k8s

INSTALL_KUBERNETES="true"

# there are four node mode below:

# "master" : node will be installed as a master of cluster

# "node-join-master" : node will be install as a worker of cluster to join master

# "control-plane-master" : node will be installed as a master to control plane of cluster

# "node-join-control-plane" : node will be installed as a master to join control plane

NODE_MODE="node-join-master"

# zone has two choice

# 1. "cn" : in mainland

# 2. "others" : out of mainland

ZONE="cn"

# k8s version you want to install

# support now is: 1.20.9, 1.19.13, 1.18.20, 1.21.2

KUBERNETES_VERSION="1.20.9"

# +optional

# must be set when NODE_MODE="control-plane-master"

# or "node-join-control-plane"

CONTROL_PLANE_ENDPOINT="" #{ip}:{port} , dns

#######################################################################

# member cluster config

# used when INSTALL_KUBECUBE_MEMBER="true"

#######################################################################

# if install kubecube on member cluster

INSTALL_KUBECUBE_MEMBER="false"

# +optional

# KUBECUBE_HOST must be set when as a member cluster to

# join pivot cluster, the value is pivot node ip

KUBECUBE_HOST=""

# +optional

# must be set when INSTALL_KUBECUBE_MEMBER="true"

# this value is the name of member cluster you

# want to take over

MEMBER_CLUSTER_NAME=""

#######################################################################

# ssh config

# used when NODE_MODE="node-join-master" or node-join-control-plane

#######################################################################

# +optional

# master ip means master node ip of cluster

MASTER_IP="y.y.y.y"

# +optional

# the user who can access master node, it can be empty

SSH_USER="root"

# +optional

# the port specified to access master node, it can be empty

SSH_PORT=22

# +optional

# must be empty when ACCESS_PRIVATE_KEY_PATH set

# password for master user to access master node

ACCESS_PASSWORD=""

# +optional

# must be empty when ACCESS_PASSWORD set

# ACCESS_PRIVATE_KEY for master user to access master node

ACCESS_PRIVATE_KEY_PATH="/root/.ssh/id_rsa"

#######################################################################

# offline config

# used when offline install choose, must lift offline pkg first

#######################################################################

OFFLINE_INSTALL="false"

OFFLINE_PKG_PATH=""

v1.0.x

向集群添加工作节点

在新节点上执行部署脚本

KUBECUBE_VERSION=v1.0

export CUSTOMIZE="true";curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

tip: 你可以通过预先下载离线包和镜像来减少部署时间

export PRE_DOWNLOAD="true";curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

设置脚本参数,并按照提示继续运行安装脚本并等待新节点加入集群

- MASTER_IP 为 master 节点 ip

# if install kubecube on pivot cluster

INSTALL_KUBECUBE_PIVOT="false"

# if install kubecube on member cluster

INSTALL_KUBECUBE_MEMBER="false"

# if install k8s

INSTALL_KUBERNETES="true"

# there are four node mode below:

# "master" : node will be installed as a master of cluster

# "node-join-master" : node will be install as a worker of cluster to join master

# "control-plane-master" : node will be installed as a master to control plane of cluster

# "node-join-control-plane" : node will be installed as a master to join control plane

NODE_MODE="node-join-master"

# +optional

# must be set when INSTALL_KUBECUBE_MEMBER="true"

# this value is the name of member cluster you

# want to take over

MEMBER_CLUSTER_NAME=""

# +optional

# must be set when NODE_MODE="control-plane-master"

# or "node-join-control-plane"

CONTROL_PLANE_ENDPOINT="" #{ip}:{port} , dns

# master ip means master node ip of cluster

MASTER_IP="10.173.32.4"

# +optional

# KUBECUBE_HOST must be set when as a member cluster to

# join pivot cluster, the value is pivot node ip

KUBECUBE_HOST=""

# zone has two choice

# 1. "cn" : in mainland

# 2. "others" : out of mainland

ZONE="cn"

# k8s version you want to install

KUBERNETES_VERSION="1.20.9"

# +optional

# the user who can access master node, it can be empty

# when NODE_MODE="master" or "control-plane-master"

SSH_USER="root"

# +optional

# the port specified to access master node, it can be empty

# when NODE_MODE="master" or "control-plane-master"

SSH_PORT=22

# +optional

# must be empty when ACCESS_PRIVATE_KEY_PATH set

# password for master user to access master node

ACCESS_PASSWORD=""

# +optional

# must be empty when ACCESS_PASSWORD set

# ACCESS_PRIVATE_KEY for master user to access master node

ACCESS_PRIVATE_KEY_PATH="/root/.ssh/id_rsa"

向集群的 control-plane 添加 master 节点

在新节点上执行部署脚本

KUBECUBE_VERSION=v1.0

export CUSTOMIZE="true";curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

设置脚本参数,并按照提示继续运行安装脚本并等待新节点加入 control-plane

- MASTER_IP 需要填已有的 master 节点 ip

- CONTROL_PLANE_ENDPOINT 为高可用 vip

# if install kubecube on pivot cluster

INSTALL_KUBECUBE_PIVOT="false"

# if install kubecube on member cluster

INSTALL_KUBECUBE_MEMBER="false"

# if install k8s

INSTALL_KUBERNETES="true"

# there are four node mode below:

# "master" : node will be installed as a master of cluster

# "node-join-master" : node will be install as a worker of cluster to join master

# "control-plane-master" : node will be installed as a master to control plane of cluster

# "node-join-control-plane" : node will be installed as a master to join control plane

NODE_MODE="node-join-control-plane"

# +optional

# must be set when INSTALL_KUBECUBE_MEMBER="true"

# this value is the name of member cluster you

# want to take over

MEMBER_CLUSTER_NAME=""

# +optional

# must be set when NODE_MODE="control-plane-master"

# or "node-join-control-plane"

CONTROL_PLANE_ENDPOINT="10.173.32.10" #{ip}:{port} , dns

# master ip means master node ip of cluster

MASTER_IP="10.173.32.4"

# +optional

# KUBECUBE_HOST must be set when as a member cluster to

# join pivot cluster, the value is pivot node ip

KUBECUBE_HOST=""

# zone has two choice

# 1. "cn" : in mainland

# 2. "others" : out of mainland

ZONE="cn"

# k8s version you want to install

KUBERNETES_VERSION="1.20.9"

# +optional

# the user who can access master node, it can be empty

# when NODE_MODE="master" or "control-plane-master"

SSH_USER="root"

# +optional

# the port specified to access master node, it can be empty

# when NODE_MODE="master" or "control-plane-master"

SSH_PORT=22

# +optional

# must be empty when ACCESS_PRIVATE_KEY_PATH set

# password for master user to access master node

ACCESS_PASSWORD=""

# +optional

# must be empty when ACCESS_PASSWORD set

# ACCESS_PRIVATE_KEY for master user to access master node

ACCESS_PRIVATE_KEY_PATH="/root/.ssh/id_rsa"

3.5.4 - 多节点高可用部署

本文提供 Kubernetes 的高可用部署和 KubeCube 的高可用部署方案,VIP 的实现需要用户自行提供

v1.4.x

主机规划

| IP 地址 | 主机名 | 角色 |

|---|---|---|

| 10.173.32.2 | lb1 | Keepalived & HAproxy |

| 10.173.32.3 | lb2 | Keepalived & HAproxy |

| 10.173.32.4 | master1 | master, etcd |

| 10.173.32.5 | master2 | master, etcd |

| 10.173.32.6 | master3 | master, etcd |

| 10.173.32.7 | worker1 | worker |

| 10.173.32.8 | worker2 | worker |

| 10.173.32.9 | worker3 | worker |

| 10.173.32.10 | vip 地址 |

⚠️master2、master3、worker1、worker2、worker3 需要能够通过密钥或者密码 ssh 访问 master1

部署高可用 Kubernetes

KubeCube 部署脚本提供部署高可用 k8s 的能力,当然,你也可以使用其他工具搭建高可用的 k8s 集群

开始安装

在 master1 上执行部署脚本

KUBECUBE_VERSION=v1.4

export CUSTOMIZE="true";curl -fsSL https://kubecube.nos-eastchina1.126.net/kubecube-installer/${KUBECUBE_VERSION}/entry.sh | bash

设置脚本参数,并按照提示继续运行安装脚本并等待 Kubernetes 安装完成,master2 和 master3 加入 control-plane 的方式与之相同

- CONTROL_PLANE_ENDPOINT 为高可用 k8s-apiserver 的 vip,在此我们用任意 master 节点的 ip 代替

# if install kubecube on pivot cluster

INSTALL_KUBECUBE_PIVOT="false"

# if install k8s

INSTALL_KUBERNETES="true"

# k8s cni, support now is calico only

CNI="calico"

# there are four node mode below:

# "master" : node will be installed as a master of cluster

# "node-join-master" : node will be install as a worker of cluster to join master

# "control-plane-master" : node will be installed as a master to control plane of cluster

# "node-join-control-plane" : node will be installed as a master to join control plane

NODE_MODE="control-plane-master"

# zone has two choice

# 1. "cn" : in mainland

# 2. "others" : out of mainland

ZONE="cn"

# k8s version you want to install

# support now is: 1.19.13, 1.20.9, 1.21.2, 1.22.2, 1.23.5

KUBERNETES_VERSION="1.23.5"

# +optional

# must be set when NODE_MODE="control-plane-master"

# or "node-join-control-plane"

CONTROL_PLANE_ENDPOINT="10.173.32.4" #{ip}:{port} , dns

# +optional

# KUBERNETES_BIND_ADDRESS generally is node_ip

# can be set when NODE_MODE="master" ot "control-plane-master"

# default value is $(hostname -I |awk '{print $1}')

KUBERNETES_BIND_ADDRESS="" #{node_ip}

#######################################################################

# member cluster config

# used when INSTALL_KUBECUBE_MEMBER="true"

#######################################################################

# if install kubecube on member cluster

INSTALL_KUBECUBE_MEMBER="false"

# +optional

# KUBECUBE_HOST must be set when as a member cluster to

# join pivot cluster, the value is pivot node ip

KUBECUBE_HOST=""

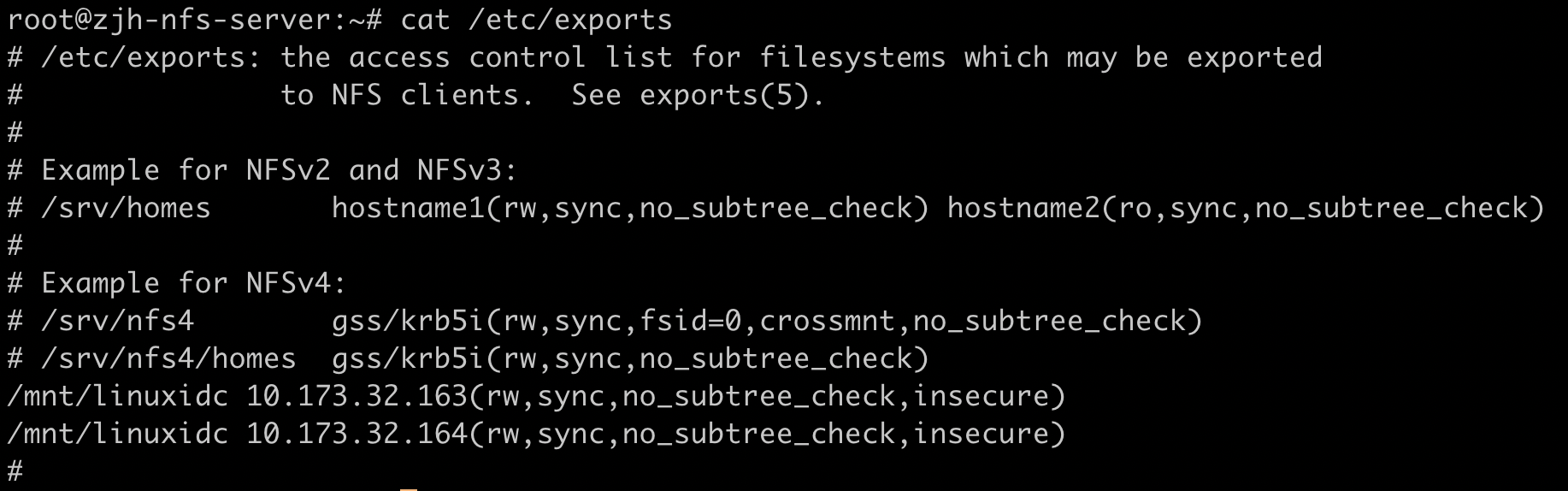

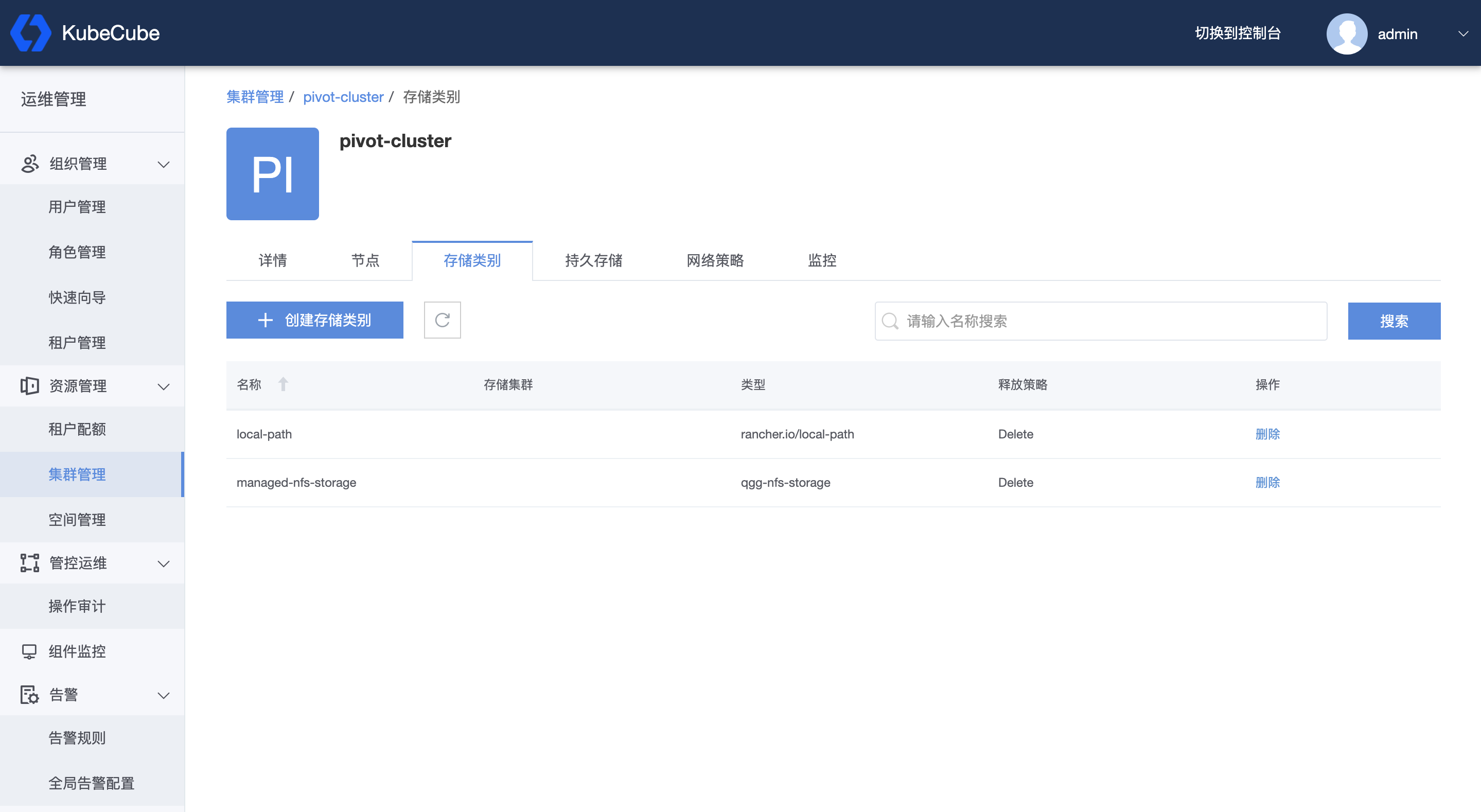

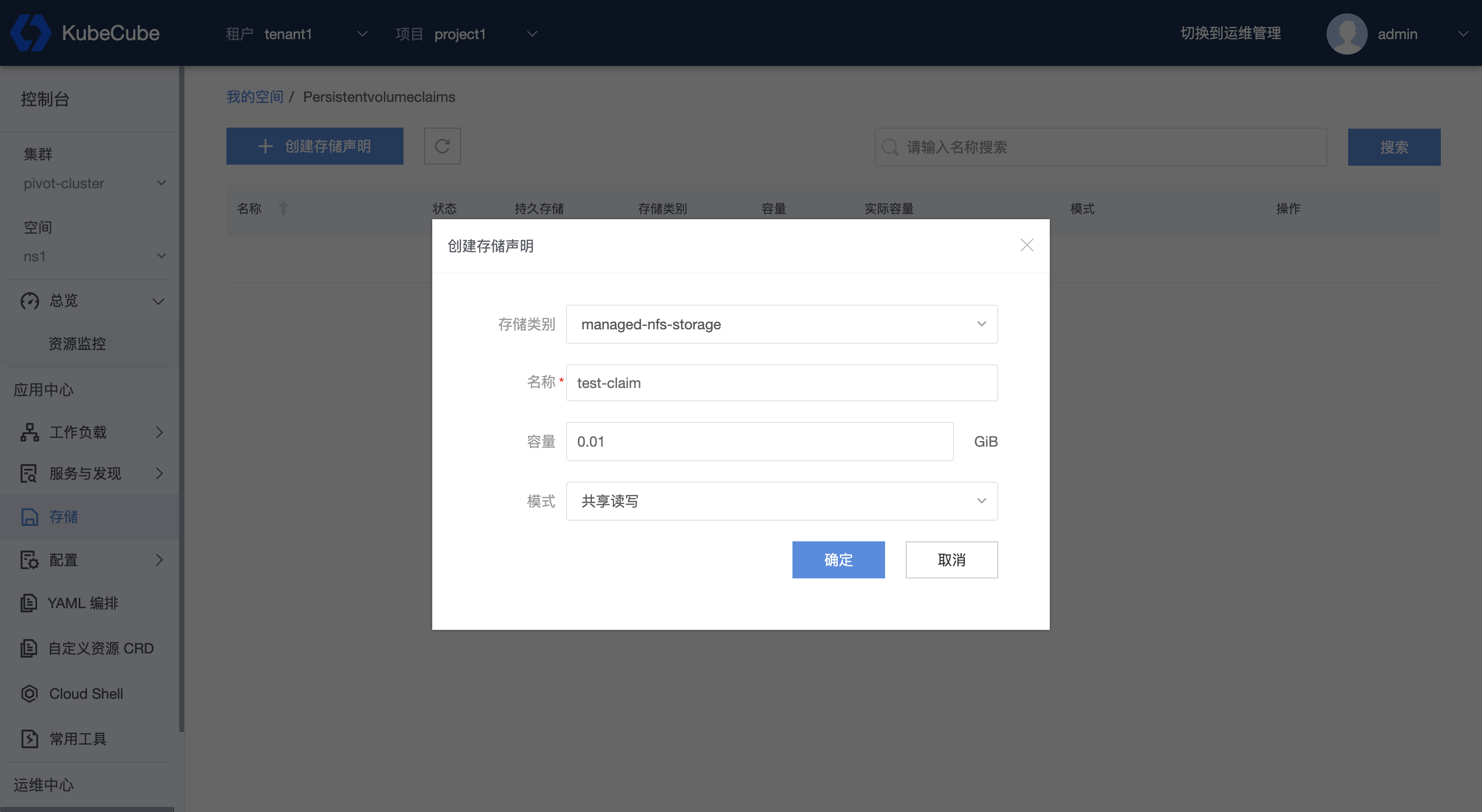

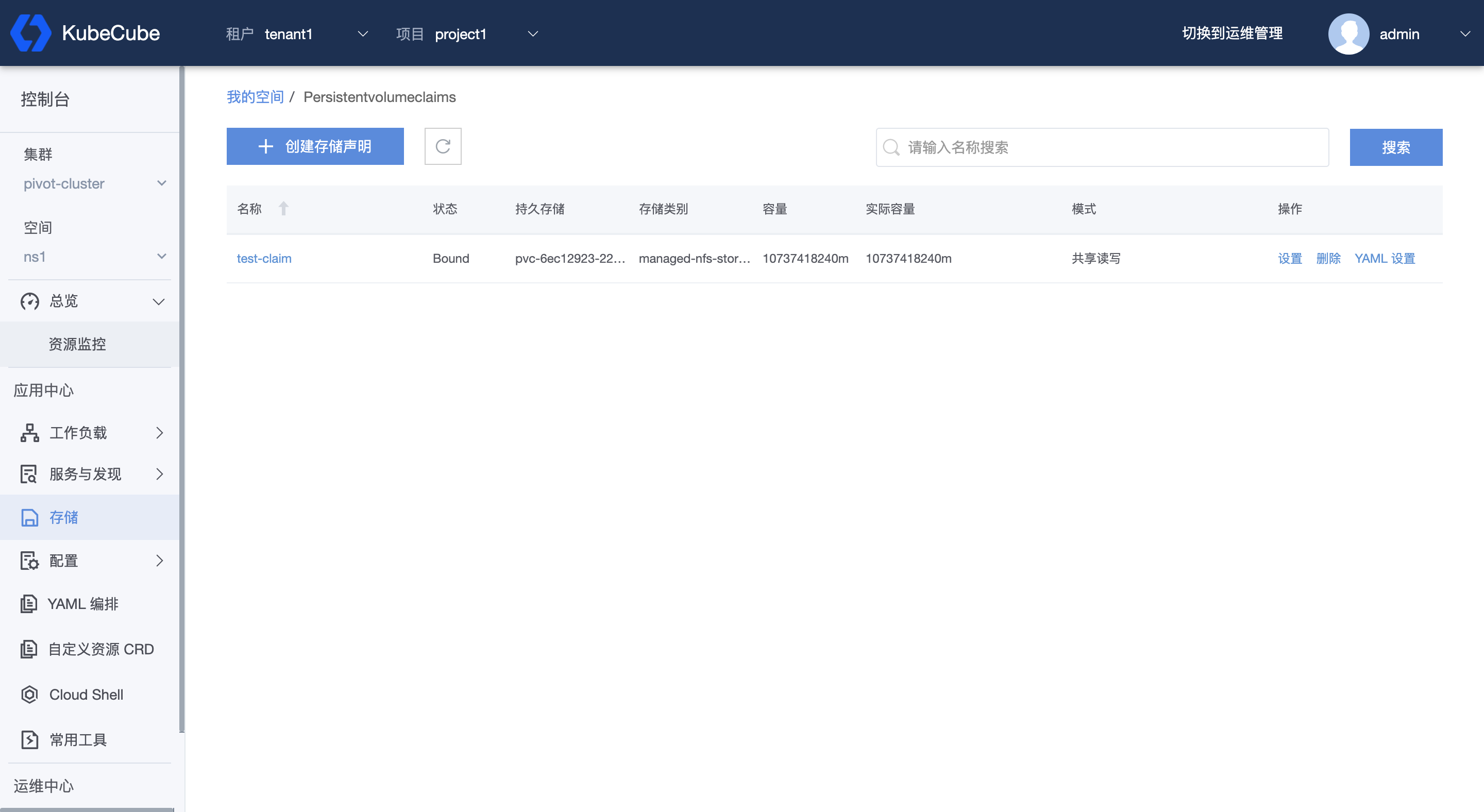

# +optional